当AI学会用导演视角解构影像,影视工业将迎来认知革命!斯坦福联合CMU等顶尖机构推出CameraBench,为AI开设「镜头语言大师课」,直击多模态理解最硬核痛点。

论文核心发现:「现有AI模型镜头运动识别准确率不足37%」

【认知鸿沟:AI为何读不懂镜头语言】

三大理解障碍:

1. 参照系混乱:无人机俯冲被误判为「向下」而非「向前」

2. 术语混淆:物理推拉镜头 vs 光学变焦

3. 运动复合:现实场景存在83%复合运镜

经典案例对比:

• 希区柯克式「滑动变焦」制造眩晕张力

• 《侏罗纪公园》仰拍平移营造史诗感

• Vlog「跟焦运镜」强化临场体验

【传统方法双困局】

几何学派 vs 语言学派:

- SfM/SLAM:动态场景误判率>68%

- VLM模型:运动量化误差达±15°

- 致命缺陷:均无法解析运镜叙事意图

研究者比喻:「就像让数学家鉴赏蒙娜丽莎,专业错配必然失真」

【CameraBench解码方案】

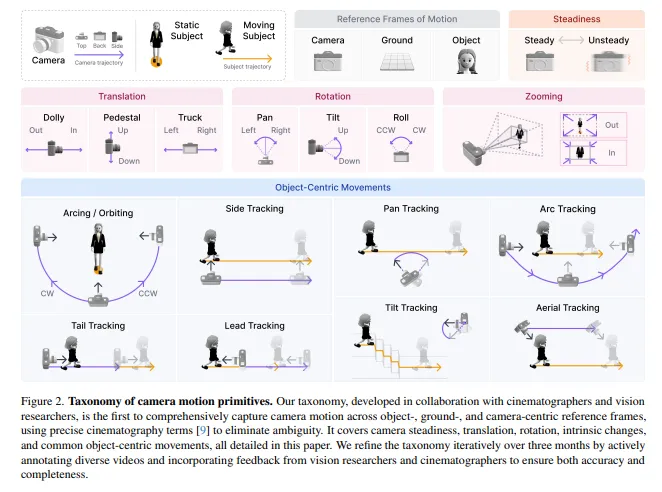

构建三维认知框架:

1. 运动坐标系:物体/地面/相机三重参照系

2. 标准术语库:涵盖9大类47子类运镜方式

3. 意图标注:解析「为什么这样拍」

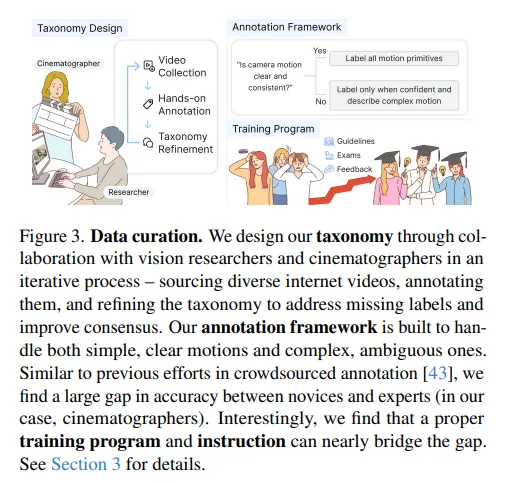

数据标注三大创新:

• 3000+全场景视频切片

• 20小时标注员特训机制

• 双维度标注:技术参数+叙事意图

【实测验证:主流模型集体翻车】

关键测试结果:

- GPT-4o运镜分类准确率29.7%

- Gemini视频描述63%存在方向误判

- 传统SLAM在动态场景误差超200%

突破性发现:

• AI对「环绕运镜」识别率最低(12.3%)

• 「推拉镜头」与「变焦」混淆率达78%

• 仅有4.2%模型能解析运镜情感表达

项目负责人坦言:「这相当于给AI装上导演思维,是影像理解的登月工程」

【产业启示录】

技术落地三大场景:

1. 智能剪辑:自动匹配「情绪运镜」库

2. VR影视:实现镜头语言自适应

3. 视频生成:规避「违反物理规律」的运镜

随着CameraBench开源,这场针对AI的「镜头语言启蒙运动」,正在重塑影像科技的认知边界。当机器开始理解运镜的呼吸与心跳,真正的智能影像时代或将到来。