小米人工智能实验室近日发布自研声音理解大模型MiDashengLM-7B,并宣布全面开源。这一重要进展标志着小米在多模态AI领域的技术突破,也为全球开发者提供了强大的工具支持。

根据官方数据,该模型性能表现突出:

- 单样本首Token延迟仅为同类模型的25%

- 相同显存条件下,并发处理能力提升20倍以上

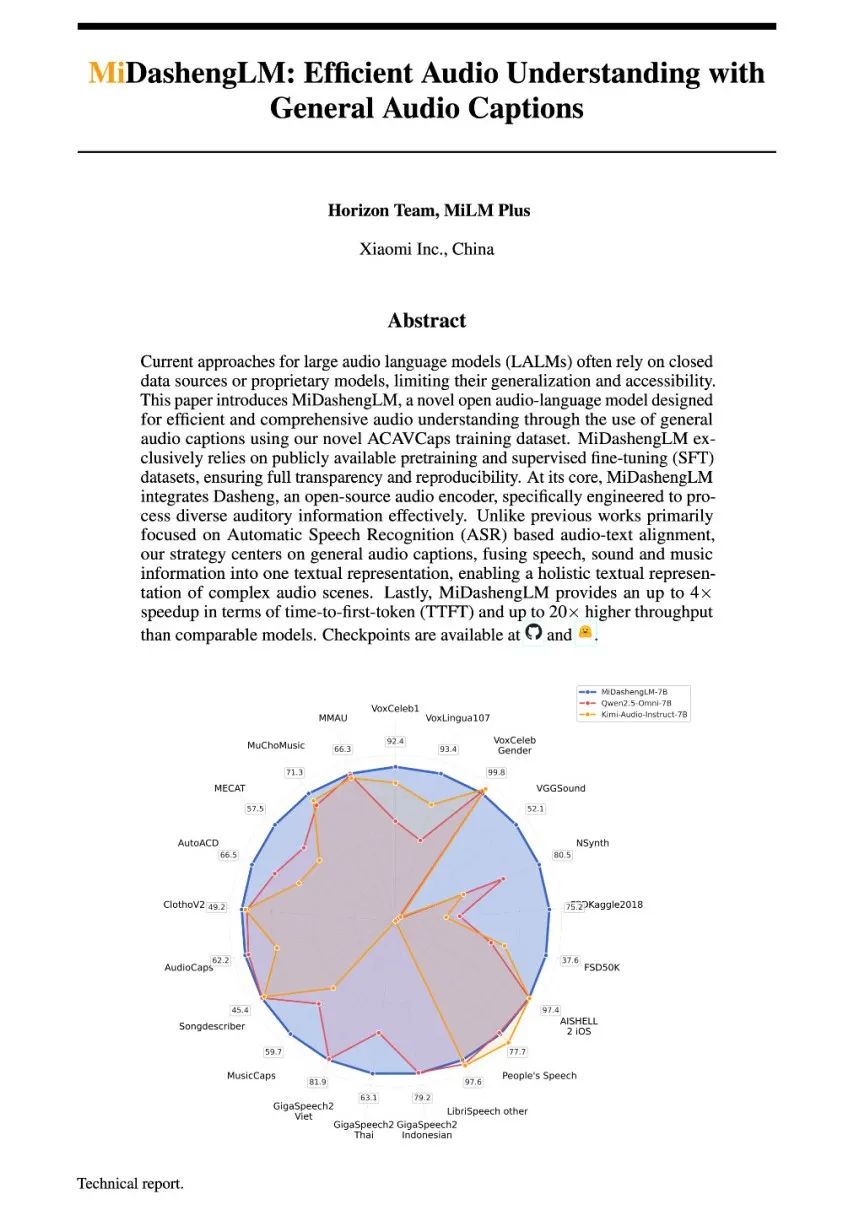

在22个公开评测集中,该模型刷新了语音、环境音与音乐理解的多项纪录,达到当前行业最高水平(SOTA)。

技术架构方面,模型采用两大核心组件:

- 音频编码器:Xiaomi Dasheng

- 自回归解码器:Qwen2.5-Omni-7B Thinker

通过创新的通用音频描述训练策略,模型实现了三大能力突破:

- 识别"说了什么"

- 理解"发生了什么"

- 分析"为何发生"

值得一提的是,Xiaomi Dasheng技术早在2024年就取得重大突破:

- AudioSet测试突破50+ mAP

- HEAR Benchmark三大维度持续领先

目前该技术已落地30+实际场景,典型应用包括:

- 智能家居异常声音监测

- 车载"响指联动IoT设备"功能

- 小米YU7车型的划车声识别

重要提示:模型训练数据全部来自公开资源,采用Apache License 2.0协议,支持商用。

小米还公开了77个数据源构成比例,并完整披露了从预训练到微调的全流程,展现出极高的技术透明度。

未来规划方面,小米将重点优化:

- 终端设备离线部署

- 基于自然语言的声音编辑功能

开发者可通过以下资源获取模型:

- GitHub主页:https://github.com/xiaomi-research/dasheng-lm

- 技术报告:https://github.com/xiaomi-research/dasheng-lm/tree/main/technical_report

- 模型参数(Hugging Face):https://huggingface.co/mispeech/midashenglm-7b

- 模型参数(魔搭社区):https://modelscope.cn/models/midasheng/midashenglm-7b

- 网页Demo:https://xiaomi-research.github.io/dasheng-lm

- 交互Demo:https://huggingface.co/spaces/mispeech/MiDashengLM