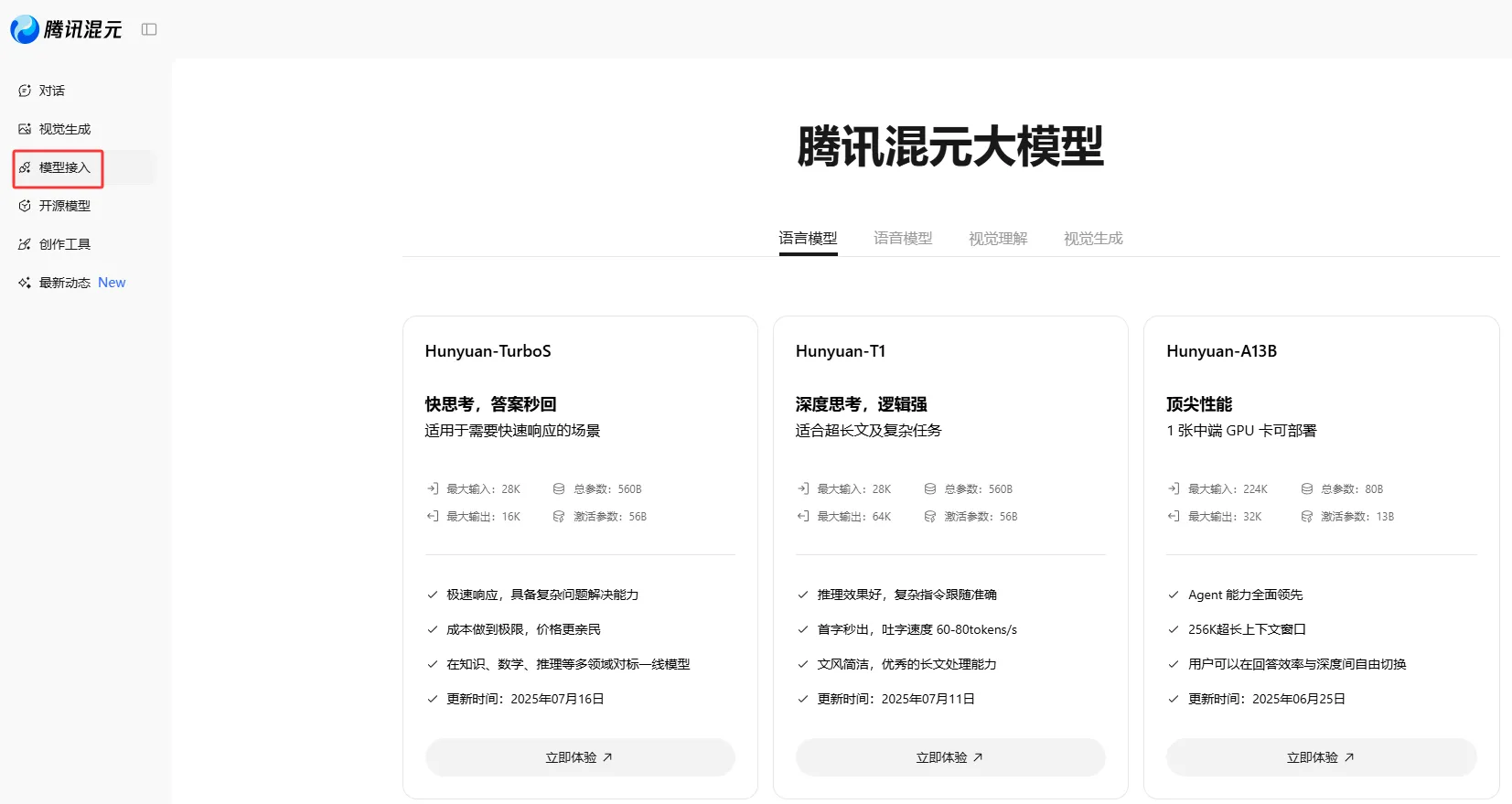

腾讯混元团队近日正式开源四款经过精心优化的AI大模型,现已全面登陆GitHub与Hugging Face平台。这四款模型参数规模分别为0.5B、1.8B、4B和7B,其中最小的0.5B版本甚至能在普通手机CPU上流畅运行。这意味着,只要拥有一台配备独立显卡的笔记本,或一部高通骁龙8系旗舰手机,就能将强大的AI模型装进口袋,彻底摆脱云端服务的排队等待。

开发者必看的三大优势

1. 本地运行轻松实现

根据官方测试数据,仅需一张RTX3060笔记本显卡,就能流畅运行7B版本模型;而1.8B版本可在主流Arm架构手机上实现离线推理,功耗表现优异,日常使用毫无压力。

2. 微调门槛显著降低

不再需要昂贵的A100集群,开发者仅需几百条业务数据,借助LoRA技术就能完成模型微调,整个过程最快仅需几十分钟,大幅降低了垂直领域应用的开发成本。

3. 智能双模式响应

模型支持「快思考」与「慢思考」两种模式:处理简单指令时启动快思考模式,实现毫秒级响应;遇到复杂任务则自动切换至慢思考模式,通过多步推理确保结果准确性。

两大核心亮点直击用户痛点

强大的Agent能力

无论是编写Excel宏、规划旅行路线,还是调用搜索/地图/支付接口,该模型都能像人类一样拆解任务、制定计划并自主纠错。实测显示,其任务完成率显著优于同级开源模型。

256k超长上下文支持

可一次性处理约40万汉字内容,输入整本《三体》后,不仅能记住人物关系和情节脉络,还能基于原著设定续写精彩故事。

腾讯内部多场景应用实例

- 腾讯会议AI助手:快速解析2小时会议录音,精准提炼要点与待办事项

- 微信读书智能问答:整本书内容直接输入,提问直达相关段落

- 手机管家智能拦截:本地部署0.5B模型,毫秒级识别垃圾短信

- 车载交互系统:双模型协同工作,主副驾可同时独立对话

三步快速体验指南

- 访问Hugging Face搜索「Tencent-Hunyuan」,选择参数版本

- 通过pip安装依赖,或直接拉取Docker镜像

- 有显卡用户推荐使用vLLM或TensorRT-LLM加速,手机端可用llama.cpp量化至2bit运行

官网入口:腾讯混元大模型官网

GitHub资源:

Hunyuan-0.5B:https://github.com/Tencent-Hunyuan/Hunyuan-0.5B

Hunyuan-1.8B:https://github.com/Tencent-Hunyuan/Hunyuan-1.8B

Hunyuan-4B:https://github.com/Tencent-Hunyuan/Hunyuan-4B

Hunyuan-7B:https://github.com/Tencent-Hunyuan/Hunyuan-7B

HuggingFace资源:

Hunyuan-0.5B:https://huggingface.co/tencent/Hunyuan-0.5B-Instruct

Hunyuan-1.8B:https://huggingface.co/tencent/Hunyuan-1.8B-Instruct

Hunyuan-4B:https://huggingface.co/tencent/Hunyuan-4B-Instruct

Hunyuan-7B:https://huggingface.co/tencent/Hunyuan-7B-Instruct

敏锐的开发者已开始用其优化成本结构,而观望者还在等待API降价

工具已就位,接下来就看您如何把握这场AI变革机遇。