8日,谷歌旗下AI研究机构正式在GitHub平台开源其最新研发的MolmoAct机器人"行动推理模型"(Action Reasoning Model,ARM)。这款专为具身智能设计的模型,致力于解决机器人在复杂三维环境中的动作规划难题,有望大幅提升智能体的自主决策能力。

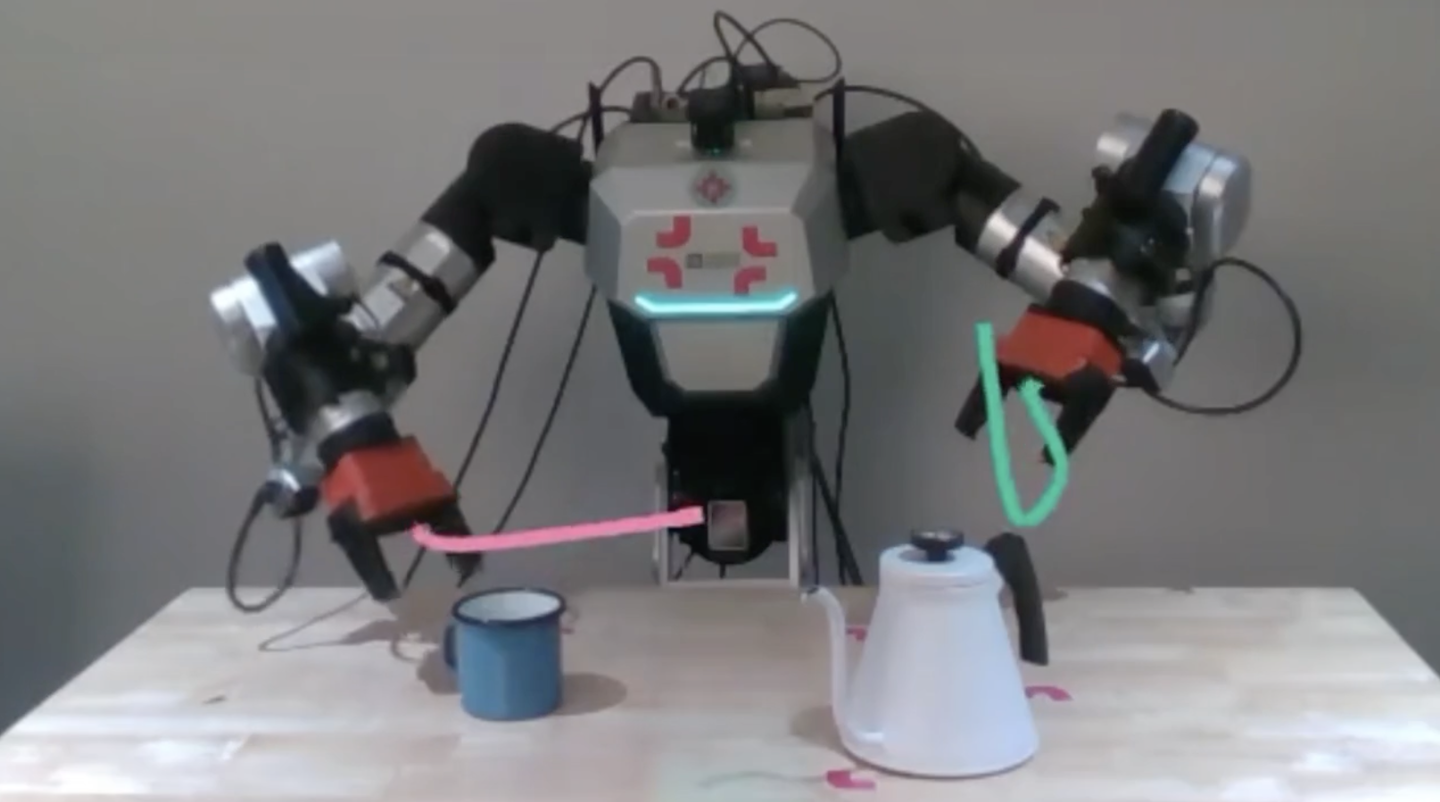

与传统依赖文本指令的视觉语言行动模型(VLA)不同,MolmoAct通过创新的空间感知技术,实现了对物体深度与距离关系的精准捕捉。

该模型采用三阶段处理流程:

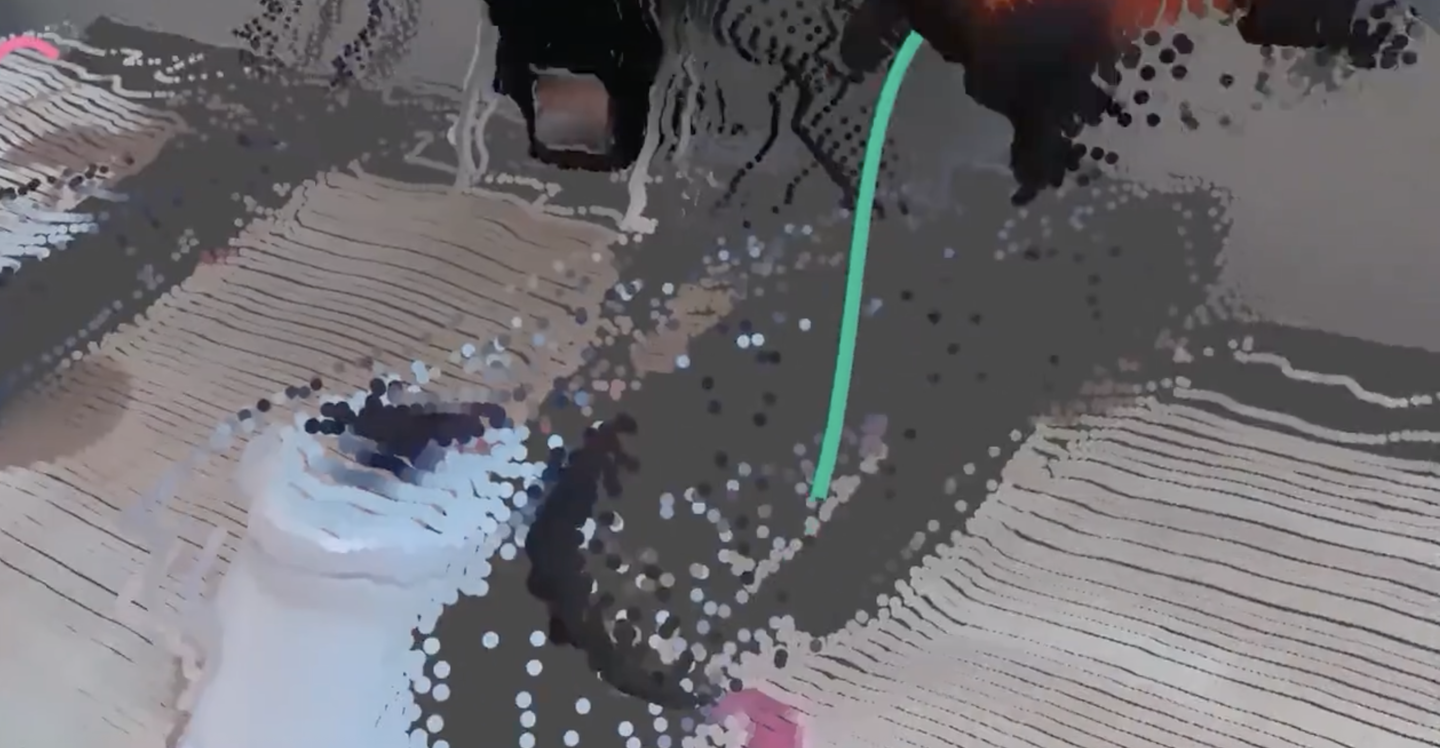

- 第一阶段:通过VQVAE预训练生成具有空间感知的Token,这些Token不仅包含物体几何特征,还精确编码了三维空间位置

- 第二阶段:在图像空间动态生成可视化路径点,清晰展示任务执行轨迹

- 第三阶段:将路径点转化为机器人可执行的底层指令,实现从规划到执行的完整闭环

测试数据显示,MolmoAct-7B在SimplerEnv模拟环境中表现突出:

- 新任务成功率72.1%,超越Physical Intelligence等竞争对手

- LIBERO平台多任务测试中,经微调后成功率提升至86.6%

- 训练效率惊人:预训练仅需256颗H100 GPU/1天,微调仅需64颗H100/2小时

值得注意的是,系统在执行前会将运动轨迹可视化叠加,允许人工审查修正,确保操作安全。

目前项目已在GitHub全面开源(https://github.com/allenai/MolmoAct),包含模型权重、完整代码及工具链。这项开源举措将加速具身智能技术的实际应用落地。