AI领域的竞争正迎来全新转向——从"大而全"迈向"小而精"。就在行业仍痴迷于打造参数更多、算力更强的巨型模型时,一场逆向革命已悄然兴起。

从MIT孵化的Liquid AI公司推出可穿戴设备级视觉模型,到谷歌将Gemini-Nano集成进Pixel手机,边缘智能的边界不断被突破。如今英伟达强势入局,发布全新小型语言模型Nemotron-Nano-9B-v2,这款仅90亿参数的模型不仅性能媲美业界顶尖产品,更首创"可控推理"机制,为AI商业化落地带来突破性进展。

曾经被视为"边缘玩具"的小型模型,正迅速崛起为企业级应用的首选方案。

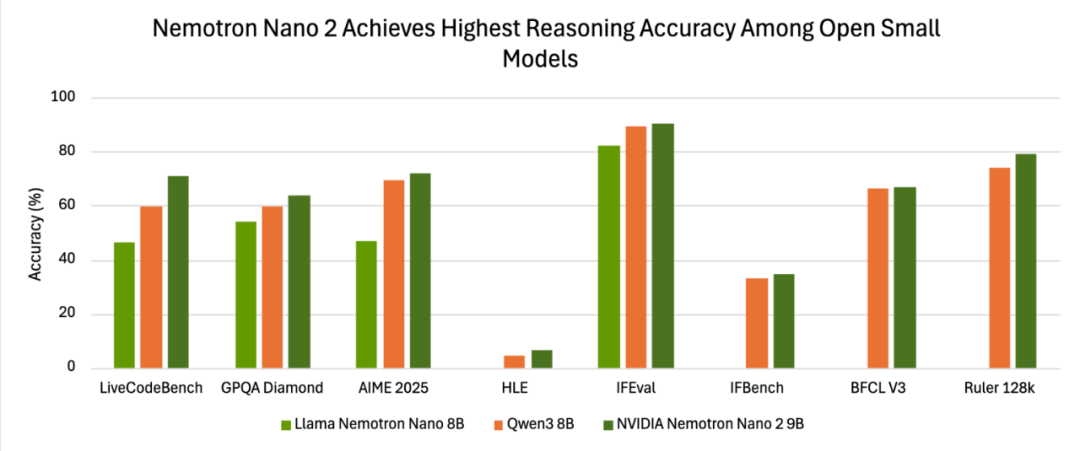

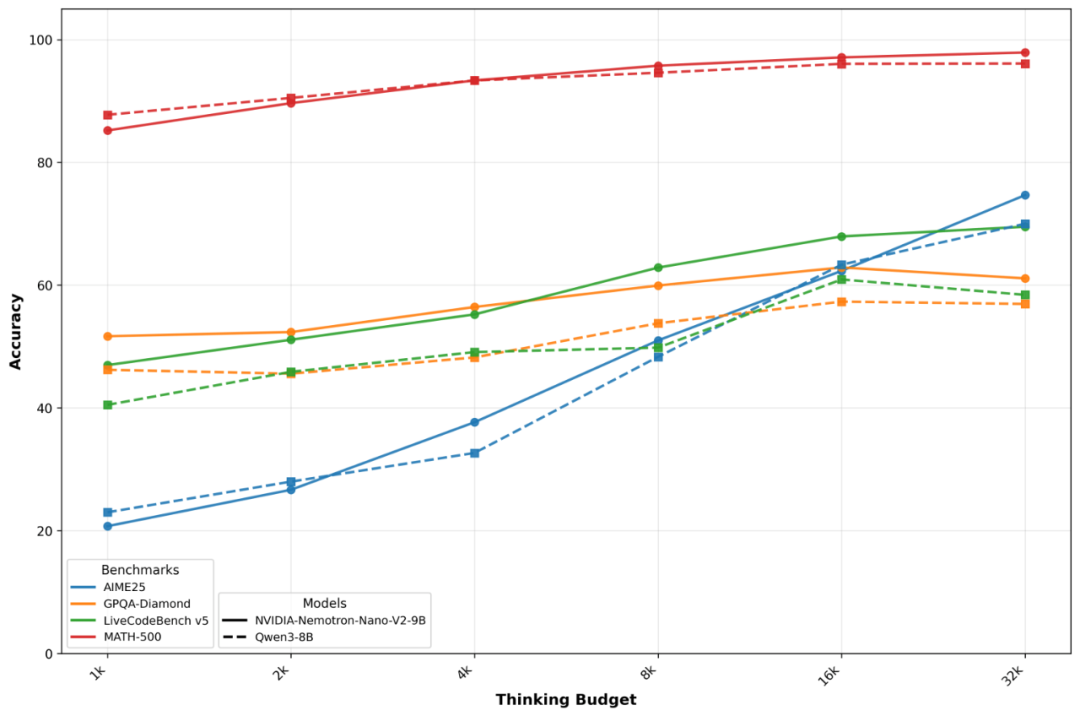

过去半年间,轻量化AI连续攻克技术难关:MIT的模型让智能手表首次具备真正的视觉理解能力;谷歌在移动端实现本地化推理;而英伟达的新品只需单张A10 GPU就能部署,精准匹配企业最常见的硬件配置。正如其AI模型后训练负责人Oleksii Kuchiaev所说:"将参数从120亿优化到90亿,不是妥协,而是为了完美适配企业数据中心的标配显卡。"

这场小型化革命的核心,是对成本、效率与可控性的系统重构。参数规模不再是金科玉律,投资回报率(ROI)才是企业真正的考量重点。

最引人瞩目的是,Nemotron-Nano-9B-v2首次实现"思维过程"的可控调节:

- 输入指令中加入/think,模型会启动链式推理逐步拆解问题

- 使用/no_think则直接输出结果,跳过思考环节

- 通过max_think_tokens功能,开发者可为推理过程设定资源上限

这就像云服务的CPU积分机制,让企业能精确控制AI的"思考成本"。从此,企业可以像购买云存储那样,按需为"思考深度"付费,彻底解决传统大模型token费用失控的痛点。

性能突破源于创新的Mamba-Transformer混合架构:

- 用Mamba状态空间模型替代70%注意力层,显存占用降低40%

- 序列长度与显存消耗呈线性增长,避免传统Transformer的平方级膨胀

- 在128k token长文本任务中,吞吐效率达纯Transformer模型的2.3倍

这种架构不是取代Transformer,而是将其升级为更高效的"混动引擎"。

更令人惊讶的是其商业策略:英伟达提供近乎零门槛的商用授权——免版税、无收入分成、无需谈判。企业只需遵守AI伦理准则和出口管制规定,即可自由集成。相比OpenAI等公司的严格限制,这款模型堪称"AI界的EC2实例",极大降低了商业化门槛。

这一变革将率先惠及三大场景:

- 边缘计算

- 私有化部署

- 实时响应系统

无论是工业设备的本地智能,还是金融、医疗等敏感领域的私有模型,企业终于有了"足够智能、足够经济、足够可控"的新选择。

当AI发展从"堆砌算力"转向"精打细算",一个全新的"精算时代"已经到来。未来的竞争焦点,不再是模型大小,而是如何用更少资源创造更大价值。

Nemotron-Nano-9B-v2的横空出世,正是这场转型的最佳注脚。