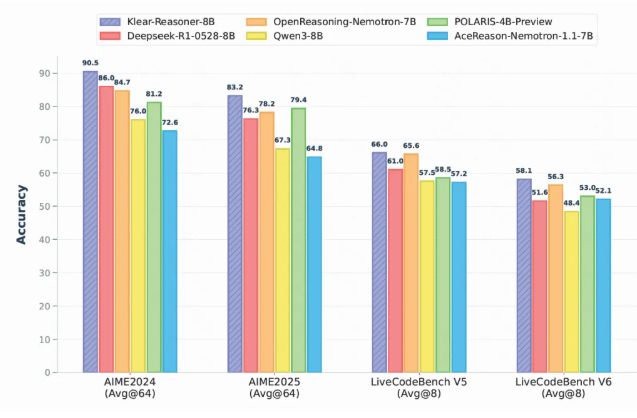

在人工智能技术迅猛发展的今天,大语言模型的推理能力已成为衡量其性能的关键指标,尤其在数学与代码领域表现更为突出。快手最新推出的Klear-Reasoner模型凭借卓越表现引发业界关注,这款基于Qwen3-8B-Base架构深度优化的模型,在多项权威评测中成绩亮眼,数学推理准确率突破90%,成为同级别开源模型中的性能标杆。

模型优异表现的背后,离不开其创新的GPPO训练算法(Gradient-Preserving Clipping Policy Optimization)。该算法巧妙解决了传统强化学习的痛点:

传统裁剪机制虽然能防止模型更新幅度过大,但过度裁剪会导致关键梯度信息丢失,使模型变得过于保守。而GPPO算法通过保留所有梯度参与反向传播,实现了"无损"裁剪,在保证训练稳定性的同时,显著提升了模型对复杂问题的探索能力。

从实测数据来看,Klear-Reasoner确实展现出不俗实力:

- AIME2024评测准确率达90.5%

- AIME2025更难的测试集上仍保持83.2%准确率

值得一提的是,研究团队公开的训练策略揭示了成功秘诀:

- 严格筛选高质量训练数据

- 强化学习阶段保留错误样本促进学习

- 采用"软奖励"机制提升反馈细腻度

重要发现:数据质量对模型性能的影响远超数据数量。在监督微调阶段,精细清洗训练数据、剔除错误标注,能显著提升模型效果。同时,"软奖励"机制比传统"硬奖励"更能平稳引导模型优化。

Klear-Reasoner的推出不仅展示了快手在AI领域的技术实力,更为开源社区提供了可复现的高性能推理模型训练方案。其在算法、数据和训练策略上的创新,为大模型优化提供了宝贵参考。

- Hugging Face地址:https://huggingface.co/Suu/Klear-Reasoner-8B

- GitHub地址:https://github.com/suu990901/KlearReasoner/tree/main

核心亮点:

🌟 8B参数规模下数学推理准确率突破90%

🧠 GPPO算法创新解决梯度裁剪难题

📈 数据质量优先策略带来显著性能提升