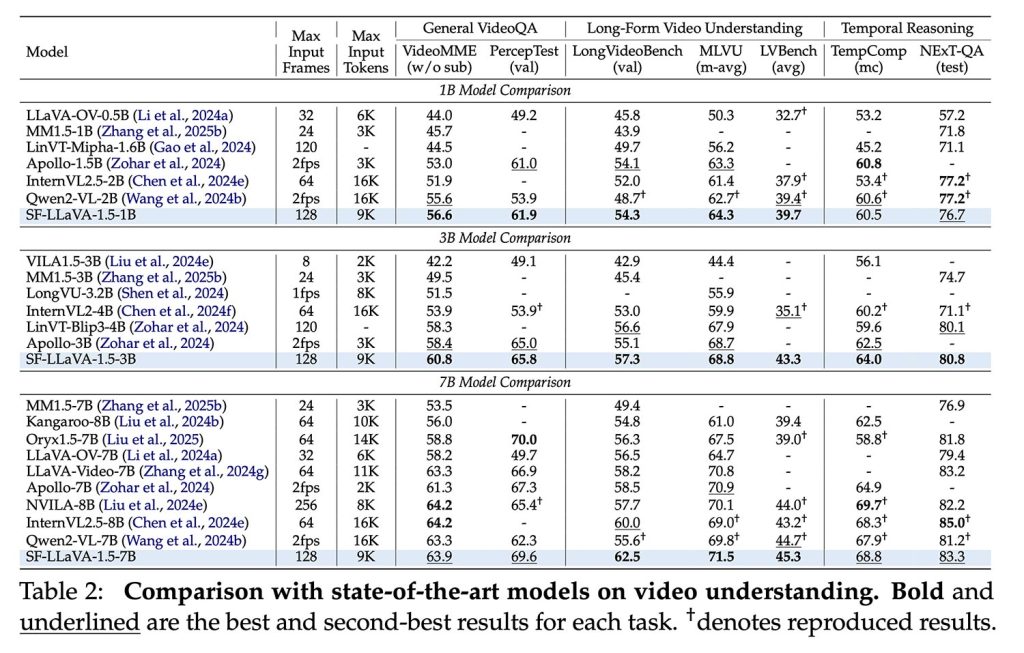

8月23日,科技媒体9to5Mac报道称,苹果人工智能研究团队正式开源了新一代多模态大模型——SlowFast-LLaVA-1.5。该模型专注于长视频理解任务,在10亿、30亿和70亿三个参数规模下,均于LongVideoBench、MLVU等权威评测基准中刷新了纪录,引发行业广泛关注。

当前主流大语言模型在处理视频时,普遍采用将视频信息嵌入长上下文窗口的方式进行预训练。不过这种方法存在三大挑战:

- 视频帧数庞大,模型容易因上下文容量不足而丢失关键信息,尤其对长时长、高帧率视频更为明显;

- 多数模型依赖复杂多阶段训练流程,且使用非公开数据集,导致结果难以复现;

- 部分模型为优化视频任务牺牲了对静态图像的理解,削弱了多模态通用性。

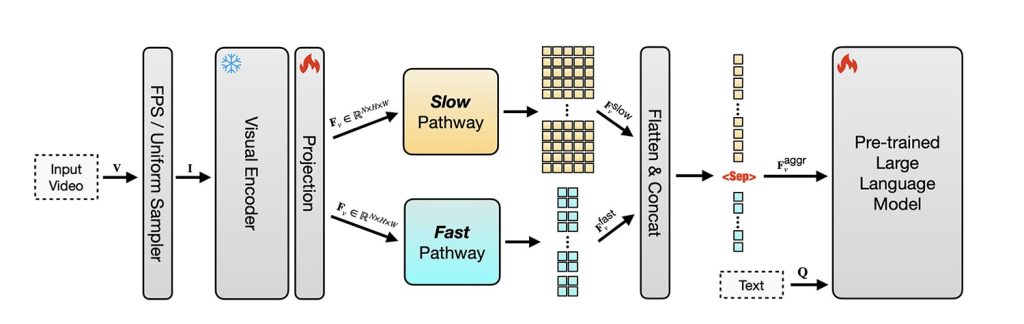

为应对这些挑战,苹果团队提出创新双通道架构SlowFast-LLaVA。该设计借鉴了经典视频分析模型,设立两条并行处理通路:

- “慢流”抽取少量高分辨率关键帧,捕捉语义与场景细节;

- “快流”采样更多低分辨率帧,追踪动作变化与时间动态。

该架构在维持信息密度的同时,显著降低了计算开销。

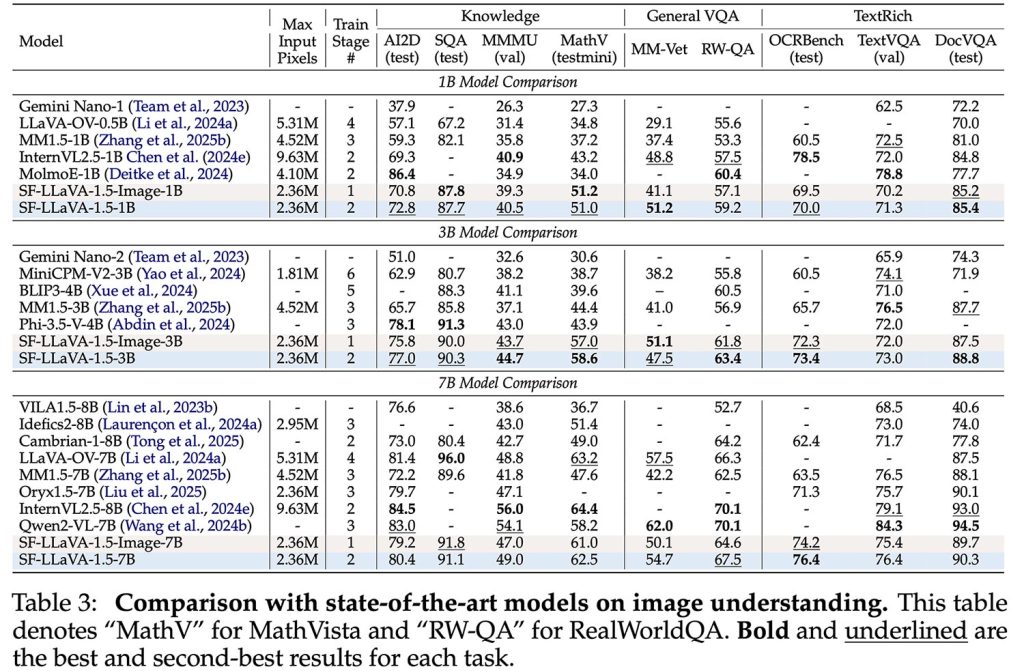

值得一提的是,团队进一步推出升级版SlowFast-LLaVA-1.5。通过对图像模型精细微调,大幅增强视觉推理能力,并借助图像与视频联合训练,实现真正的跨模态通用理解——既保持卓越视频性能,也不削弱图像处理能力。

在具体实现中,模型将输入视频统一处理为128帧,其中快流占96帧,慢流为32帧,以适应不同视频长度。尽管固定帧率策略可能忽略某些瞬时动作,却大幅节省显存与算力。团队也表示,未来可借助随机反向传播等内存优化技术继续提升性能,但需应对相应的硬件资源压力。

实验表明,SlowFast-LLaVA-1.5不仅在长视频理解中领先,即便1B小规模版本也优于同类模型,同时在图像问答、数学推理与OCR等传统任务中表现强劲。

更值得赞赏的是,该项目全程使用公开数据集训练,代码与模型已在GitHub和Hugging Face平台开源,极大促进学术与产业界的后续研究与落地应用。