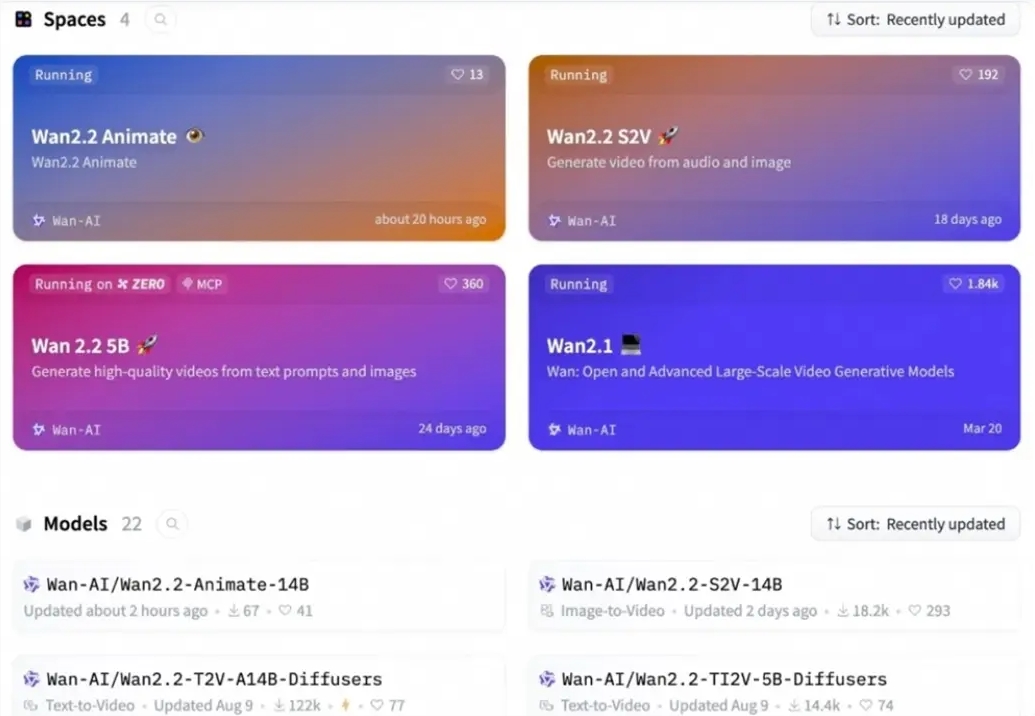

影视创作与数字内容生成领域再迎重大突破!阿里云旗下通义万相团队近日正式宣布,其全新升级的动作生成模型 Wan2.2-Animate 正式对外开放源代码,此举无疑为短视频、动画制作及虚拟内容创作注入了强劲动力。创作者不仅可通过 GitHub、HuggingFace 以及魔搭社区自由下载模型与配套代码,还能借助阿里云百炼平台的 API 接口实现高效调用,亦或直接登录通义万相官网在线体验其强大功能,极大降低了技术门槛。

作为对早期 Animate Anyone 模型的深度进化,Wan2.2-Animate 在角色一致性、动作流畅度与画面细节还原方面实现了质的飞跃。该模型主打两大核心应用场景:其一为“动作模仿”,用户仅需提供一张静态角色图像与一段动作参考视频,系统即可智能提取视频中的姿态、动作轨迹乃至细微表情,并精准赋予静态角色,使其“活”起来;其二为“角色扮演”模式,能够在完整保留原视频动作节奏、场景环境与情绪表达的前提下,将其中人物无缝替换为用户指定的角色形象,实现跨角色的内容再造。

为确保生成效果的高保真与自然度,通义万相团队构建了一个涵盖丰富人体动态行为的大规模视频数据集,涵盖日常对话、面部微表情、全身舞蹈动作等多种情境,并结合其自研的图生视频技术进行深度训练。Wan2.2-Animate 的底层架构创新性地将角色特征、动作信号与环境信息统一编码,从而实现两种模式的灵活切换与高效推理。针对人体动态,模型采用骨骼关键点驱动结合隐式特征编码,配合动作重定向模块,实现对复杂动作的高精度复现;而在光影表现方面,团队特别研发了独立的光照融合 LoRA 模块,有效解决了角色与场景光照不匹配的难题,使合成画面更加真实自然。

实测数据显示,Wan2.2-Animate 在视频连贯性、主体一致性及感知质量等关键维度上,全面超越 StableAnimator、LivePortrait 等主流开源方案,跃居当前开源动作生成模型性能榜首。更值得一提的是,在多轮用户盲测中,其生成内容的视觉舒适度与真实感甚至优于 Runway 的 Act-two 等商业闭源产品,展现出极强的市场竞争力。

随着 Wan2.2-Animate 的全面开源,个体创作者、小型工作室乃至大型影视公司都将能以更低的成本获取顶尖的动态生成技术,预示着个性化、高效率的数字内容生产时代正加速到来。

划重点:

🌟 ** 新模型开源 **:阿里云的 Wan2.2-Animate 模型正式开源,用户可在多个平台下载和体验。

🎭 ** 两种模式 **:支持动作模仿和角色扮演,提升动态表现力与替换能力。

🚀 ** 性能优越 **:在多个关键指标上超越现有开源模型,成为动作生成领域的佼佼者。