9月22日,美团LongCat团队正式对外推出其最新研发的高效推理模型——LongCat-Flash-Thinking,标志着国内大模型在复杂任务处理能力上迈出了关键一步。这款新模型不仅延续了前代LongCat-Flash-Chat在响应速度上的极致表现,更在深度推理、逻辑分析与多模态任务协同方面实现了全面跃升。

据官方披露,LongCat-Flash-Thinking在数学推导、代码生成、智能体决策以及形式化证明等多个高难度领域,均已达到当前全球开源模型中的顶尖水平(SOTA)。尤为引人注目的是,该模型首次在国内实现了“深度思考+工具调用”与“非形式化直觉推理+形式化严格证明”能力的深度融合,成为真正具备类人思维链条构建能力的大语言模型。

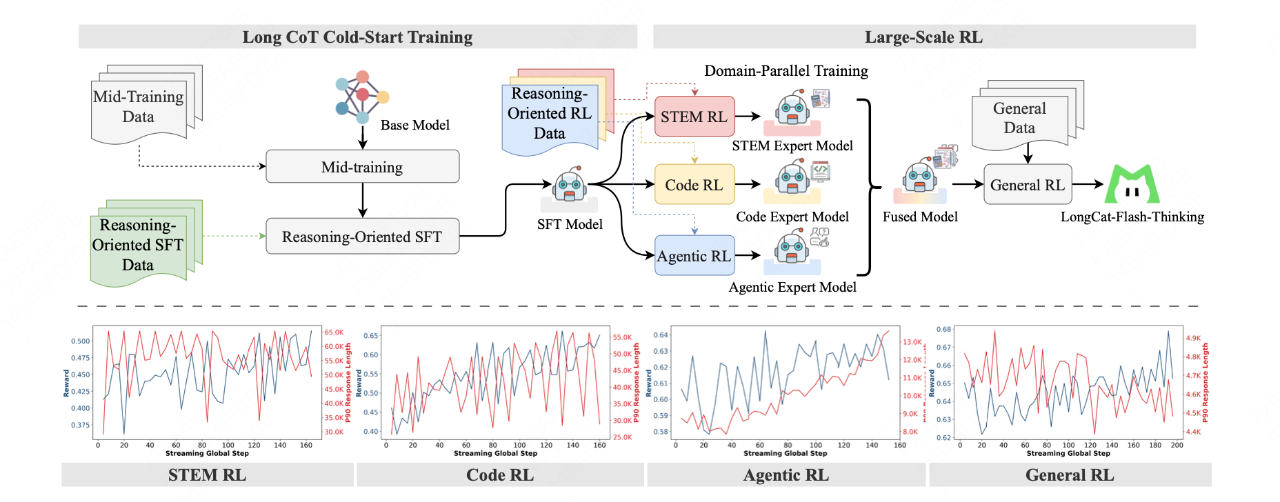

在技术架构层面,LongCat团队采用了一系列前沿创新方案以保障模型的高效训练与稳定推理。其中,“领域并行强化学习训练方法”通过将STEM、编程与智能体任务的优化路径解耦,实现了多领域能力的协同进化,最终达成帕累托最优的综合性能表现。这一策略有效避免了传统混合训练中各任务相互干扰的问题,使模型在各类复杂场景下均能保持稳定输出。

支撑整个训练体系的核心是名为DORA的异步弹性共卡系统。该系统借助弹性共卡调度与多版本异步流水线设计,在保证样本策略一致性的前提下,将训练效率提升至传统同步框架的三倍以上。同时,高效的KV缓存复用机制使其能够稳定运行于万卡级超大规模集群,为高强度的异步强化学习提供了坚实算力基础。数据显示,该阶段的FLOPs投入仅为预训练阶段的20%,却带来了显著的性能增益。

为增强智能体级别的任务执行能力,团队独创“双路径推理框架”,使模型可自主识别任务需求并动态调用外部工具,如代码解释器或API接口。实测数据显示,在AIME25测试中,模型在维持90%准确率的同时,Token消耗从19653大幅降低至6965,资源利用效率提升超过六成。

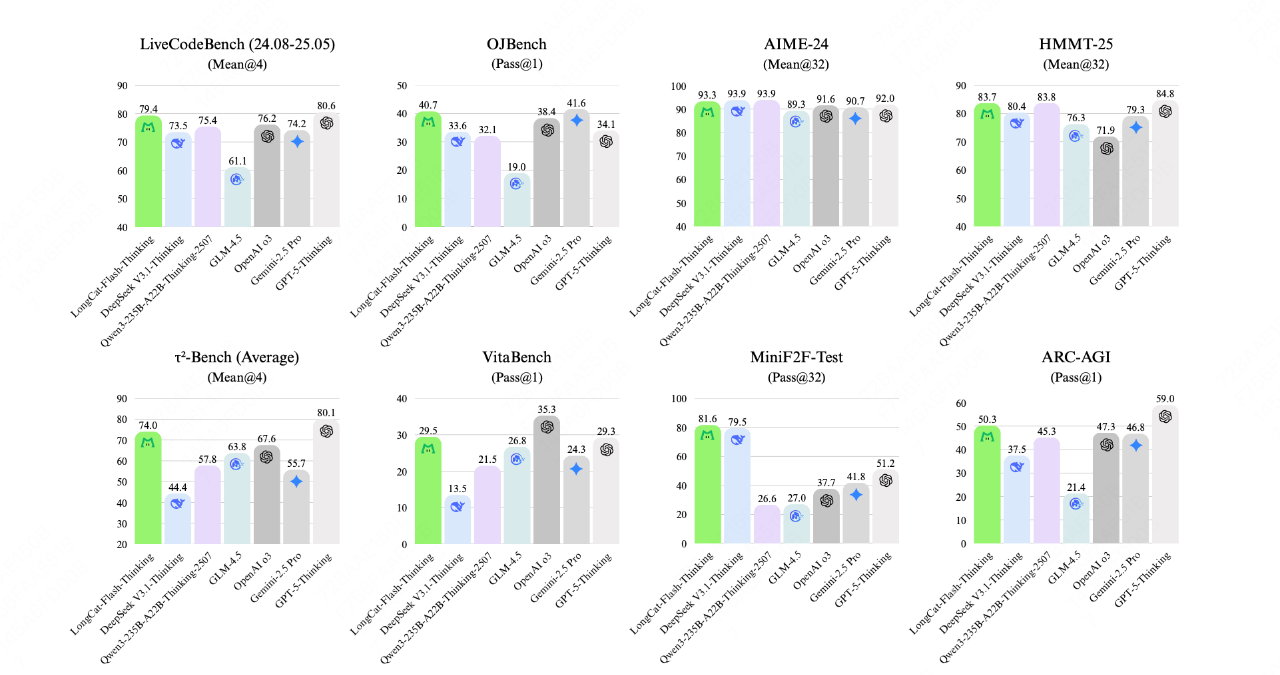

针对形式化推理短板,团队构建了一套基于专家迭代的数据合成流程,并集成Lean4定理证明服务器,生成经过严格验证的推理链条。这一机制显著提升了模型在数学证明等严谨场景下的可靠性。在MiniF2F-test基准中,其pass@1得分高达67.6,全面领先其他开源及闭源模型。

在多项权威评测中,LongCat-Flash-Thinking表现抢眼:ARC-AGI测试中以50.3分超越GPT-4o与Gemini;HMMT与AIME数学基准上与Qwen3-235B-A22B-Thinking并驾齐驱;LiveCodeBench编程测试获79.4分,逼近GPT-5水平;τ2-Bench-Airline智能体任务刷新开源SOTA纪录。这些成绩充分验证了其在高复杂度任务中的统治级实力。

目前,LongCat-Flash-Thinking已全面开源,开发者可通过Hugging Face与GitHub平台获取模型权重与技术文档,共同推动下一代智能推理系统的生态建设。