一场旨在重新定义AI编程能力边界的测试,正掀起新一轮的行业热议。Scale AI最新发布的SWE-BENCH PRO基准,像是一面照妖镜,将当前主流大模型在真实软件工程场景下的短板暴露无遗。

初看榜单,结果令人瞠目:即便是被寄予厚望的“AI御三家”,在这一轮较量中也集体哑火,最高解决率未能突破25%大关。

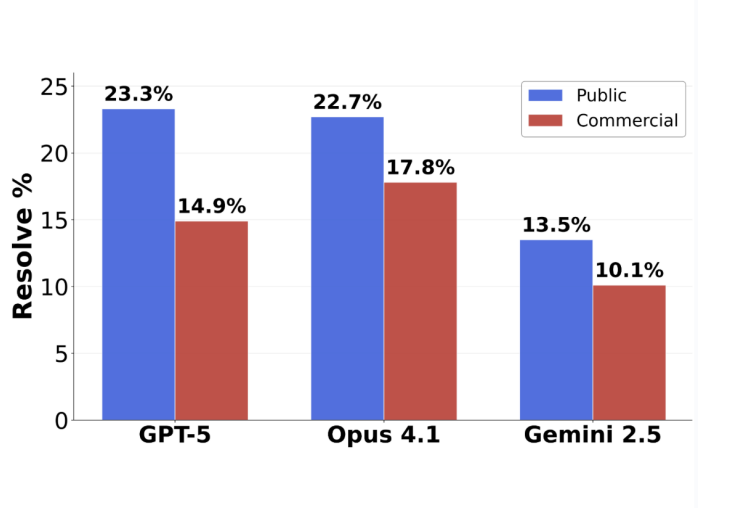

GPT-5以23.3%的解决率位列榜首,紧随其后的是Claude Opus 4.1的22.7%,而Gemini 2.5则以13.5%的成绩垫底。表面看,这似乎是一场没有赢家的战役。

然而,当数据被进一步拆解,真正的较量才浮出水面。

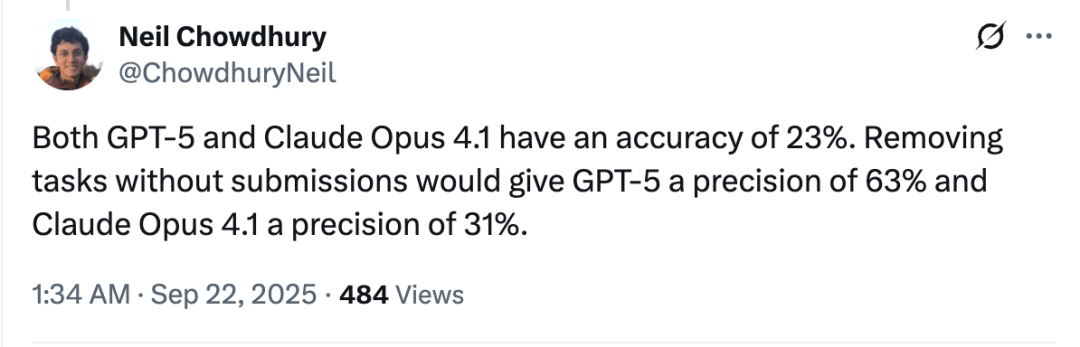

前OpenAI研究员Neil Chowdhury指出,若仅统计模型实际尝试并提交的任务,GPT-5的准确率飙升至63%,几乎是Claude Opus 4.1同期31%的两倍。这一反差揭示了一个关键事实:GPT-5并非能力不足,而是更加“谨慎”——它倾向于只在有把握时才出手,而其他模型则更频繁地“盲目尝试”。

换言之,GPT-5在擅长的复杂任务上依然保持着接近SWE-Bench-Verified基准74.9%的高水准,而对手们却在新挑战面前大幅失速。

那么,SWE-BENCH PRO究竟设置了怎样的“高门槛”?

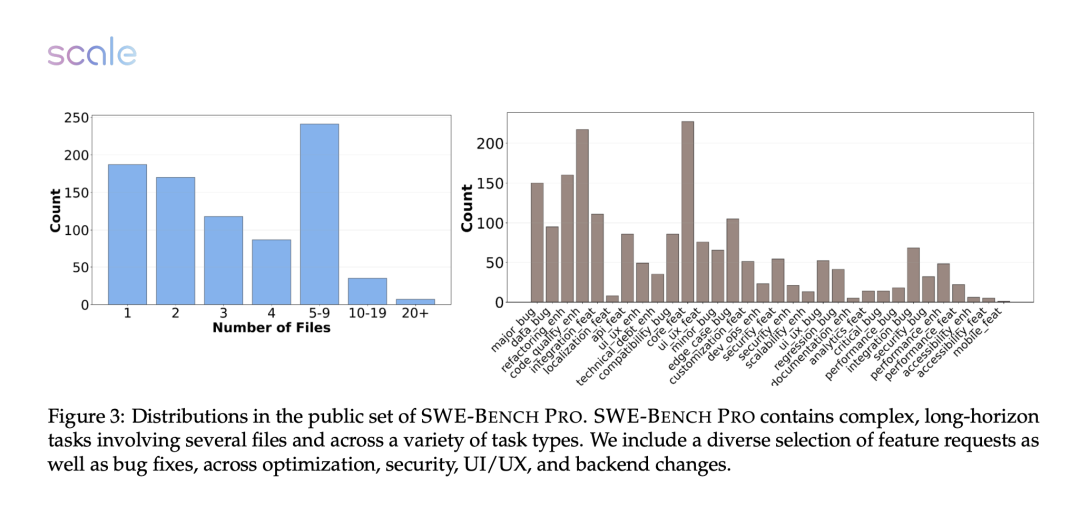

答案在于“真实”二字。与旧基准相比,SWE-BENCH PRO彻底摒弃了那些可能已被模型“背过答案”的开源项目,转而聚焦于1865个涵盖商业应用、B2B服务和开发者工具的真实代码库。

这些数据被精心划分为三个子集:公开可获取的“公共集”,源自初创企业私有代码的“商业集”,以及用于防过拟合验证的“保留集”。所有问题均经过人工增强,包含清晰的需求说明、接口定义和运行环境,确保模型无法依赖记忆,必须真正理解并解决问题。

更关键的是,测试排除了所有“一两行代码”的简单修改,只保留需要跨文件、大规模重构的复杂任务,高度模拟现实开发中的技术挑战。

在评估机制上,研究团队采用“human in the loop”模式,通过fail2pass和pass2pass双重测试验证修复的有效性与兼容性,并对测试用例进行人工筛选,确保结果的严谨性。

最终结果揭示了AI编程的现状:即便最顶尖的模型,在真实商业场景中的解决率也普遍低于20%。GPT-5和Claude Opus在公共集上表现稳健,但诸如GPT-4o和Qwen-3 32B等模型的解决率甚至不足4%,差距显著。

深入分析失败原因,各模型“死法”各异:Opus困于语义理解,GPT-5受限于工具调用,Sonnet常因上下文溢出而崩溃,Gemini则在多个维度均显乏力,而开源模型Qwen-3暴露出的高工具错误率,更凸显了工程化集成的重要性。

这场测试无疑给AI编程的热潮泼了一盆冷水,但也指明了方向:真正的智能编码,不在于“背题”,而在于理解、推理与执行的综合能力。下一个突破30%解决率的模型,会是谁?