人工智能与机器人技术的融合正迎来一个里程碑式的进展。谷歌DeepMind最新推出的Gemini Robotics项目,首次实现了让机器人在行动前具备“规划”能力的双模型架构系统。这一创新不仅突破了传统机器人只能按预设程序执行任务的桎梏,更预示着通用型机器人时代的曙光已然来临。

生成式AI早已在内容创作领域大放异彩,从撰写文章到生成图像、视频,其应用已深入日常。如今,这项技术正被延伸至物理世界——直接驱动机器人的行为。DeepMind的研究团队坚信,生成式AI为机器人赋予了前所未有的适应性与泛化能力,使其不再局限于单一场景,而是能够应对多样化的现实挑战。

长期以来,机器人产业饱受“专机专用”的困扰。一台机器人往往需要经过数周甚至数月的调试与训练,才能完成特定产线上的固定操作,一旦环境或任务发生改变,系统便难以应对。谷歌DeepMind机器人部门主管Carolina Parada坦言:“当前的机器人系统高度定制化,部署周期长、灵活性差,严重制约了其广泛应用。”

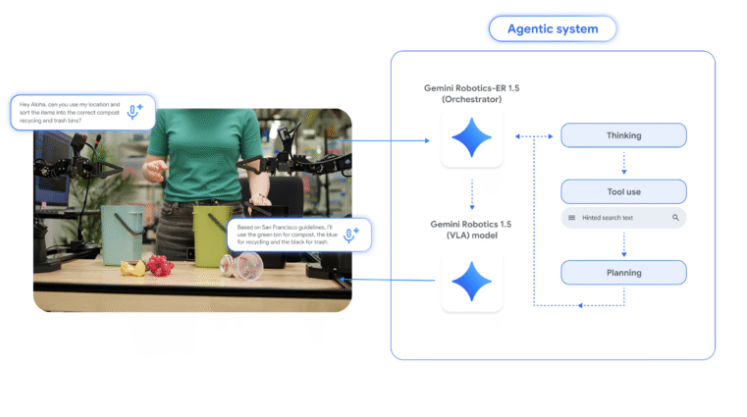

而Gemini Robotics的出现,正是为了解决这一核心痛点。该系统采用两个协同工作的AI模型,分别承担“大脑”与“肢体”的角色,实现思考与行动的分离。这种架构使得机器人能够在陌生环境中快速理解任务,并自主生成执行路径,无需重新编程。

其中,Gemini Robotics-ER1.5负责“思考”,其名称中的“ER”代表“具身推理”(Embodied Reasoning)。它是一个视觉-语言模型,能够接收环境图像和自然语言指令,结合外部工具如搜索引擎获取信息,进而推理出完成任务所需的步骤序列。它不直接操控机械臂,而是输出清晰的行动计划,如同人类在动手前的脑内预演。

另一个模型Gemini Robotics1.5则负责“执行”,它将推理模型生成的抽象指令转化为精确的机械动作。作为视觉-语言-动作模型,它理解环境感知数据,并驱动机器人完成抓取、移动、分类等具体操作。以衣物分拣为例,ER模型会先分析衣物堆的视觉信息,判断颜色类别,并规划“先拾取白色衣物放入左侧容器”等步骤,再由执行模型精准落实。

这种“先想后做”的模式,极大提升了机器人处理复杂、非结构化任务的能力。更重要的是,用户只需用自然语言下达指令,机器人便能自主完成从理解到执行的全过程,大幅降低了使用门槛。

尽管目前该技术仍处于实验室阶段,距离大规模商用尚有距离,但其展现出的通用性潜力令人振奋。未来,机器人或将不再局限于工厂流水线,而是走进家庭、医院、仓储等多元场景,真正成为能够理解意图、适应环境的智能伙伴。DeepMind的这次突破,或许正是通向通用机器人的关键一步。