由上海人工智能实验室携手浙江大学等顶尖学术力量共同研发的IWR-Bench正式亮相,这一创新性基准测试标志着AI在前端开发领域的评估体系迈入新阶段。作为全球首个专注于评估大语言模型将操作视频转化为可交互网页代码能力的评测框架,IWR-Bench精准切入多模态大模型在动态网页重建中的核心挑战,为行业提供了一把衡量“视觉理解+代码生成”综合能力的标尺。

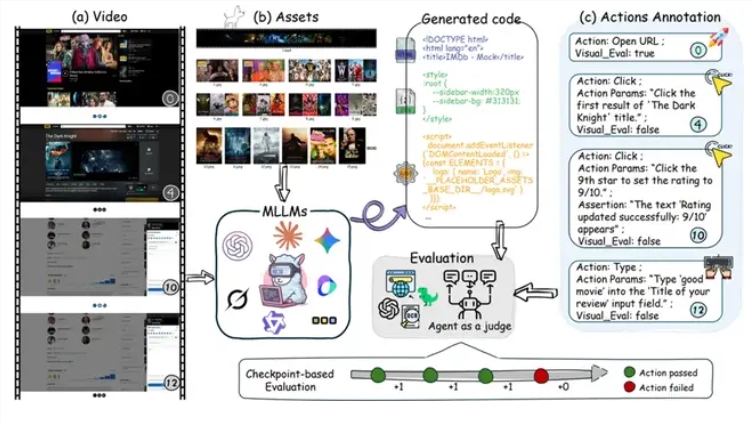

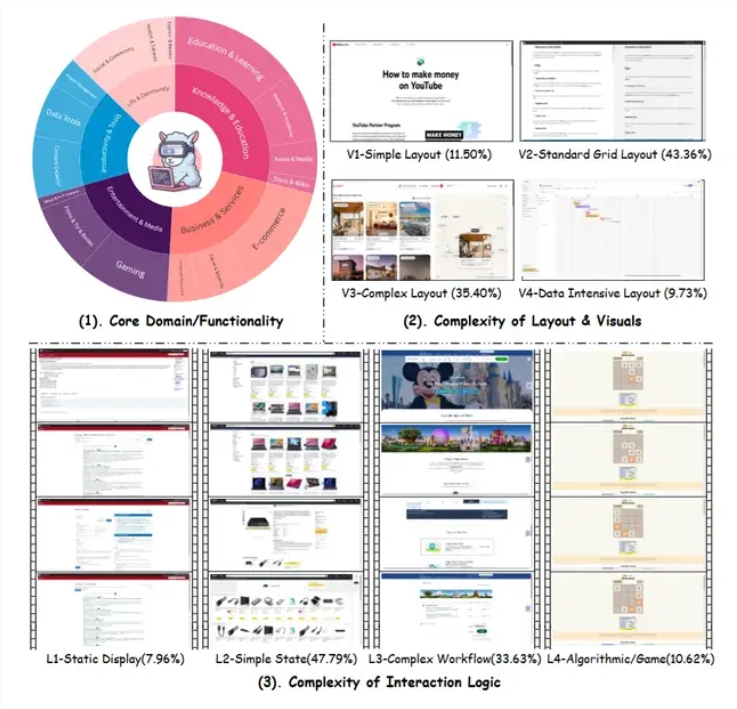

与传统依赖静态图像生成代码的模式不同,IWR-Bench引入了更具现实复杂性的视频输入。模型需分析完整用户操作流程的动态视频,结合网页所需的全部静态资源,还原出具备真实交互功能的前端代码。任务范围广泛覆盖日常场景,如机票查询系统、在线小游戏2048等,要求模型不仅能“看”清界面,更要“懂”操作背后的逻辑链条。

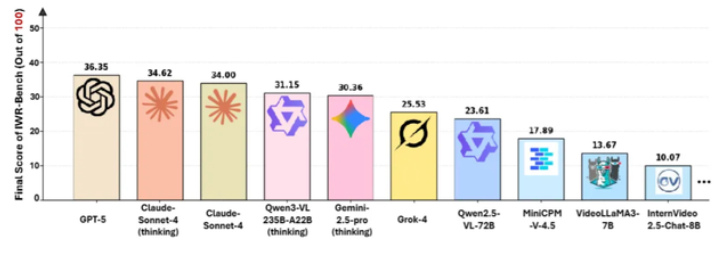

在对28款主流多模态模型的全面测评中,即便是当前性能领先的GPT-5,其综合得分也仅为36.35分,其中交互功能正确性(IFS)低至24.39%,而视觉保真度(VFS)达到64.25%。这一悬殊对比揭示出当前AI技术的典型瓶颈:模型已能较好还原页面布局与视觉样式,但在捕捉点击、跳转、状态更新等动态行为并将其转化为可执行逻辑时,仍显得力不从心。

评测机制的设计极具实战导向。IWR-Bench不仅依赖自动化代理验证生成代码的交互准确性,还刻意将所有静态资源文件名匿名化,迫使模型必须通过视觉特征进行匹配,而非依赖语义联想。这种设定模拟了真实开发中资源管理混乱的常见情况,极大提升了任务难度,也更真实地检验了模型的因果推理与状态追踪能力。

研究团队还观察到,尽管引入“思维链”机制的模型在部分任务中略有提升,但整体改善有限,说明底层架构与训练数据仍是决定性因素。更令人意外的是,专为视频理解优化的模型并未在该任务中脱颖而出,反而通用多模态模型表现更稳,这暗示视频转代码并非单纯的视觉理解延伸,而是一种需要将动态行为抽象为编程范式的高阶能力。

从技术维度看,该任务面临四大难关:精准提取视频中的关键帧与交互事件、将用户行为映射为事件监听与状态机逻辑、在无标签资源中完成视觉匹配、最终生成结构严谨且可运行的前端代码。每一个环节都可能成为模型的“断点”。

即便GPT-5的交互正确率不足25%,这一结果仍为AI研发提供了清晰路径。它表明,当前模型在“感知”与“执行”之间存在巨大鸿沟。能复现按钮样式,不代表能理解点击后应触发何种数据请求或页面跳转。这也提醒业界,距离真正实现“演示即原型”的智能开发工具有漫长道路要走。

长远来看,IWR-Bench不仅是一个评分工具,更是一种技术风向标。它推动AI从静态描述迈向动态演示,从“听指令写代码”进化到“看操作生功能”。未来,若模型能突破交互逻辑生成瓶颈,设计师只需录制一段操作视频,即可自动生成可点击、可跳转的网页原型,极大加速产品迭代。然而,真实开发中的性能调优、跨浏览器兼容、安全防护等深层需求,仍需人类工程师的深度介入。

该基准的发布,实质上为多模态AI划定了一条新的能力分水岭:能否将“所见”的动态行为,转化为“可行”的程序逻辑。随着更多研究聚焦于此,我们有望见证AI从“代码助手”向“交互逻辑理解者”的关键跃迁。