在人工智能技术日新月异的当下,字节跳动携手多家顶尖高校研究团队,推出了一款名为Sa2VA的前沿视频理解模型。该模型巧妙融合了当前两大热门技术——视觉语言模型LLaVA与图像分割模型SAM-2,实现了对视频内容的深度解析与精准操作,标志着多模态AI在视频处理领域迈出了关键一步。

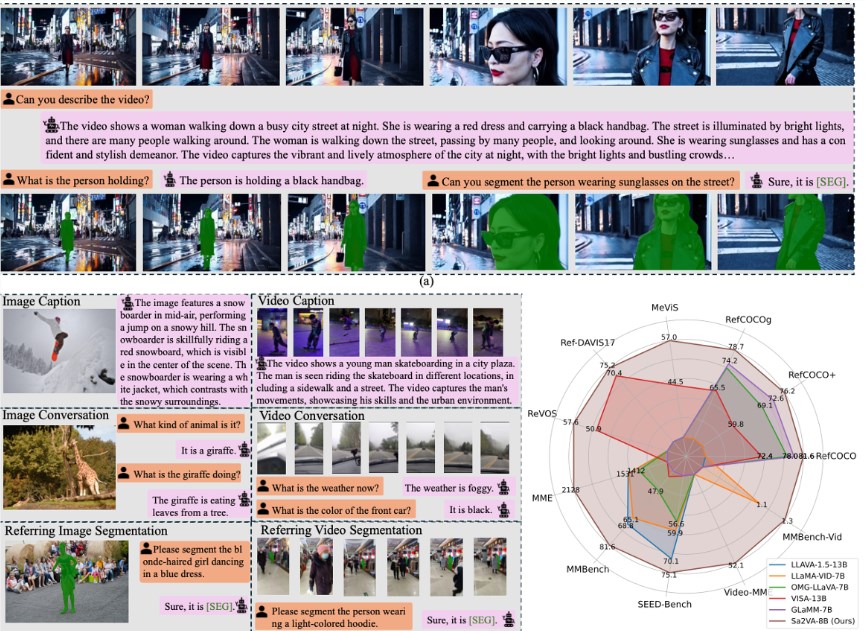

LLaVA以其强大的语义理解能力著称,能够对视频进行整体描述和上下文推理,但在面对“请分割画面中穿红色外套的人”这类具体指令时往往无从下手。而SAM-2虽然在图像分割任务中表现出色,能精准勾勒物体轮廓,却无法理解自然语言指令。Sa2VA的突破之处在于构建了一个高效的“通信桥梁”,让这两个原本独立运作的系统得以协同工作,各展所长。

这一架构被形象地比喻为“双引擎驱动”:一个引擎专注于语言交互与意图识别,另一个则负责视觉层面的像素级分割与目标追踪。当用户发出指令后,语言模块会解析意图,并生成一种特殊的“指令令牌”作为“暗号”,传递给分割模块执行具体操作。这种设计不仅实现了跨模态的信息传递,还允许系统在反复交互中不断优化响应精度,形成闭环学习机制。

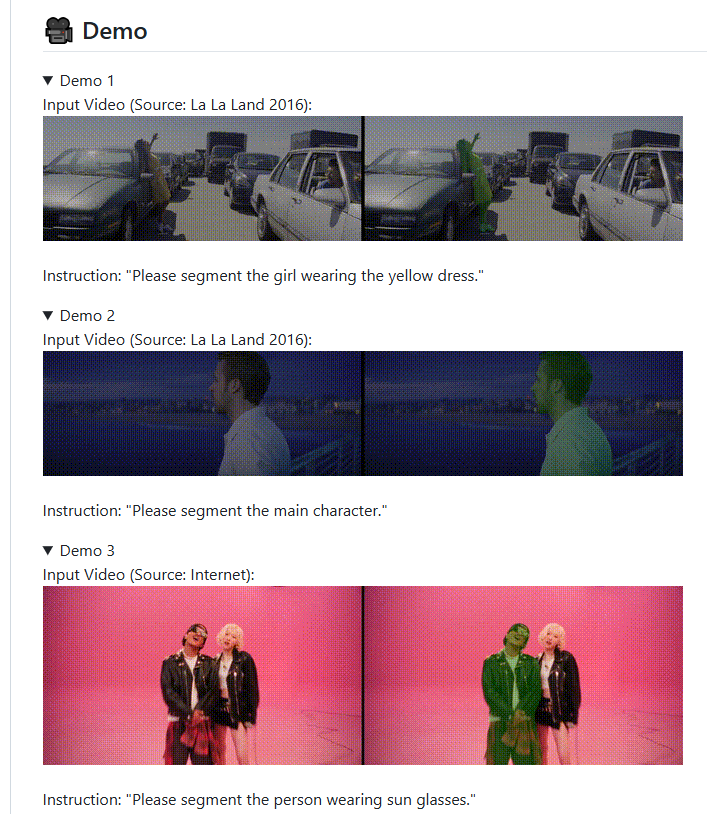

为了进一步提升模型的综合能力,研发团队设计了一套系统的多任务联合训练方案,涵盖图像理解、视频指代分割、动态目标追踪等多个维度。实验数据显示,Sa2VA在多个公开基准测试中均取得领先成绩,尤其在复杂场景下的视频指代表达分割任务中表现卓越。无论是拥挤街道中的行人识别,还是快速移动物体的持续追踪,它都能保持高准确率与稳定性,展现出强大的现实应用潜力。

更值得称道的是,字节跳动并未将这项技术束之高阁,而是选择开源Sa2VA的多个版本及相关训练工具,向全球开发者社区开放。此举不仅降低了多模态AI技术的研究门槛,也为影视剪辑、智能监控、虚拟现实等领域的创新应用提供了坚实的技术底座。

项目:

https://lxtgh.github.io/project/sa2va/

https://github.com/bytedance/Sa2VA

划重点:

- 🎥 Sa2VA整合LLaVA的语言理解力与SAM-2的视觉分割力,实现视频内容的智能交互。

- 🔗 通过“指令令牌”机制,打通语言与视觉模块的沟通壁垒,提升响应精准度。

- 🌍 开源策略助力技术普惠,为AI开发者提供强大工具,加速多模态生态发展。