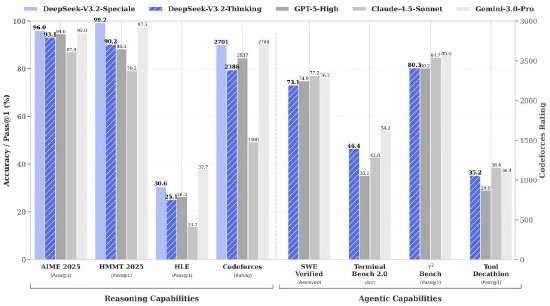

12月1日,中国人工智能新锐力量深度求索(DeepSeek AI)正式推出其最新一代大模型系列——DeepSeek-V3.2,引发业界广泛关注。此次发布的模型家族不仅包含标准版DeepSeek-V3.2,还同步推出了专为高阶推理设计的增强型号DeepSeek-V3.2-Speciale,展现出该公司在通用人工智能路径上的深度布局与技术雄心。新模型旨在与全球顶尖闭源模型如OpenAI的GPT-5及Google的Gemini 3.0 Pro展开正面竞争。

DeepSeek-V3.2的核心突破在于其自主研发的DeepSeek Sparse Attention(DSA)架构,这一机制实现了细粒度的稀疏注意力计算,首次在不牺牲性能的前提下显著优化了长序列处理的资源消耗。传统密集注意力在处理超长文本时面临算力与内存的双重压力,而DSA通过智能筛选关键信息节点,在保持模型理解力的同时大幅降低冗余计算。这一改进带来了两项关键优势:

-

在实际推理任务中,尤其是涉及万字级上下文的应用场景,响应速度相较前代提升2至3倍;

-

大幅压缩调用成本,官方明确表示新模型API定价较同类产品下降超过50%,显著增强了商业落地可行性。

更值得注意的是,DeepSeek-V3.2被明确定义为“Agent优先”模型。这意味着它不再仅是一个被动问答系统,而是具备主动规划、调用工具和执行多步骤任务的能力。团队采用大规模合成Agent任务数据进行训练,并引入“思考模式”机制,使模型在回应前可进行内部链式推理,模拟人类解决问题的逻辑路径。在多项权威Agent能力评测中,V3.2展现出领先于其他开源模型的表现,尤其在自动化代码生成、复杂决策流程模拟等场景中表现突出。

本次发布涵盖两个主要版本:

- DeepSeek-V3.2:现已全面上线官网、移动应用及API接口,定位为高效能通用模型,适用于日常对话、编程辅助、内容生成等广泛场景;

- DeepSeek-V3.2-Speciale:作为计算密集型增强版本,目前仅通过限量API提供服务。据官方披露,该版本在多项高难度逻辑与数学推理测试中超越GPT-5,并在模拟2025年国际数学奥林匹克(IMO)与信息学奥林匹克(IOI)竞赛中达到金牌水平,展现出接近人类顶尖选手的抽象思维能力。

为推动生态发展,深度求索已将V3.2模型权重开源至Hugging Face平台,同时开放底层推理内核与示例代码,支持企业与研究机构进行定制化部署与二次开发。此举被视为对全球AI开源社区的重要贡献。行业观察者指出,DeepSeek-V3.2的出现标志着大模型正从“对话能力”向“自主行动能力”演进,开源体系正逐步逼近甚至在某些维度超越闭源巨头的技术壁垒。开发者可通过官方API文档深入了解模型调用方式与技术规范。

地址:https://huggingface.co/deepseek-ai/DeepSeek-V3.2-Exp