12月2日,知名科技媒体 Tom's Hardware 发布最新报道,披露英伟达在一篇研究论文中提出了一种名为 TiDAR 的创新 AI 解码架构。该方法巧妙融合了自回归(Autoregressive)与扩散(Diffusion)两种主流生成机制,旨在利用 GPU 推理过程中未被充分利用的“空闲槽位”,显著提升文本生成效率。

传统自回归模型的工作方式类似于文字接龙——必须逐字预测,每生成一个 Token(词元),都依赖于前序所有内容。这种方式虽然稳定可靠,但速度受限,尤其在长文本生成场景下延迟明显。

而扩散模型原本多用于图像生成领域,其核心思路是通过逐步“去噪”还原出清晰内容。在 TiDAR 中,研究人员将其引入语言建模,用以并行“猜测”多个潜在的后续词元,为后续筛选提供候选池。

当前主流大语言模型普遍采用逐 Token 生成策略,这不仅带来较高的计算开销,也限制了响应速度。TiDAR 的突破点在于,它尝试在单次推理步骤中产出多个 Token,同时保持输出质量不受影响,从而有效缩短 GPU 占用时间、提升整体吞吐能力。

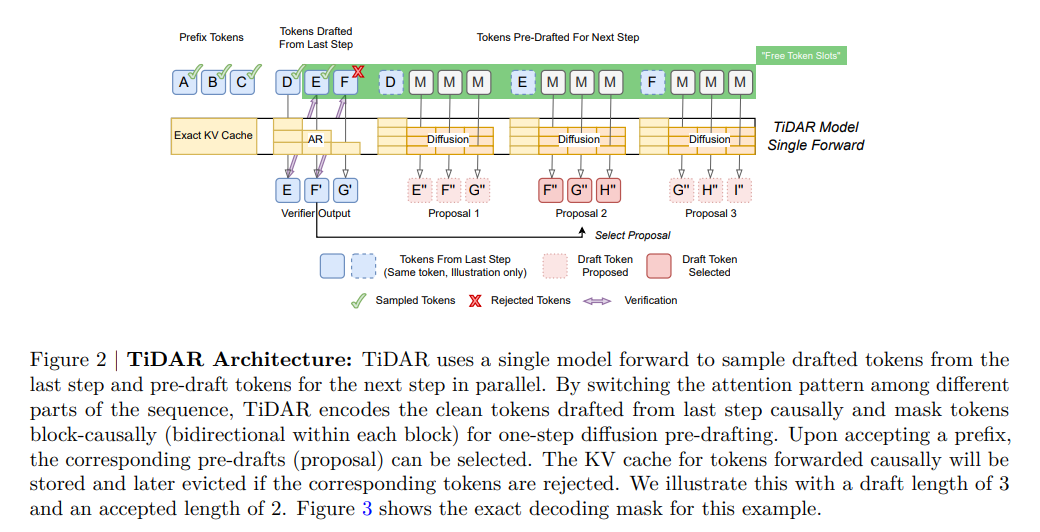

技术实现上,TiDAR 并非简单拼接两种模型,而是训练单一 Transformer 架构同时承担两项任务:一方面执行标准的自回归“下一词预测”,另一方面通过扩散机制进行“并行草拟”。这种双头设计避免了传统投机解码(Speculative Decoding)对额外小模型的依赖——后者通常需先由轻量模型快速起草一段文本,再交由主模型校验修正。

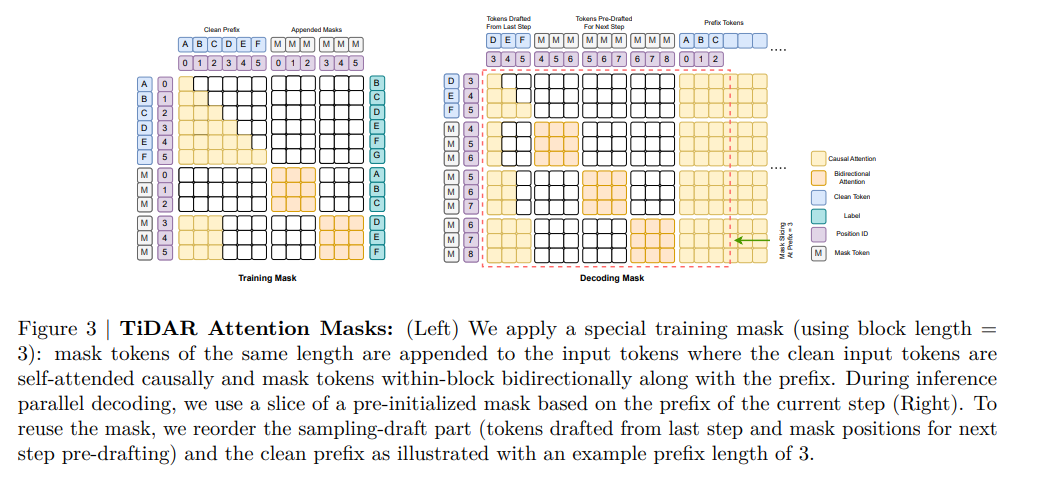

TiDAR 则在同一模型内部完成起草与验证。其关键在于引入一种结构化的注意力掩码(Attention Mask),将输入序列划分为三个逻辑区域:已确认的前缀区、待验证的草案区,以及用于扩散生成的新起草区。这种分区机制不仅保障了生成过程的连贯性,还维持了 KV 缓存(KV Cache)的有效组织,解决了以往扩散式解码器在部署时常见的缓存管理难题。

研究团队基于阿里巴巴开源的 Qwen 系列模型展开实验。结果显示,在 HumanEval 和 GSM8K 等权威基准测试中,TiDAR 版本的准确率与原始模型相当,甚至略有提升。性能方面更是表现亮眼:15 亿参数规模的 TiDAR 模型实现了 4.71 倍的吞吐量加速;而在 80 亿参数版本上,这一数字跃升至 5.91 倍,远超 Qwen3-8B 基准。这意味着在不增加显存数据搬运负担的前提下,TiDAR 能更高效地榨取 GPU 显存带宽潜力。

尽管成果令人振奋,Tom's Hardware 也指出,TiDAR 目前仍处于早期验证阶段。所有实验均基于 80 亿参数以下的中小模型,且未采用定制化内核优化(如 fused kernels),仅运行于标准 PyTorch 环境。随着模型规模和上下文长度持续扩大,计算密度可能趋于饱和,进而削弱多 Token 并行带来的边际效益。研究团队表示,下一步将把 TiDAR 应用于更大规模的语言模型,以评估其在云端高负载 AI 服务中的实际部署价值。