解读:AI生成未来

亮点直击

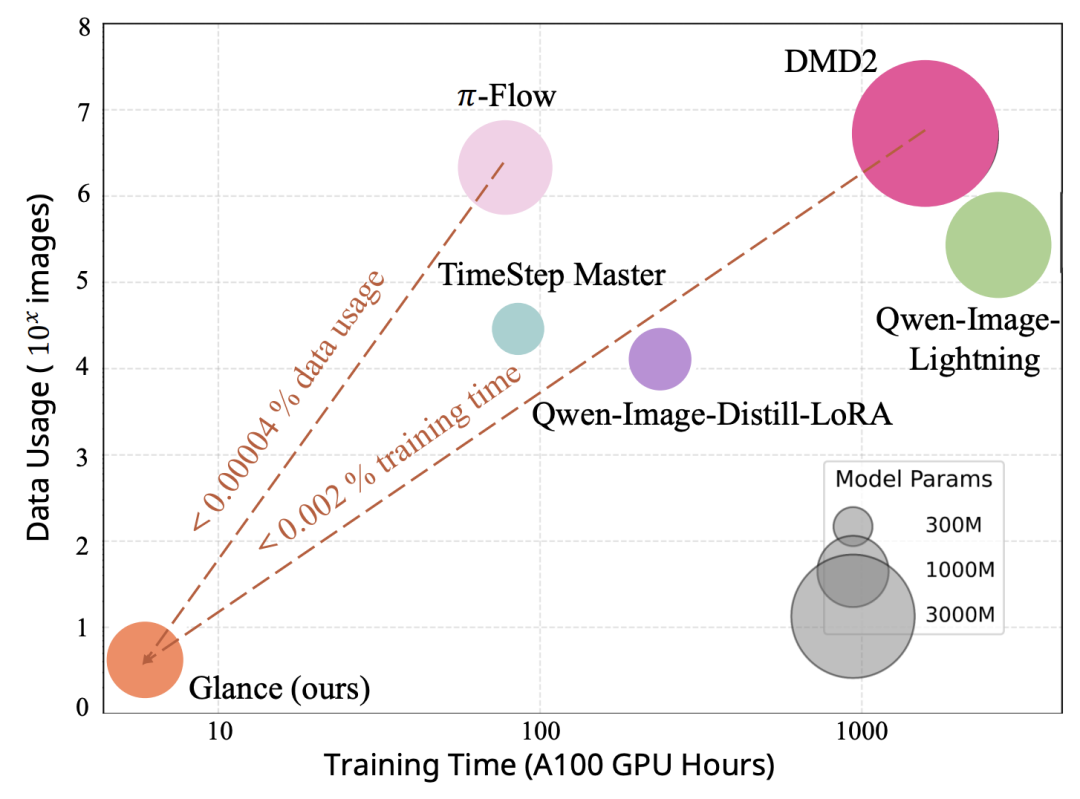

极致高效的训练效率:Glance仅需一张训练图像,在单张V100 GPU上不到一小时即可完成整个加速适配过程。这一效率远超传统蒸馏方法——例如DMD2需耗费3840个GPU小时,而Glance几乎实现了“零成本”部署。

非均匀加速策略:不同于一刀切的均匀跳步方式,Glance创新性地提出“慢-快”(Slow-Fast)分阶段加速机制。在扩散早期语义构建阶段采用较慢节奏保留结构完整性,在后期细节优化阶段则大幅跳步提升速度,精准匹配扩散模型内在动力学。

即插即用架构:无需从头训练或微调庞大的学生模型,Glance通过两个轻量级LoRA适配器挂载于冻结的基础模型之上,即可实现高效推理加速。该设计不仅节省资源,还展现出惊人的跨提示泛化能力,即便面对未见过的复杂文本描述也能稳定输出高质量图像。

解决的问题

推理延迟高企:标准扩散模型通常需50步以上去噪才能生成清晰图像,高昂的计算开销严重制约其在移动端或实时场景中的落地。

蒸馏成本与微调困境:现有少步数蒸馏方案如LCM、DMD2依赖大规模数据集和长时间训练,且一旦微调极易导致图像模糊或语义失真,实用性受限。

效率与泛化的两难:如何在极低数据量(甚至单样本)和有限算力条件下,既实现显著加速又不牺牲生成质量?Glance为此提供了全新解法。

提出的方案

Glance框架基于对扩散过程的深入观察——早期阶段主导全局语义生成,后期则聚焦纹理细节。据此,系统引入两个阶段专属的LoRA专家:

Slow-LoRA:负责高噪声阶段(前20步左右),以较低加速比保留关键语义结构;

Fast-LoRA:接管低噪声阶段(后30步),以高倍率跳步快速完成细节渲染。

为确保加速轨迹的准确性,Glance采用流匹配(Flow Matching)作为监督信号,直接让LoRA学习目标速度场,而非传统分数匹配路径,从而在极少样本下高效提取生成先验。

应用的技术

LoRA(低秩适配):通过在预训练权重旁路注入低秩矩阵,实现参数高效微调,避免全模型更新带来的显存压力。

流匹配目标函数:绕过冗余的噪声尺度估计,直接回归从噪声到干净图像的连续速度场,极大提升小样本下的训练稳定性。

信噪比(SNR)驱动的阶段划分:以物理意义更明确的SNR替代简单时间步索引,动态界定“慢”与“快”的边界,使专家分工更契合扩散过程的本质特性。

达到的效果

在FLUX.1-12B与Qwen-Image-20B两大主流文生图模型上,Glance将推理步数压缩至8–10步,实现约5倍加速。

生成质量几近无损:在OneIG-Bench、HPSv2和GenEval三大权威评测中,性能分别达教师模型的92.60%、99.67%和96.71%,视觉细节与语义一致性高度保留。

泛化能力突出:即便仅用一张图片训练,模型仍能准确响应包含文字、多对象、风格迁移等复杂提示,展现出超越数据规模限制的适应性。

实验验证表明,Glance的“慢-快”非对称设计优于均匀跳步或单一LoRA方案;而训练数据从1张增至100张并未带来显著收益,印证了阶段对齐与目标函数设计比数据量更为关键。最终,这一轻量、高效、即插即用的加速范式,为大规模扩散模型在资源受限环境下的部署开辟了新路径。