被誉为人工智能界“奥斯卡”的NeurIPS 2025大会刚刚闭幕,全球顶尖研究者再次齐聚一堂,揭晓了本年度最具突破性的研究成果。被NeurIPS接收论文已属难能可贵,而斩获最佳论文奖,则几乎等同于在AI学术圈获得“终身成就”的敲门砖。今年的七项获奖研究,从语言模型的同质化危机到神经网络深度的极限探索,每一项都直指当前AI发展的核心瓶颈。

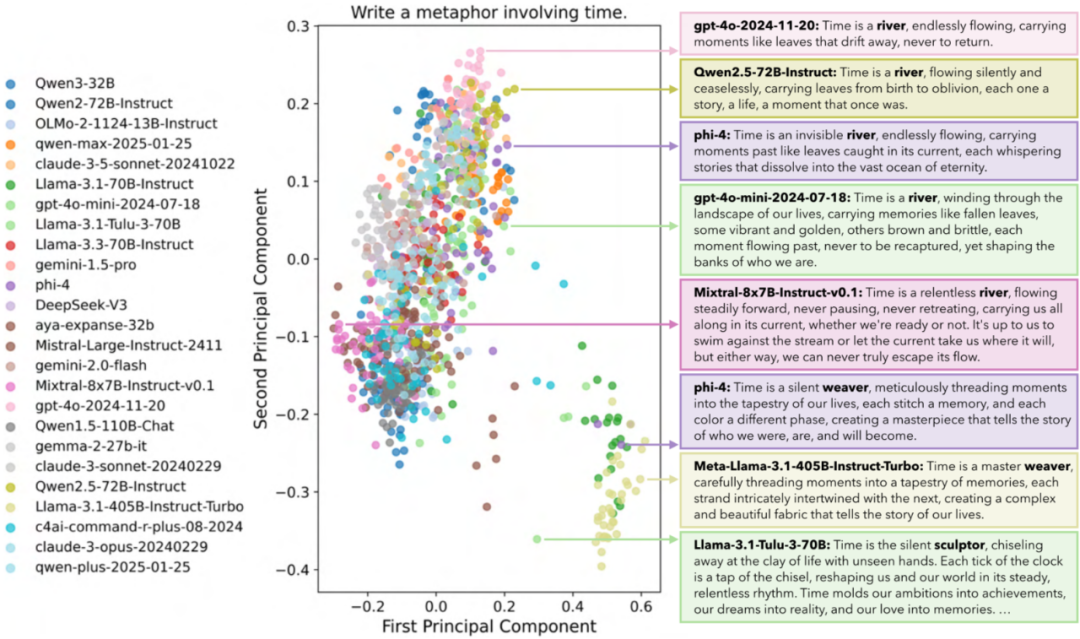

这些成果听起来或许高深莫测,但其实与我们日常使用AI工具息息相关。比如,你是否曾觉得ChatGPT、Claude、通义千问甚至豆包给出的回答越来越雷同?这并非错觉——而是真实存在的“人工智能群体思维效应”。

由华盛顿大学、卡内基梅隆大学与艾伦研究所联合完成的冠军论文《人工蜂巢思维》揭示了一个惊人事实:即便使用70多个不同语言模型,对同一开放性问题的回应仍高度趋同。更令人担忧的是,单个模型在多次生成中也会不断重复自身逻辑。这种现象严重限制了AI在创意生成、策略规划等场景中的实用性。研究团队指出,要打破这一困局,必须从训练目标和评估体系上进行根本性重构。

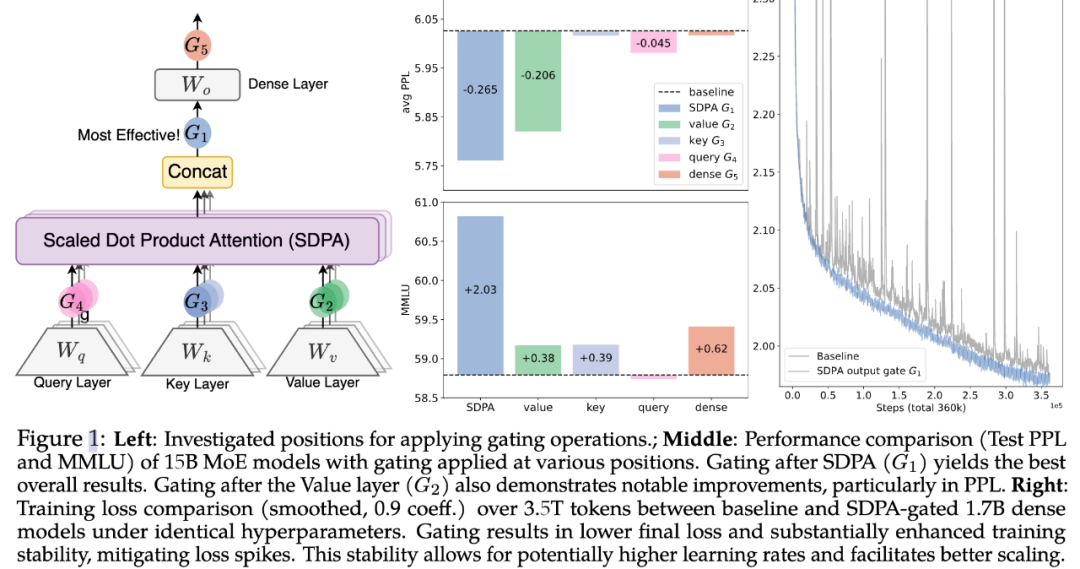

另一项来自阿里巴巴Qwen团队的获奖研究则带来了切实可行的优化方案——“面向大型语言模型的门控注意力机制”。研究人员在传统注意力层后引入一个轻量级“门控”模块,相当于为信息流加装智能过滤器。在对30余种模型变体、最高达150亿参数的测试中,该机制显著提升了长上下文理解和推理连贯性。更令人振奋的是,这项技术已集成至Qwen3-Next,并以开源形式发布。NeurIPS评审团直言:“这将成为行业标配。”预计未来一年内,GPT-5、Gemini 2.0等主流大模型都将采纳类似设计。

在强化学习领域,巴黎文理研究大学的团队挑战了层数极限,成功构建出拥有1024层的自监督强化学习网络。传统RL模型通常仅用2至5层,而此次实验表明,深度扩展可带来2至50倍的性能跃升。这意味着Physical AI(如自动驾驶、工业机器人)有望摆脱“即时反应”模式,真正具备长期目标导向的学习能力。

普林斯顿大学与华沙理工大学合作的研究则从数学层面解释了为何Stable Diffusion等扩散模型不会直接复制训练图像。他们发现,模型训练存在两个时间尺度:前期聚焦图像生成质量,后期才进入记忆阶段。而记忆能力随数据集线性增长,因此存在一个“最佳停止点”——恰在过拟合发生前终止训练,从而确保生成内容的新颖性与安全性。

此外,清华与上海交大联合实验室的论文对当前热门的强化学习推理能力提出质疑。实验证明,RL微调仅能优化基础模型已有路径的利用效率,并未真正拓展其推理边界。换言之,若底座模型缺乏逻辑根基,再多的强化训练也只是“应试技巧”,无法催生真正的智能跃迁。

值得关注的是,谷歌虽未摘得最佳论文,却悄然发布了名为Titans的新型架构,通过“惊喜度量”机制赋予AI类人记忆能力。该系统会评估新信息与已有知识的差异度——越是意外的内容越被优先存储。测试显示,Titans可在参数量低于GPT-4的情况下处理超200万词元上下文,在长文档理解、跨会话记忆等任务中表现卓越。这一突破或将彻底解决当前大模型“健忘症”难题。

综观本届NeurIPS,从多样性危机到记忆机制,从模型规模定律到推理本质,每一篇获奖论文都在为下一代AI铺路。未来半年,我们或将看到更多强调“输出差异化”“深度推理”或“超长记忆”的产品涌现——而这一切的种子,已在2025年的这场学术盛会中悄然埋下。