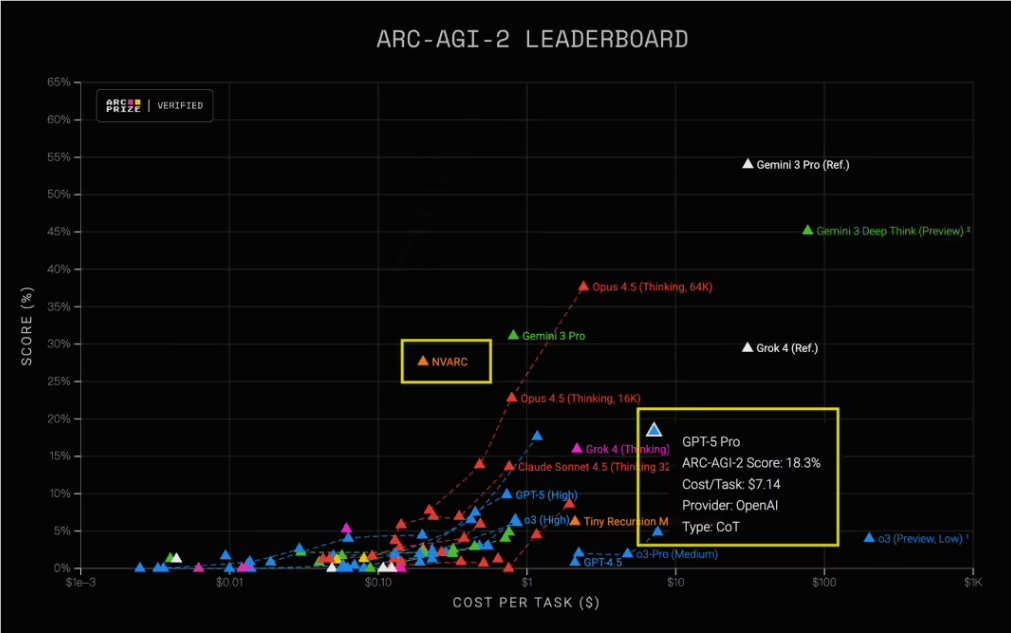

人工智能赛道再起波澜,英伟达最新推出的4B参数小模型 NVARC 在权威评测 ARC-AGI2 中以27.64% 的准确率强势登顶,大幅超越 GPT-5Pro 的18.3%。更令人瞩目的是,NVARC 单次任务推理成本仅为0.2美元,相较 GPT-5Pro 高达7美元的开销,堪称“性价比天花板”。这场胜利不仅刷新了人们对小模型能力的认知,也重新定义了高效AI系统的构建逻辑。

NVARC 的突破性表现源于其摒弃传统预训练路径的零预训练深度学习架构。不同于主流大模型依赖海量通用语料进行预训练,NVARC 从源头规避了数据偏见与领域泛化难题。ARC-AGI2 评测本身极具挑战性——它要求模型在完全未见过的任务设定下,仅凭少量示例快速理解并解决全新问题,这恰恰是对模型泛化与推理能力的极限考验。

为实现这一目标,英伟达团队设计了一套高度创新的离线合成数据生成机制。他们借助开源大模型 GPT-OSS-120B 构建了一个自动化谜题工厂:首先从现有基准集中提取原始问题,再通过逻辑组合与规则变换生成结构更复杂、语义更丰富的新型任务。整个流程被拆解为多个可独立验证的推理阶段,确保每一条合成样本的逻辑严谨性与多样性。最终,这套系统产出一个包含320万条高质量增强样本的训练语料库,成为 NVARC 能力跃升的关键燃料。

在模型架构层面,NVARC 融合了改进版 ARChitects 推理框架,并引入对话式模板对输入谜题进行结构化解析,显著降低了理解门槛。训练阶段则依托 NeMo RL 强化学习框架与 Megatron 分布式后端,实施精细化的监督微调。尤为关键的是,团队采用 TTFT(Task-Tuned Fine-Tuning)策略,针对每个具体任务动态调整模型参数,使其能在极短时间内掌握新规则,实现“即插即用”式的任务适配。

尽管外界不乏质疑声,认为此类模型不过是“高分做题家”,但 NVARC 的真正价值在于证明了小模型在特定高阶推理场景中的可行性与优越性。在算力成本高企、部署环境受限的现实背景下,轻量、高效、低成本的模型反而更具落地潜力。未来AI发展的方向或许并非一味追求参数膨胀,而是将合适的技术方法精准匹配到合适的业务场景中——NVARC 正是这一理念的最佳注脚。