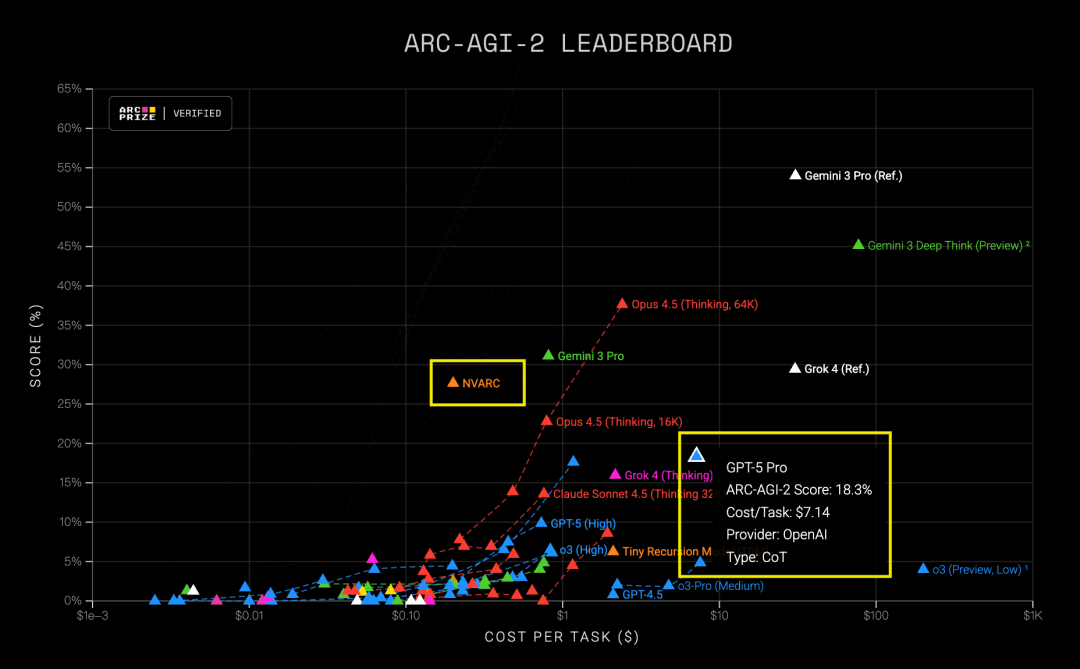

在人工智能竞赛的赛道上,一场由小模型掀起的风暴正在悄然改变游戏规则。最新公布的ARC-AGI 2榜单显示,英伟达推出的NVARC模型以27.64%的准确率强势登顶,不仅将GPT-5 Pro(18.3%)远远甩在身后,更以其惊人的性价比引发行业热议——单任务推理成本仅为20美分,不到GPT-5 Pro七十分之一。

这场胜利的背后,并非依赖参数规模的“暴力美学”,而是一套精巧设计的技术路径:用离线合成数据替代在线复杂推理,把计算重担前置,让上线模型轻装上阵。面对Kaggle赛事严格的资源限制,NVARC团队另辟蹊径,放弃直接调用大模型进行实时推导,转而构建了一条高吞吐、可验证的合成数据流水线。

他们整合H-ARC与BARC中的基础谜题,通过系统性组合生成新样本,借助如GPT-OSS-120B等开源大模型批量生产高质量训练对。整个流程被拆解为多个独立验证阶段,确保每一步输出可靠。最终,一个包含超过320万组增强样本的数据集诞生,每个样本最多涵盖7组输入输出配对,为小模型注入了强大的泛化能力。

核心技术基于改进版ARChitects框架,主干采用Qwen3-4B这一中等体量模型,通过对话式提示模板降低理解门槛。训练过程依托NeMo RL与Megatron后端完成监督微调,但真正拉开差距的关键,在于“测试时微调”(TTFT)策略的引入。

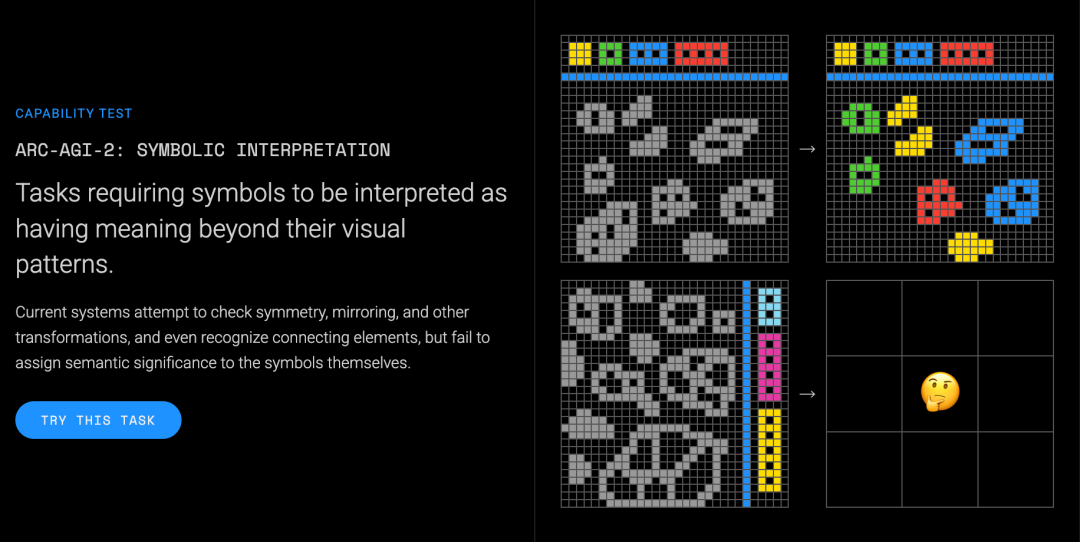

针对ARC-AGI 2“每道题即一全新世界”的特性,NVARC为每个问题单独执行LoRA微调,使模型能在答题前快速适应未知规则。同时,解码阶段的DFS算法经过批处理优化,解决了结果不稳定的问题;并统一调度八类数据增强手段评估候选方案,显著提升了解的鲁棒性。

尽管后期尝试融合TRM方法与额外模型进行集成,受限于算力和机制并未带来质的飞跃,但这已不妨碍其成为当前最优解之一。

有人质疑:这是否只是过度拟合测评场景的“应试专家”?但值得深思的是,AI的价值本就不该被单一维度定义。当通用大模型在追求全能的同时背负高昂成本,这类专注特定任务的小模型反而展现出更强的实用性与部署灵活性。

它们不求通晓万物,只求在关键场景下做到极致高效。正如一位开发者所言:“未来的AI或许不该一味追求‘庞大’,而应更加‘敏捷’。”

这一次,4B参数的NVARC用实力证明:有时候,少即是多,快就是强。方法论的创新,正让“小而美”的模型迎来属于自己的黄金时代。