12 月 11 日消息,阿里通义千问团队于近日正式对外披露其最新研究成果 —— Qwen3-Omni-Flash-2025-12-01,这款被定义为“原生全模态”的新一代大模型已于 12 月 9 日悄然上线,标志着多模态 AI 正式迈入实时交互的新阶段。该模型在原有 Qwen3-Omni 架构基础上实现全面进化,首次实现文本、图像、音频与视频的端到端无缝融合,并支持双向流式输入输出,真正意义上打通了人机交互的感官边界。

据官方技术博客介绍,Qwen3-Omni-Flash 不仅能同步解析多种模态输入内容,还能以极低延迟生成包含自然语音和结构化文本的复合型输出结果。这意味着用户可以在不中断对话流程的前提下,通过语音提问、上传图片或播放短视频等方式发起复杂指令,而模型则能即时反馈语音回应并附带文字说明,整个过程流畅如真人交流。

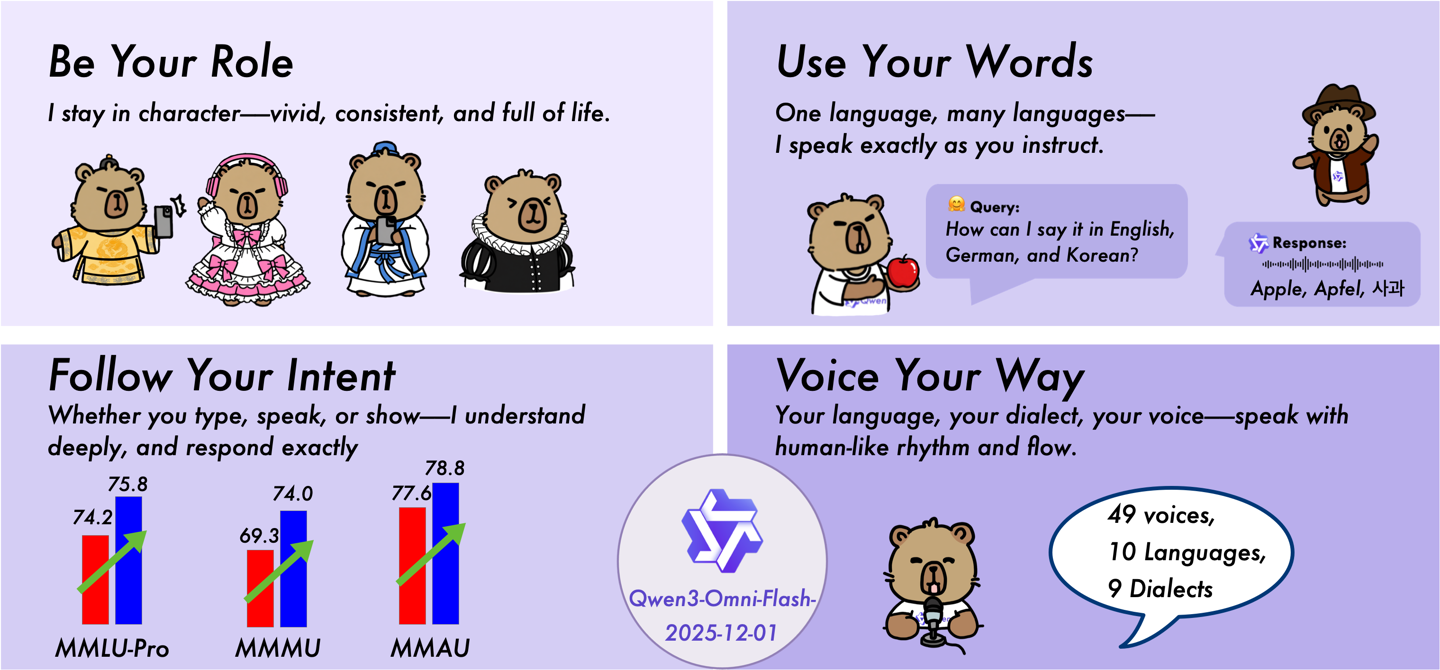

此次升级重点聚焦于提升真实场景下的交互质感。过去,语音驱动的 AI 常因语调单一、节奏呆板而被诟病“像机器人”,而新模型通过引入动态韵律建模机制,实现了对语速、重音与停顿的智能调控。无论是日常闲聊还是专业讲解,其语音输出均展现出高度拟人化的表达能力,情绪起伏更细腻,节奏控制更精准,极大缓解了口语交互中的“降智感”问题。

尤为值得关注的是,Qwen 团队首次全面开放了系统级提示词(System Prompt)的自定义权限。用户 now 可自由设定模型的人格属性,例如切换为活泼俏皮的“甜妹”语气,或沉稳知性的“御姐”风格,甚至可模拟特定文化语境下的表达习惯,如日系敬语体系。同时,回复长度、话术正式程度、口语化倾向等行为参数也可精细调节,让每个用户都能拥有专属的 AI 交互人格。

在语言覆盖面上,该模型同样表现强劲:支持多达 119 种语言的文本理解与生成,具备 19 种语言的语音识别能力及 10 种语言的高质量语音合成能力,确保在全球化应用场景中保持一致且准确的响应水准。

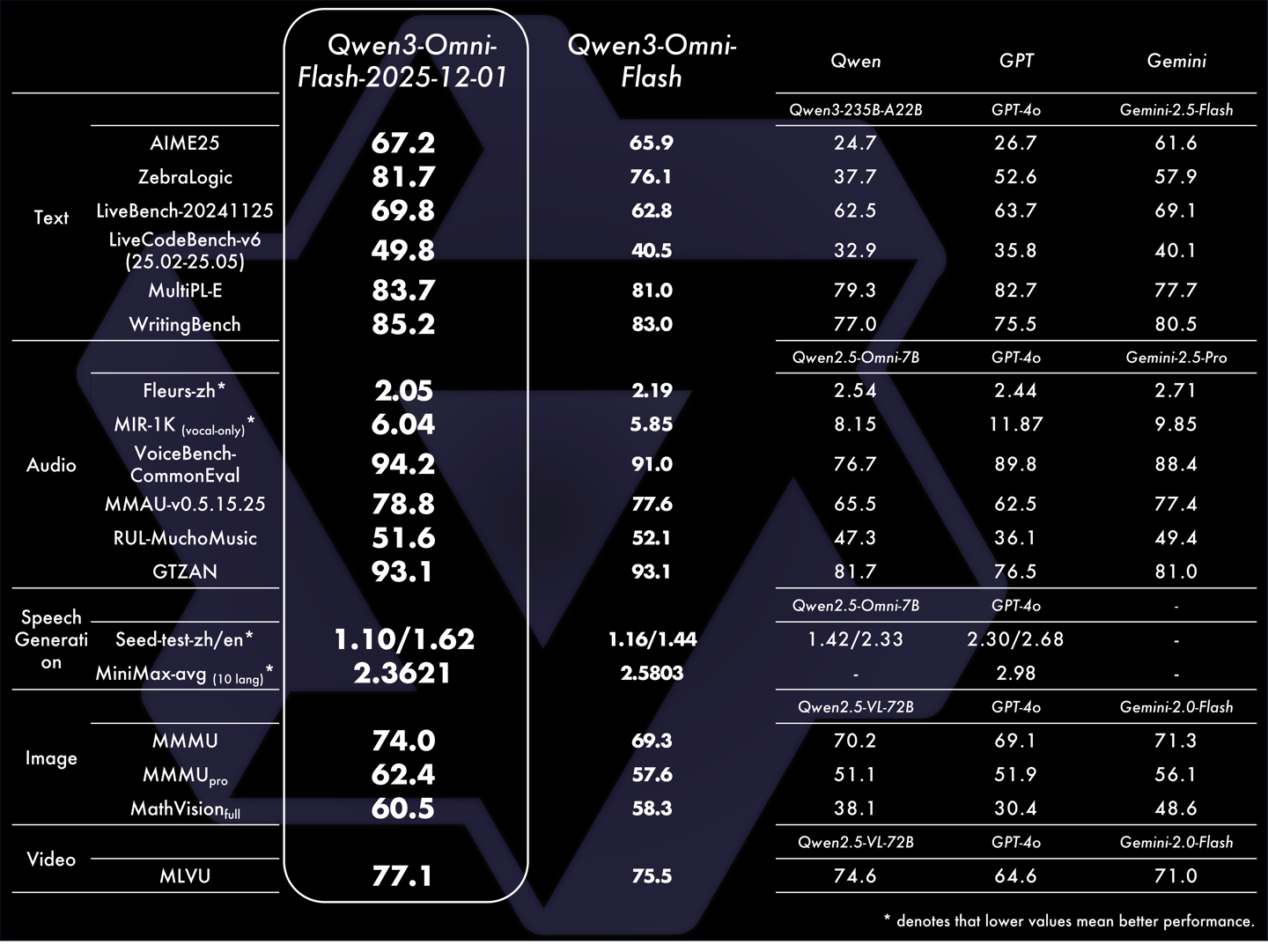

性能层面的数据更具说服力。测试结果显示,Qwen3-Omni-Flash 在逻辑推理基准 ZebraLogic 上得分提升 5.6 分,在代码生成任务 LiveCodeBench-v6 中提高 9.3 分,在多模态视觉理解 MMMU 测评中也上升 4.7 分。这些跃升不仅意味着模型对图像与视频内容的理解更为深刻,更反映出其在复杂指令拆解、跨模态关联推理等方面已达到行业领先水平。