当人工智能与机器人技术的融合日益深入,视觉-语言-行动(VLA)模型正被寄予厚望,被视为通往通用机器人时代的关键路径。然而,现实却暴露出当前主流模型的明显软肋——空间感知能力的严重缺失。像OpenVLA、RT-2这类依赖二维RGB图像作为输入的系统,在面对真实世界中复杂、无序的空间结构时,往往“看得见”却“看不准”,尤其在判断物体深度和空间位置关系上频频失灵,这种被称为“空间失明”的缺陷,极大限制了机器人的实际操作能力。

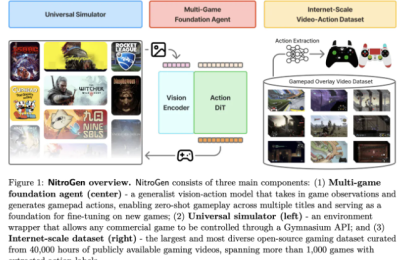

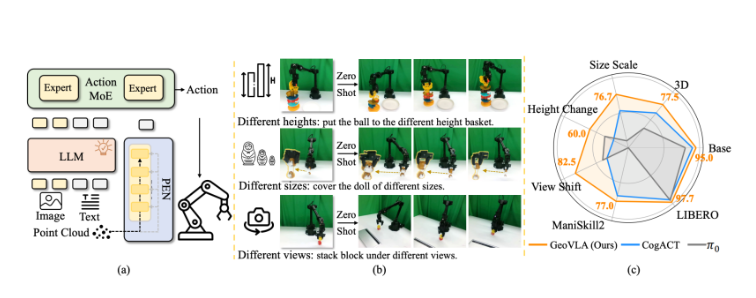

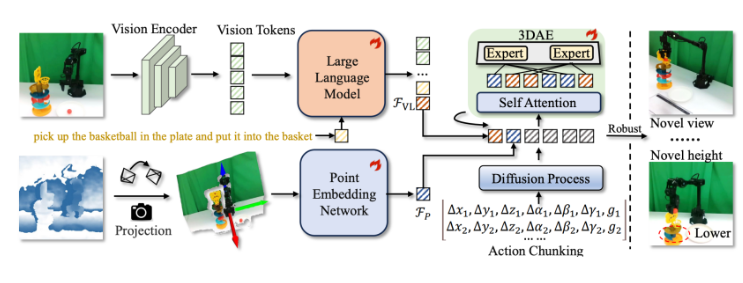

为突破这一瓶颈,原力灵机团队交出了一份全新答卷:GeoVLA。这款新型VLA框架并未抛弃现有视觉语言模型(VLM)强大的语义理解能力,而是通过引入革命性的双流架构,为其补上了三维感知的“眼睛”。其核心创新在于构建了两条并行且协同的信息处理通路:一条是基于点云嵌入网络(PEN)的几何感知通道,另一条则是结合空间感知动作专家(3DAE)的动作决策通路。正是这一设计,让机器人首次真正具备了对周围环境进行立体化、精确化空间建模的能力。

GeoVLA的设计哲学在于任务解耦与功能专精。它让传统的VLM专注于高阶语义理解——即“识别物体是什么”,而将空间定位与几何推理的任务交由专门的点云网络处理——即“确定物体在哪里、如何摆放”。整个框架以端到端的方式整合了三大核心模块:语义理解流、几何感知流与动作生成流,三者高效协作,使机器人在执行抓取、移动、组装等复杂操作时,决策更加精准、动作更加稳健。

实测数据印证了其卓越性能。在权威的LIBERO基准测试中,GeoVLA以97.7%的任务成功率刷新纪录,大幅超越此前的最优模型。而在更具挑战性的ManiSkill2物理仿真环境中,面对形态各异的物体和多变的观察视角,GeoVLA依然展现出极强的适应性与稳定性,成功率遥遥领先。更关键的是,它在分布外(out-of-distribution)场景下的出色表现,证明了其不仅能在标准条件下运行,更能应对真实世界中层出不穷的意外与变化。

这一突破性进展,标志着机器人从“平面认知”迈向“立体智能”的重要一步。GeoVLA所展现的强大鲁棒性与泛化能力,为未来家庭服务、工业自动化乃至特种作业等应用场景打开了新的想象空间,或将加速推动智能机器人真正融入人类日常生活。

项目地址:https://linsun449.github.io/GeoVLA/