AI视频生成技术再次迎来突破性进展,字节跳动携手南洋理工大学推出的开源框架StoryMem正迅速成为社区焦点。该技术成功将现有的单镜头扩散模型升级为具备多镜头叙事能力的智能系统,能够自动生成时长超一分钟、包含多个场景切换且角色与环境高度连贯的完整故事视频,标志着AI在构建连续视觉叙事方面迈出了实质性一步。

记忆驱动:让AI“记住”每一个画面

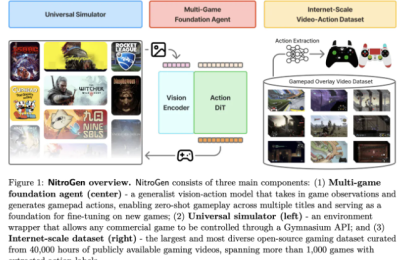

StoryMem的核心在于其独创的“Memory-to-Video”(M2V)机制,灵感来源于人类对事件的记忆方式。系统通过维护一个动态更新的视觉记忆库,持续保存已生成镜头中的关键帧特征。首镜头由标准文本到视频模块生成,并作为初始记忆输入;后续每一帧新镜头的创作,都会调用此前存储的记忆信息,借助M2V LoRA模块将其注入扩散模型中,确保人物外貌、服装细节乃至光影风格在整个视频流中保持一致。

更进一步,系统在每轮生成后自动执行语义分析和美学评分,筛选出最具代表性的关键帧用于记忆刷新。这种闭环式的迭代流程不仅有效规避了传统方法中常见的角色“变脸”或背景突变问题,还大幅降低了对大规模长视频数据集的依赖,仅需轻量级微调即可实现高质量输出。

性能跃升:一致性与画质兼得

实测数据显示,StoryMem在跨镜头一致性指标上相较现有方案提升达29%,在用户主观评价中也获得显著更高的满意度评分。与此同时,它完整继承了底层模型如Wan2.2的高分辨率渲染能力、精准提示遵循性以及灵活的镜头控制功能,支持自然转场与个性化剧情编排,输出效果接近专业影视分镜水准。

为推动行业标准化评估,团队同步发布了ST-Bench数据集,涵盖300组多样化、结构复杂的多镜头叙事指令,旨在为未来研究提供统一的测试基准。

赋能创意产业:从概念到落地的加速器

StoryMem的应用前景广泛覆盖内容生产多个环节:

- 广告营销领域可利用其快速生成不同版本的动态脚本预览,高效完成A/B测试

- 影视制作前期可通过自动化故事板生成,显著降低导演团队的可视化成本

- 独立创作者和短视频从业者则能借此轻松打造具有电影质感的连贯短片,提升作品表现力

生态活跃:开发者社区快速跟进

项目开源后仅数日,已有技术爱好者在ComfyUI平台构建初步工作流,实现本地化部署与长视频生成,极大拓展了其实用性和可访问性。

AIbase观点认为,长时序下的视觉一致性曾是制约AI视频走向实用的主要瓶颈,而StoryMem以极简高效的架构设计实现了关键突破,推动开源模型向真正可用的叙事工具演进。随着未来融合语音、动作等多模态信号,其在数字内容生态中的变革潜力值得期待。

项目地址:https://github.com/Kevin-thu/StoryMem