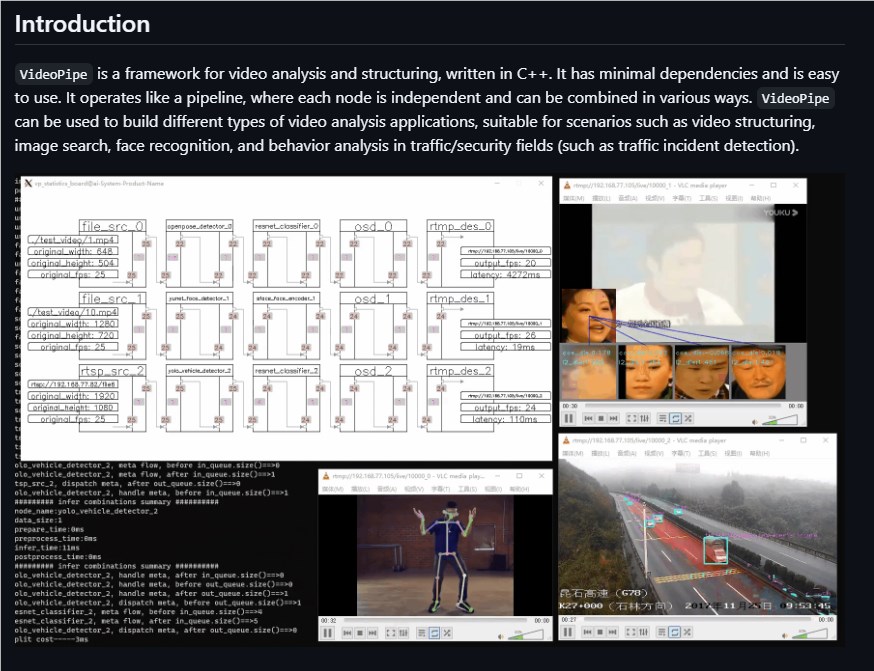

一个名为VideoPipe的开源视频分析框架,正悄然在AI开发者圈层掀起波澜。这款专注于计算机视觉应用快速落地的工具,凭借其高度模块化的设计理念和极简的集成路径,正在重新定义视频智能处理的开发效率。它不只是一款技术框架,更像是为CV工程师量身打造的“乐高套装”,让复杂系统的搭建变得直观而高效。

以管线思维重构视频处理流程

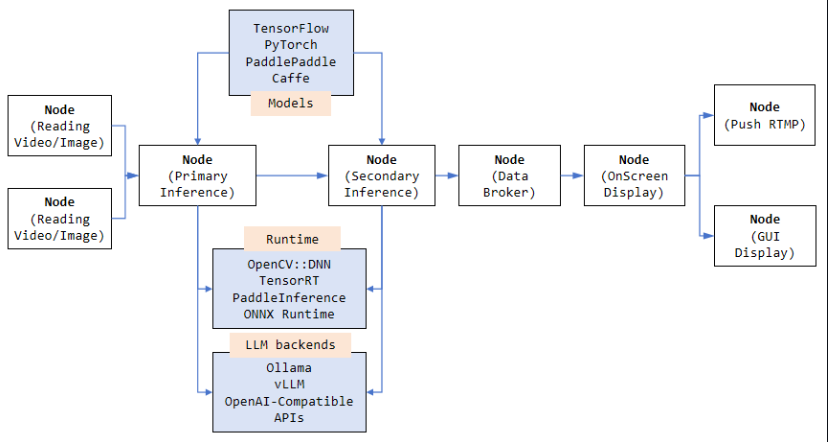

VideoPipe的核心哲学在于“拆解”与“重组”。它将整个视频分析链条抽象为一系列可插拔的功能节点——从视频源拉取、帧数据解码,到模型推理、结果渲染,再到最终推流或存储,每个环节都被封装成独立单元。开发者不再需要通读冗长的SDK文档或手动拼接音视频处理逻辑,而是通过声明式配置,像连接水管一样将所需功能串联起来,形成专属处理流水线。

这种架构极大降低了系统耦合度,使得调试更精准、迭代更敏捷。即便更换底层硬件平台,也只需调整对应节点配置,无需重写整套逻辑,真正实现一次开发、多端部署。

广泛兼容主流输入源,打通数据入口

在实际应用场景中,视频来源往往五花八门。VideoPipe对此展现出惊人包容性:无论是来自城市摄像头的RTSP流、直播场景中的RTMP推流,还是本地MP4文件、UDP组播甚至应用程序内存图像,都能被统一接入并标准化处理。这一特性使其天然适用于智慧交通、工业质检、远程教育等多类实时或离线分析任务。

值得一提的是,框架还支持图片序列批量导入,为静态图像库检索、历史视频回溯分析等非实时场景提供了灵活接口。

算法融合无边界:从经典CV到多模态大模型

如果说输入兼容性解决了“看得见”的问题,那么VideoPipe在“看得懂”层面的拓展则更具前瞻性。它不仅支持YOLO、ResNet等主流深度学习模型的级联推理,还能无缝调用OpenCV中的传统图像算法,实现边缘检测、光流分析等功能。

更令人瞩目的是,框架已原生集成对多模态大模型(如LLaVA、Qwen-VL)的支持,允许开发者将语言理解能力注入视频分析流程。例如,在行为识别任务中,不仅能判断“有人摔倒”,还能结合上下文生成自然语言描述:“一位老人在楼梯口失去平衡,疑似需要救助。”

端到端闭环设计,加速原型转化

从原始视频流入,到结构化数据出,VideoPipe几乎覆盖了全链路功能组件。内置目标跟踪、行为识别、画框标注、截图录屏、消息告警等模块,配合高效的编码推流能力,使开发者能在几分钟内构建出具备完整交互能力的AI应用原型。

典型用例包括但不限于:

- 城市道路违章自动抓拍系统

- 商场客流热力图生成与顾客动线分析

- 工厂产线缺陷检测与质量追溯

- 虚拟主播驱动与实时换脸互动

- 校园安全异常行为预警平台

生态初具规模,学习成本显著降低

社区活跃度是衡量开源项目生命力的重要指标。目前,VideoPipe已提供超过40个开箱即用的示例工程,涵盖人脸追踪、车辆计数、姿态估计等高频需求,并配有详尽文档与实操视频。不少初创团队反馈,借助这些资源,原本需数周完成的POC验证,如今3天内即可交付演示版本。

AIbase观察认为,VideoPipe的崛起标志着CV工程化正迈向“平民化”阶段。它不仅提升了研发效率,更打破了大模型与传统视觉算法之间的壁垒。随着社区生态持续扩展,该框架有望成为下一代智能视频应用的底层基石。项目已在GitHub开源(sherlockchou86/VideoPipe),欢迎关注前沿AI工程实践的开发者前往探索。

项目地址:https://github.com/sherlockchou86/VideoPipe