阿里巴巴达摩院正式开源其最新一代视频生成模型「通义万相Wan2.2」。此次发布包含三大核心模型:文生视频(Wan2.2-T2V-A14B)、图生视频(Wan2.2-I2V-A14B)以及创新的统一视频生成模型(Wan2.2-IT2V-5B),标志着AI视频创作技术迈入新纪元。

突破性MoE架构,效率提升50%

通义万相Wan2.2首次将MoE(专家混合)架构应用于视频生成领域。该设计有效解决了传统模型处理长序列时的算力消耗问题。虽然模型总参数高达27B,但通过仅激活14B参数的方式运行,成为业界首个采用MoE结构的视频生成系统。

该架构通过高噪声专家负责画面布局、低噪专家专注细节精修的分工协作,在保持相同参数规模的前提下,计算资源消耗降低近半。这不仅大幅提升生成效率,更在动作连贯性、场景真实感和艺术表现力等方面实现突破。

电影级美学控制,轻松打造专业质感

值得一提的是,新模型引入了「电影美学控制系统」。用户只需输入「黄昏柔光」「冷色调硬光」等关键词组合,就能生成符合影视工业标准的画面。从浪漫的夕阳场景到未来感的科幻画面,模型能精准还原光影、色彩和构图等专业元素。

测试数据显示,模型生成的人物微表情自然度达到商业级动画制作水准,显著优于同类开源模型。

轻量模型赋能消费级设备

为降低使用门槛,同步开源的统一视频生成模型(Wan2.2-IT2V-5B)仅需单张22G显存显卡,即可在几分钟内生成5秒720P视频。该模型采用高压缩率3D VAE架构,时空压缩比达4×16×16,是目前速度最快的开源视频基础模型之一。

注意:实际生成时间会因硬件配置不同有所波动,建议使用RTX 3090及以上显卡获得最佳体验。

全链路开放,共建AI视频生态

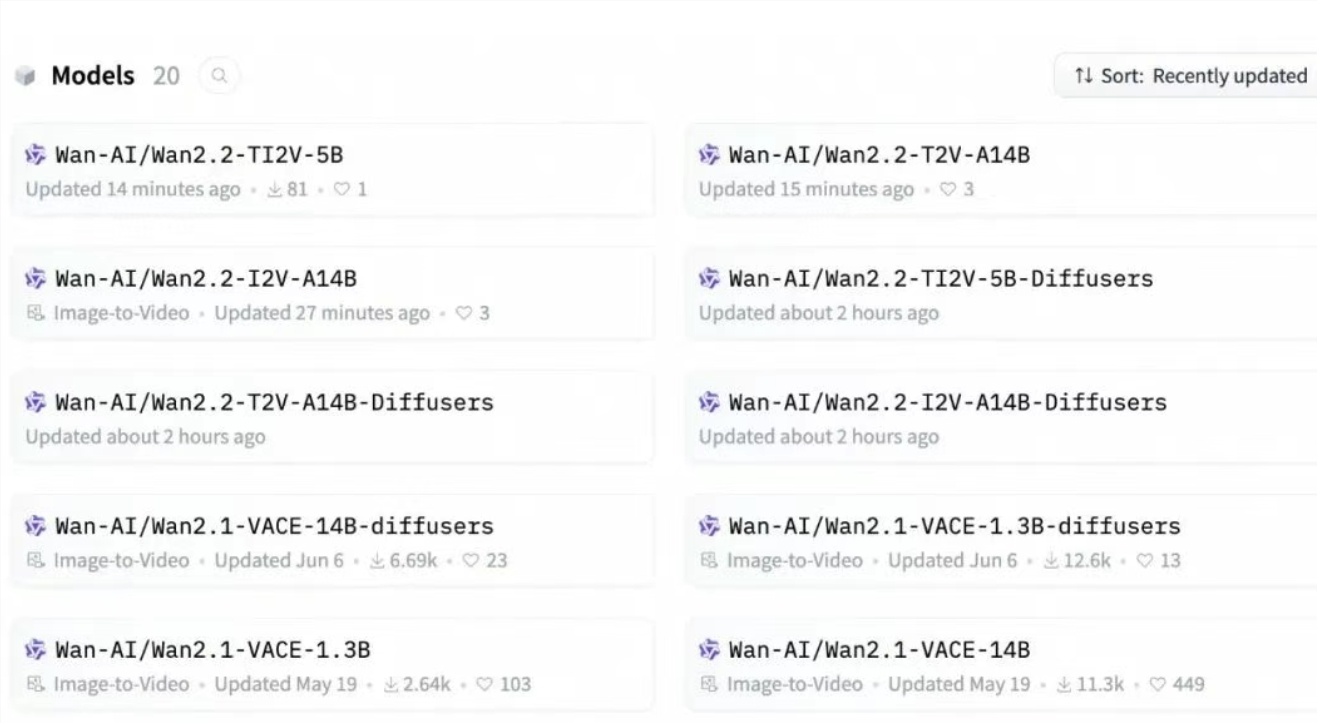

开发者现可通过以下平台获取资源:

GitHub: https://github.com/Wan-Video/Wan2.2

HuggingFace: https://huggingface.co/Wan-AI

魔搭社区: https://modelscope.cn/organization/Wan-AI

自今年2月以来,通义万相系列模型累计下载量已突破500万次,持续推动AI视频技术普及。