8月21日消息,深度求索团队今日正式发布新一代大模型 DeepSeek-V3.1,标志着其在智能推理与应用集成能力方面实现重大突破。此次更新不仅强化了核心技术,还全面优化了用户体验与生态兼容性,进一步巩固了其行业技术领先地位。

- 全新混合推理架构:单模型无缝支持“思考”与“非思考”双模式,用户可根据任务复杂度自由切换;

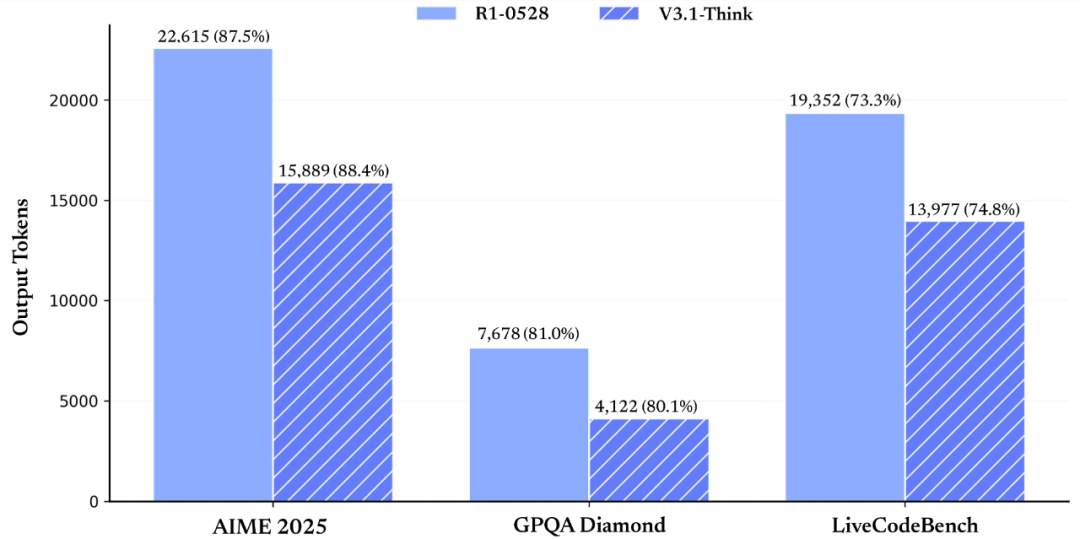

- 推理效率显著提升:相比前代 DeepSeek-R1-0528,V3.1 思考模式在保持准确率的同时响应更快、输出更精炼;

- 智能体能力增强:通过精细化后训练优化,新模型在工具调用、任务规划等 Agent 场景中表现更出色。

目前,深度求索官方 App 及网页端均已升级至 V3.1 版本。用户只需点击“深度思考”按钮,即可灵活切换两种模式,满足从快速问答到复杂分析的多样化需求。

API 接口也同步升级:deepseek-chat 对应非思考模式,deepseek-reasoner 专为深度推理设计,两者均支持高达 128K 的上下文长度。此外,API Beta 接口现已支持 strict 模式的函数调用,确保输出严格符合预定义结构,显著提升系统集成的稳定性和可靠性。

值得一提的是,本次更新还新增了对 Anthropic API 格式的支持。开发者可轻松将 DeepSeek-V3.1 集成至 Claude Code 框架,实现跨平台能力调用,极大拓展了实际开发场景的适用性。

智能体能力全面进化

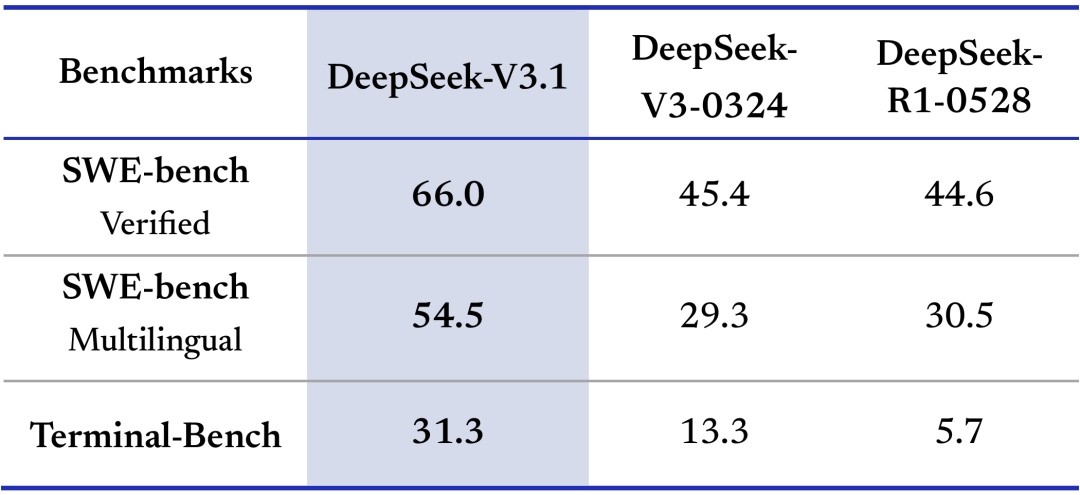

编程智能体表现亮眼

在权威测试集 SWE(代码修复)与 Terminal-Bench(命令行复杂任务)中,DeepSeek-V3.1 展现出远超上代的性能,尤其在多步骤问题拆解与代码生成准确性方面进步显著。

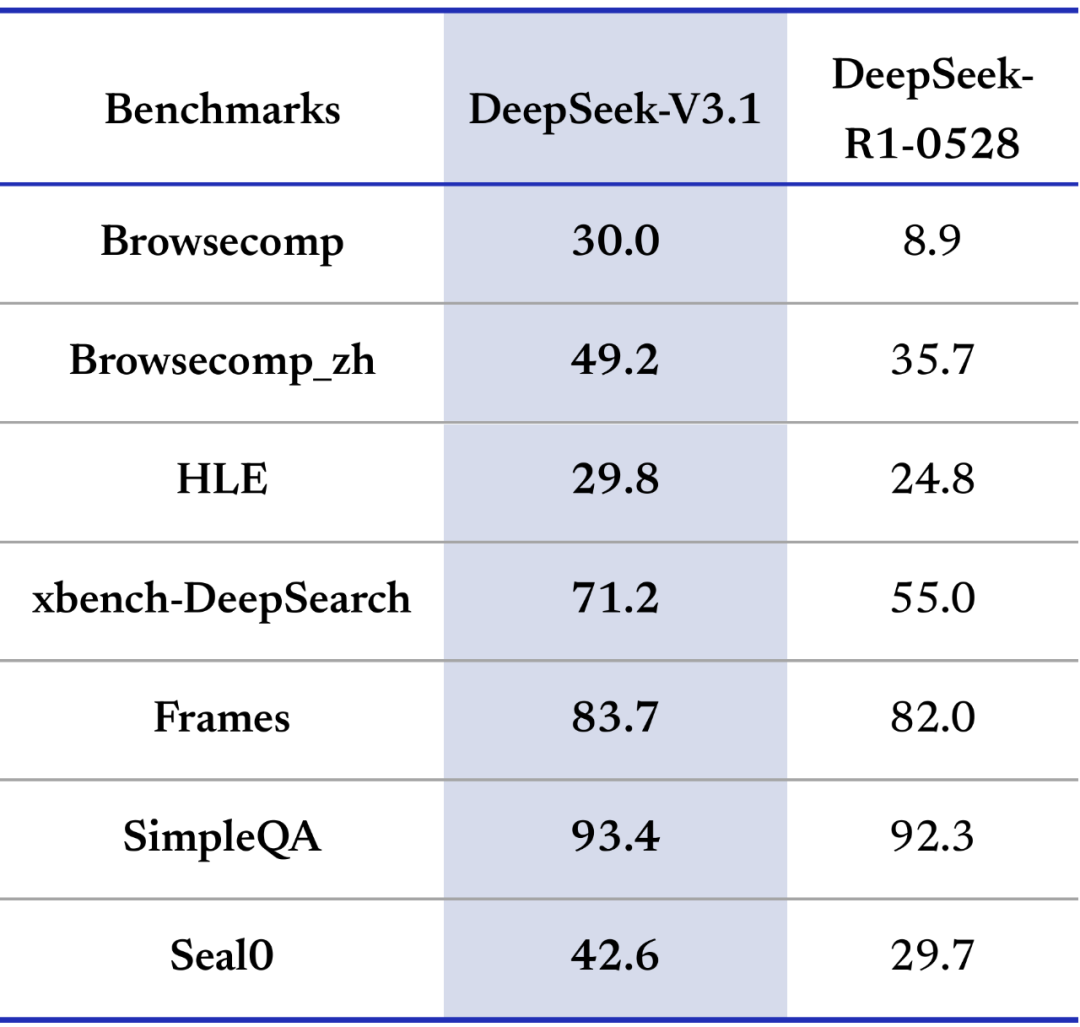

搜索智能体更趋成熟

面对多跳推理的 browsecomp 测试与跨学科专家级难题 HLE,V3.1 在搜索精度与响应效率上均实现大幅提升,处理跨领域复杂信息检索时逻辑组织能力更强。

思维链优化,效率跃升

官方测试数据显示,得益于思维链压缩训练技术,V3.1-Think 模式在输出 token 数减少 20% 至 50% 的同时,任务完成质量与 R1-0528 持平,真正实现“更快更聪明”。非思考模式的输出长度也得到有效控制,在性能不变的前提下显著降低资源消耗。

开源与部署支持升级

全面开源,开放共享

DeepSeek-V3.1 Base 模型在原有基础上新增 840B tokens 的扩展训练,现已在 Hugging Face 与魔搭平台全面开源,后训练模型也同步开放。

开源地址如下:

- Hugging Face Base 模型:

https://huggingface.co/deepseek-ai/DeepSeek-V3.1-Base - 魔搭 Base 模型:

https://modelscope.cn/models/deepseek-ai/DeepSeek-V3.1-Base

后训练模型地址:

- Hugging Face:

https://huggingface.co/deepseek-ai/DeepSeek-V3.1 - 魔搭:

https://modelscope.cn/models/deepseek-ai/DeepSeek-V3.1

需特别注意的是,V3.1 采用 UE8M0 FP8 Scale 参数精度,且分词器与对话模板较 V3 有较大调整,建议部署用户详细阅读新版文档以确保兼容性。

价格策略调整预告

自北京时间 2025年9月6日凌晨 起,DeepSeek 开放平台将执行新版 API 调用价格策略,具体费率详见官方定价页面,夜间时段优惠将同步取消。在此之前,所有服务仍按现行政策计费。为保障服务稳定性,平台已进一步扩容 API 资源,以应对持续增长的调用需求。