在生成式人工智能席卷全球的背景下,视频内容的生产与修复技术正迎来重大突破。阿里云最新推出的开源项目Vivid-VR,凭借其卓越的视频帧一致性与画质还原能力,迅速成为影视技术圈的热门话题。许多内容创作者和开发者将其视为“救星”级工具。

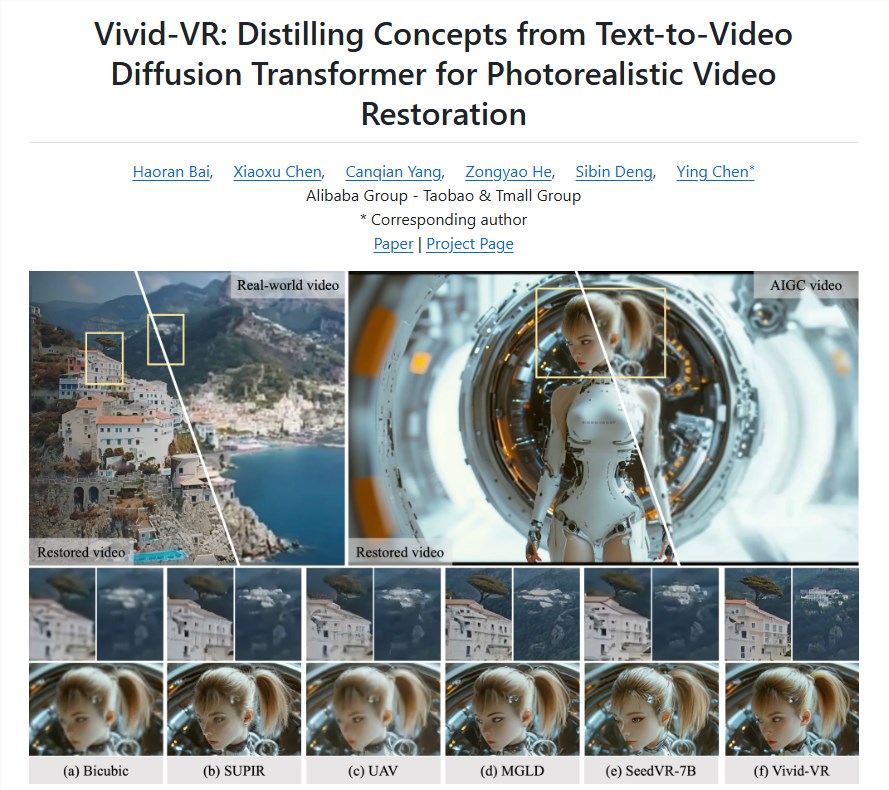

Vivid-VR 是一款基于文本到视频(T2V)基础模型开发的生成式视频修复系统。它创新性地融合了ControlNet控制机制,不仅能精准识别视频中的异常帧,还能在修复过程中保持语义连贯性,有效解决闪烁、跳帧和抖动等传统难题。无论是老片修复,还是AI生成视频的质感断裂问题,Vivid-VR 都能实现流畅自然的视觉还原,让低质量素材重获新生。

该系统的核心技术在于T2V模型与ControlNet的深度协同。T2V负责生成高保真视频内容,而ControlNet则像一位“视觉指挥”,实时调控每一帧的画面结构与运动轨迹,确保时间轴上的视觉连贯。此外,系统还能动态优化纹理细节,使修复后的画面不仅稳定,也更真实沉浸。这种双重技术加持,让Vivid-VR 在处理复杂动态场景时表现尤为出色,智能水平远超传统插值算法。

值得一提的是,Vivid-VR 并不局限于特定视频类型。无论是手机拍摄的模糊片段、监控录像中的噪点画面,还是AIGC生成的不稳定内容,它都能高效重建与增强。对短视频创作者、影视后期团队乃至档案修复机构来说,这意味着大量废弃素材可重新利用,显著提升了创作的容错率和自由度。该系统还支持多种输入格式,允许开发者自定义修复强度与风格参数,灵活性强。

Vivid-VR 的出现,标志着视频修复从“修补”迈入“智能重塑”的新阶段。

阿里云此次将Vivid-VR全面开源,为全球技术社区注入了新动力。项目代码及预训练模型已同步发布在GitHub、Hugging Face和ModelScope平台,免费向公众开放。这一做法延续了其广受欢迎的Wan2.1系列模型的开源传统——该模型累计下载量已突破220万次,并在VBench评测中稳居第一。通过开放底层技术,阿里云正在推动更加包容、协作的AI视频生态的形成。

展望2025年,高质量视频已成为品牌传播、社交互动和文化传承的核心载体。然而画质问题始终是制约创作效率的瓶颈之一。Vivid-VR 不仅提供了低成本、高效率的解决方案,更预示着行业迈向智能化重塑的重大转折。分析认为,随着这类生成式工具的普及,未来内容生产将更依赖AI辅助,推动整个行业向自动化、智能化深度演进。

Vivid-VR 的发布不仅是技术飞跃,更是开源精神与创作民主化的重要体现。它让顶尖AI技术走出实验室,真正服务于一线创作者。可以预见,围绕该工具将涌现更多创新应用与实践,持续拓展视频艺术与技术的可能边界。

项目地址:https://github.com/csbhr/Vivid-VR