8月26日,科技资讯网站9to5Mac援引苹果公司最新发布的学术论文称,其研究团队提出了一种名为“基于清单反馈的强化学习”(Reinforcement Learning from Checklist Feedback,简称RLCF)的新型训练机制。该方法旨在显著提升大语言模型处理复杂、多层次指令的能力,突破了当前主流训练范式,为AI模型的精细化调优提供了新思路。

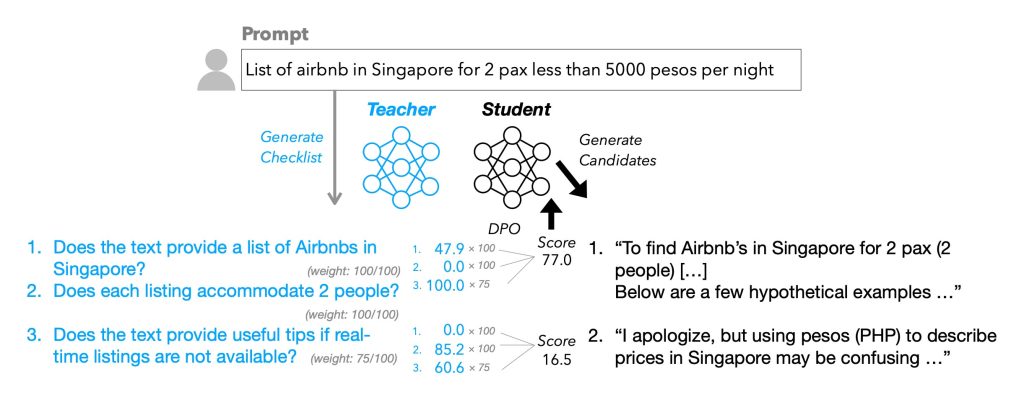

与依赖人类“点赞”或“点踩”的传统RLHF方法不同,RLCF的核心创新在于引入结构化任务清单作为反馈依据。系统会为每一条用户指令生成详细检查清单,其中每项任务均可进行0至100分的量化评分,从而为模型提供更精确、可操作的优化信号。这种机制特别适用于多步骤、多条件的复杂任务,能显著提升模型的任务完成质量。

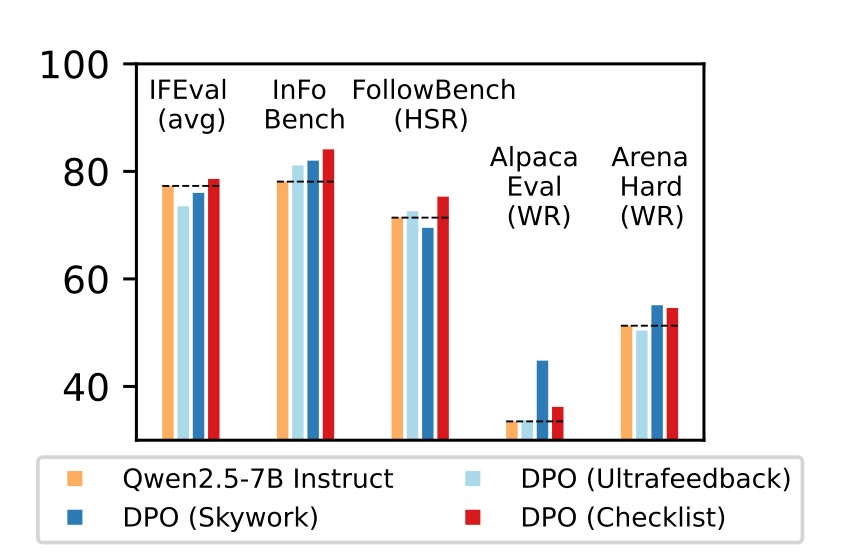

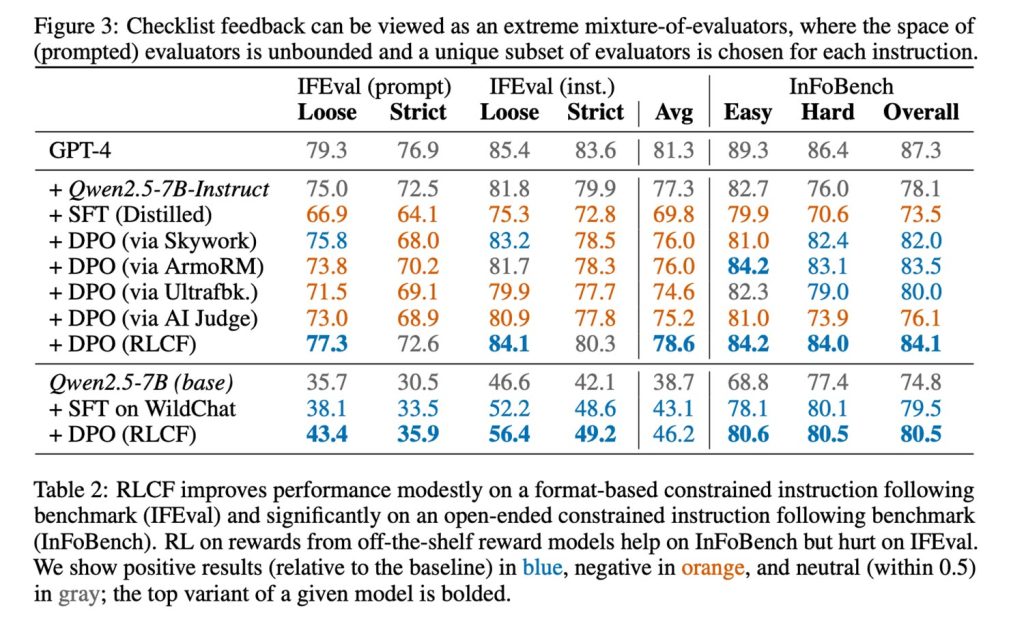

实验数据显示,RLCF成为唯一在所有测试基准上均实现性能提升的方案,部分任务优化幅度高达8.2%

研究团队在Qwen2.5-7B-Instruct模型上进行了验证,测试覆盖FollowBench、InFoBench和Arena-Hard等五个主流基准。结果显示:RLCF在FollowBench的硬性满意率提升4%,InFoBench得分提高6点,Arena-Hard的人类偏好胜率上升3%。这证明清单式反馈能有效提升模型处理复杂任务的能力。

值得一提的是,为构建训练数据集,团队借助更强的Qwen2.5-72B-Instruct模型,为超过13万条指令生成了名为“WildChecklists”的评估清单。这些清单包含清晰的二元判断条目(如“是否已将文本翻译为西班牙语?”),由大模型对候选回答逐项核对评分,最终加权生成奖励信号来指导小模型训练。

不过研究人员也指出RLCF的局限性:其一,该方法依赖高性能“评判模型”生成清单,对计算资源要求较高;其二,它主要提升任务执行的准确性和完整性,并未涉及安全性对齐,因此不能替代传统安全评估流程。此外,其普适性仍需进一步验证。

尽管存在这些限制,RLCF仍为大模型的精细化训练提供了创新方向,有望推动AI更可靠地处理复杂指令。