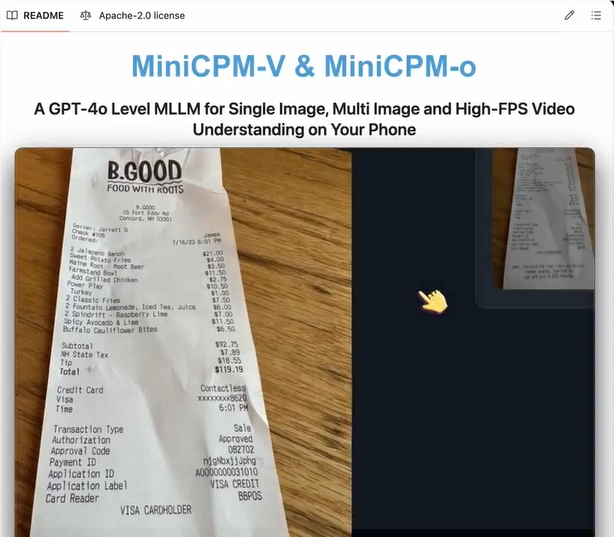

近日,人工智能领域再次迎来突破性进展,一款专为移动终端设计的开源多模态大语言模型MiniCPM-V4.5正式亮相。该模型仅以8亿参数量级,便实现了在智能手机与平板设备上的流畅运行,标志着端侧AI能力迈入全新阶段,为本地化智能应用的普及注入强劲动力。

轻量高效,性能表现亮眼

MiniCPM-V4.5的核心设计理念在于“轻量化”与“高效化”。开发团队通过深度优化架构,使其在保持强大能力的同时,完美适配资源受限的移动设备。在权威评测平台OpenCompass的综合测试中,该模型斩获77.2分,超越众多同级别开源竞品,展现出卓越的综合理解能力。无论是单张图像解析、多图逻辑推理,还是动态视频内容分析,MiniCPM-V4.5均能从容应对。

实际部署测试显示,模型在iPhone16Pro Max上的响应速度令人印象深刻——首token生成延迟控制在约2秒内,后续解码速率稳定在每秒17 token以上。尤为值得一提的是其视频处理能力:借助创新的3D-Resampler技术,视频数据压缩率高达96%,仅用64个token即可编码6帧画面,支持最高10FPS的实时视频语义理解,极大提升了移动端视觉交互体验。

在文字识别方面,模型基于LLaVA-UHD架构进行了深度强化,可处理分辨率高达180万像素的图像,在OCRBench测试中准确率达到85.7%。同时,它支持包括中、英、德、法在内的30余种语言,具备出色的跨语言理解潜力。

智能思维机制,灵活应对多样需求

MiniCPM-V4.5引入了一项创新功能——可控混合思维机制。用户可根据任务复杂度,在“快速响应”与“深度推理”两种模式间自由切换。日常问答等简单任务可启用快速模式,实现即时反馈;面对复杂逻辑或多层次分析时,深度推理模式则能通过分步思考提升答案的准确性与完整性。

训练过程中,团队融合了RLAIF-V与VisCPM等前沿技术,显著降低了模型“幻觉”现象的发生概率。这一改进使得输出内容更加贴近事实,增强了结果的可信度与稳定性,为实际应用提供了坚实基础。

全面开源,生态兼容性强

该项目采用宽松的Apache-2.0开源协议,允许学术研究自由使用,商业用途仅需完成简易注册流程。模型提供16种量化版本,适配从低端到高端的多样化硬件环境,并兼容llama.cpp、Ollama、vLLM、SGLang等多种主流推理框架,极大降低了部署门槛。

为方便用户体验,开发团队同步上线了iOS版专属应用,苹果用户可直接在设备上运行模型。开发者可通过GitHub与Hugging Face获取完整代码与文档,支持使用Gradio快速搭建本地Web交互界面,亦可在NVIDIA GPU上实现加速推理,构建高效开发环境。

应用场景广泛,未来可期

MiniCPM-V4.5的诞生,为隐私敏感型应用和离线AI服务提供了理想解决方案。无需依赖云端传输,用户可在本地完成图像识别、文档提取、视频摘要等操作,兼顾效率与数据安全。其低门槛特性也为个人开发者和初创团队打开了创新空间。

当然,受限于8亿参数规模,在处理极端复杂或专业性极强的任务时,性能仍有一定边界。开发团队建议用户根据实际场景合理选型,并强调模型输出内容基于训练数据生成,使用者需确保应用合规并承担相应责任。

推动端侧AI生态发展

MiniCPM-V4.5的发布,不仅是技术上的突破,更是开源精神与实用主义的完美结合。它展现了社区在端侧多模态AI方向的持续探索,预示着未来更多智能功能将“下放”至个人设备。随着移动芯片算力不断增强,此类轻量高效模型有望成为AI普及的关键推手。

其完全开放的生态架构,也为全球研究者提供了宝贵的实验平台,有望激发更多技术创新,加速端侧AI生态的成熟与繁荣。

项目地址:https://github.com/OpenBMB/MiniCPM-V