在AI技术持续渗透影视制作领域的当下,Nvidia再次投下一颗“技术深水弹”,正式推出其最新研发的小型语言模型Nemotron-Nano-9B-v2,迅速在技术圈与内容创作领域引发广泛关注。这款模型的发布,不仅标志着Nvidia在轻量化AI部署上的进一步突破,也预示着影视后期、剧本生成乃至虚拟角色对话系统将迎来更高效、更灵活的底层支持。

与动辄数十亿甚至上百亿参数的“巨无霸”模型不同,Nemotron-Nano-9B-v2以9亿参数的精巧体量,精准切入“高效运行”这一核心痛点。尽管参数规模较初代12亿有所缩减,但其优化目标明确——实现单台Nvidia A10 GPU即可流畅部署。据Nvidia AI模型后训练总监Oleksii Kuchiaev透露,这一调整并非简单“瘦身”,而是基于实际应用场景的深度考量。通过采用创新的混合架构设计,该模型在处理大规模请求时,性能表现可达同类变换器模型的6倍,为影视工作室等资源有限但对响应速度要求极高的用户提供了极具吸引力的解决方案。

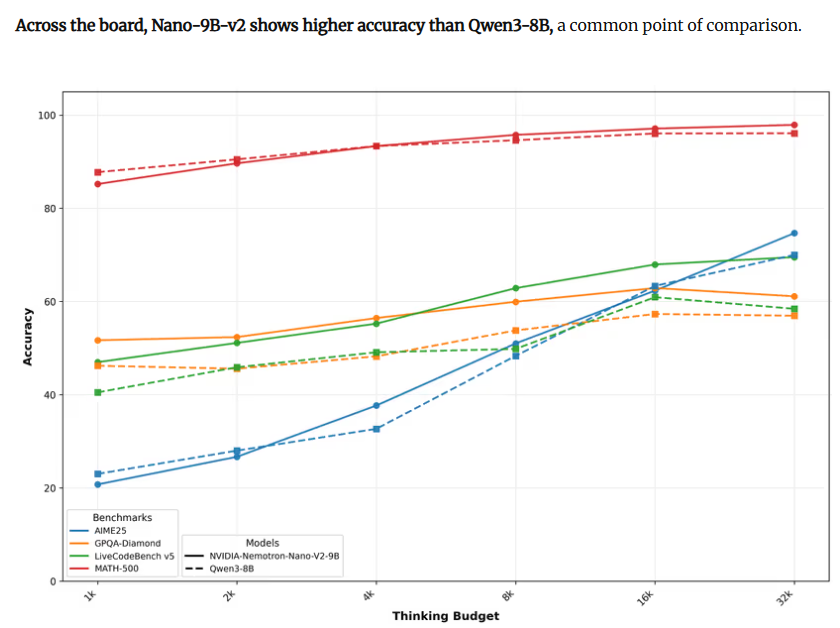

更令人瞩目的是其多语言支持能力,涵盖英语、德语、西班牙语、法语、意大利语、日语等主流语种,使其在跨国影视项目协作中具备天然优势。无论是剧本翻译、角色对白生成,还是本地化字幕制作,Nemotron-Nano-9B-v2都能提供稳定支持。而其最富创意的功能莫过于“推理开关”机制:用户可通过输入/think或/no_think等指令,自由控制模型是否在输出前进行自我验证与逻辑推演。这种“可开关的思考”模式,让创作者能根据场景需求,在严谨性与响应速度间灵活取舍。同时,开发者还可设定“思考预算”,即限定推理过程中消耗的token数量,从而在保证质量的前提下优化计算资源分配。

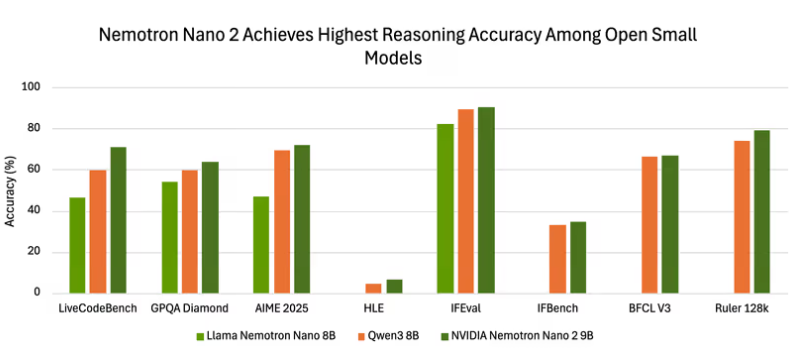

实测数据印证了其不俗实力。在开启推理模式后,该模型于AIME25、MATH500、GPQA及LiveCodeBench等多项权威基准测试中均交出亮眼成绩单。尤其在长文本理解与复杂指令遵循任务中,其表现显著优于同级别开源模型,展现出强大的上下文处理能力,这对于需要连贯叙事逻辑的剧本创作与情节推演尤为重要。

尤为关键的是,Nvidia为该模型配备了完全开放的商业许可协议,允许开发者自由使用、修改与分发,且明确放弃对模型输出内容的所有权主张。这意味着影视公司、独立制片人乃至小型工作室,均可零门槛将其集成至自有系统中,无需担忧授权费用或法律纠纷,极大降低了AI技术的应用壁垒。

可以预见,Nemotron-Nano-9B-v2的出现,不仅为AI模型的小型化、高效化树立了新标杆,更为影视内容生产的智能化转型注入了强劲动力。其灵活的推理控制与开放生态,或将催生一批基于轻量AI的创新应用,推动整个行业迈向更高效、更智能的未来。

划重点:

🌟 Nemotron-Nano-9B-v2以9亿参数实现高效部署,专为单GPU场景优化,性能提升显著。

🧠 独创“推理开关”与“思考预算”机制,用户可按需调控AI的思考深度与响应速度。

📈 开放商业许可,支持自由分发与商用,极大降低影视及内容创作领域的AI应用门槛。