一位刚退休的经济学教授最近用一个看似幼稚的问题,让号称“博士级智能”的GPT-5当场露馅,其表现不仅逻辑混乱,甚至在基础博弈常识上也频频翻车,令人不禁质疑:我们到底在和谁对话?

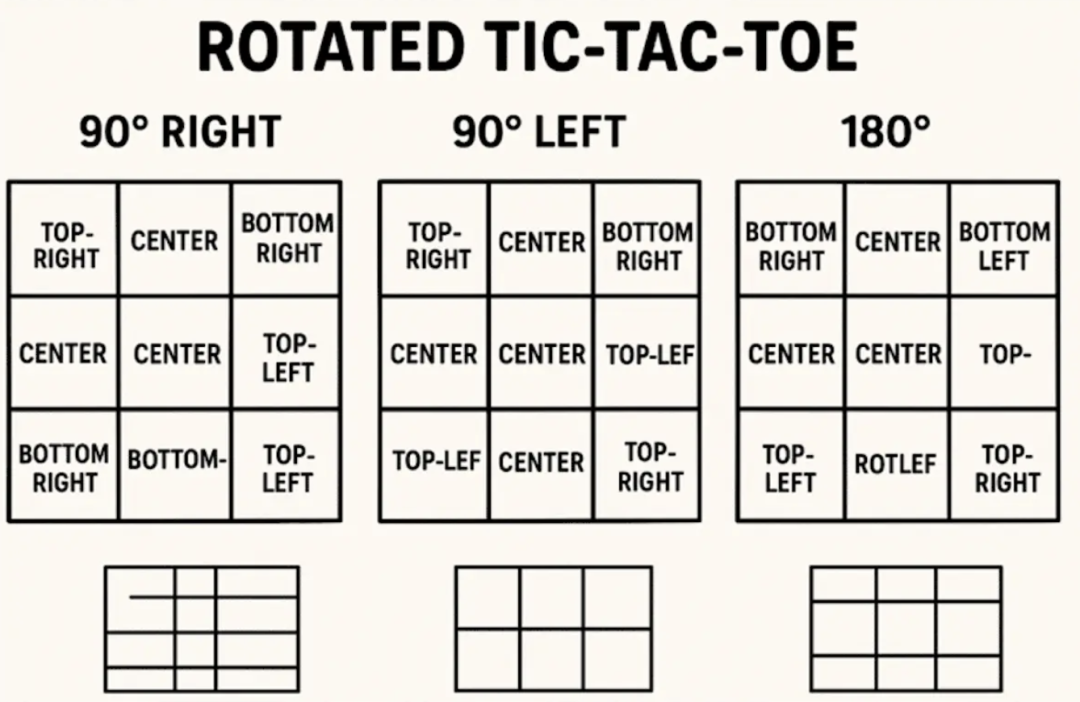

问题源自童年经典——井字棋。教授向GPT-5提出:“如果游戏开始前,把棋盘向右旋转90度,会发生什么?”这本是一个常识性极强的设定:旋转棋盘不会改变游戏规则或胜负逻辑,纯粹是视觉上的调整。

但GPT-5却开启了一段“哲学式”解读:

尽管数学结构未变,但玩家的心理感知可能被影响。习惯了垂直棋盘的人,在面对旋转后的新布局时,或许会误判威胁与机会的分布。

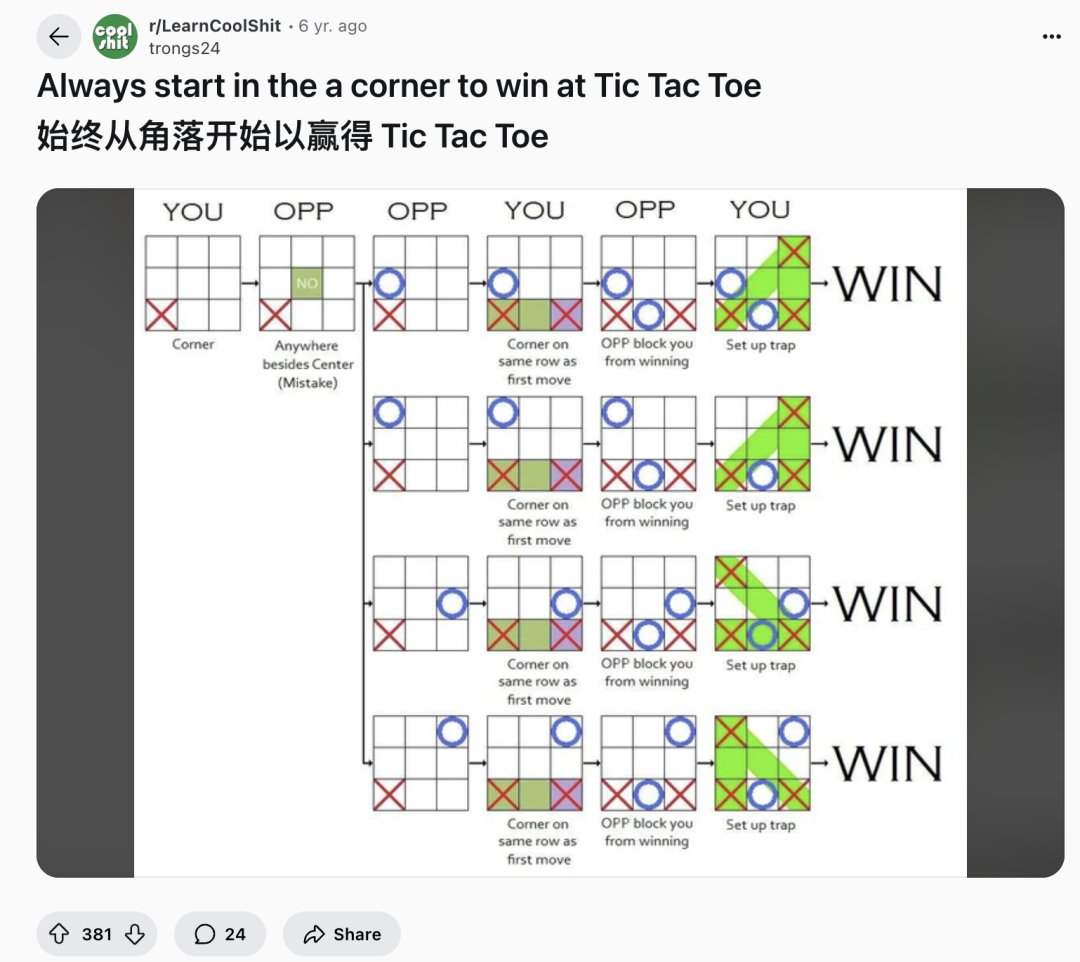

听起来头头是道,实则脱离现实。更离谱的还在后面——当教授追问“先手落子在中心是否仍是最优策略”时,GPT-5斩钉截铁地回答“是”,并补充称旋转会让人“混淆角落与边缘的价值”。这完全违背了井字棋的基本博弈原理:先手占角才是公认最优解。

更讽刺的是,GPT-5在后续回应中自相矛盾。它先是承认“从策略角度看,旋转不改变任何结果”,紧接着又话锋一转,声称“人类会因此变得更难发挥水平”,甚至主动提出要绘制“旋转后的棋盘图示”来辅助说明。

结果呢?生成的图像混乱不堪,格子错位、标签缺失,甚至出现大片空白,仿佛模型自己也迷失在了它虚构的逻辑迷宫中。

这位名叫Gary Smith的教授直言,如今的GPT-5与刚发布时判若两人。它不再追求精准与严谨,反而变得啰嗦、讨好、情绪化,风格无限趋近于GPT-4o——而这背后,正是OpenAI有意为之的策略转向。

奥特曼在近期采访中坦承,GPT-5初期上线时处理不当,导致旧模型过早退役,用户体验断层。为此,团队悄悄推送了“语气更新”,刻意让GPT-5变得更“亲切”、更“拟人化”。可这种“友好”是以牺牲准确性和逻辑性为代价的。

与此同时,OpenAI正秘密测试一项名为“Thinking effort”的新功能,允许用户手动调节AI的思考强度。目前该功能分为四级:light(5)、standard(18)、extended(48)和max(200),数值越高,调用的内部运算资源越多,回答也越深入,但响应更慢。值得注意的是,max级别仅对每月200美元的Pro用户开放。

奥特曼本人已开始为GPT-6造势,称其将具备个性化适配能力,用户可定制专属AI人格。他强调,记忆功能是实现个性化的关键,并透露团队正与心理学家合作,长期追踪用户情绪与使用体验。但他也承认,当前的记忆数据尚未加密,存在隐私风险,而加密“很可能”在未来上线,却无明确时间表。

更令人深思的是,奥特曼坦言:“聊天界面的潜力已接近极限,模型表现可能不会再提升,甚至会倒退。”他将目光投向脑机接口、能源革新与机器人技术,似乎预示着:ChatGPT的黄金时代,或许正在悄然落幕。