在人工智能推理技术迎来关键突破的当下,Meta AI携手加州大学圣地亚哥分校(UCSD)发布了一项名为Deep Think with Confidence(简称DeepConf)的创新方法,旨在破解大语言模型(LLM)在复杂任务中算力消耗巨大与准确率难以兼顾的难题。该技术为LLM推理效率的优化提供了全新的解决路径,尤其适用于企业级高负载应用场景。

目前,主流的提升LLM推理精度方式多依赖“多次采样+多数表决”机制,即通过生成大量推理路径后进行投票决策。然而,这种策略往往导致计算资源呈指数级增长,且大量低质量或错误的推理链反而可能误导最终判断。DeepConf的核心突破在于引入了动态置信度评估机制,不再对所有推理路径平等对待,而是依据模型内部生成过程中的“信心水平”进行智能筛选与加权,从而在源头上过滤掉不可靠的思考路径。

为了实现精准评估,DeepConf设计了一套多维度的置信度指标体系:

-

组置信度(Group Confidence):衡量推理过程中特定token序列的平均可信程度;

-

尾部置信度(Tail Confidence):重点关注推理结论阶段的稳定性,避免“虎头蛇尾”式错误;

-

最低组置信度(Lowest Group Confidence):识别整条推理链中最薄弱的环节,作为整体可信度的“短板”依据;

-

底部百分位置信度(Bottom-10% Confidence):聚焦最不确定的10%内容,强化对模糊推理的识别能力。

基于上述机制,DeepConf支持两种灵活的运行模式:

-

离线模式(Offline Thinking):先批量生成多条完整推理路径,再依据置信度评分进行筛选或加权表决,提升最终输出的可靠性;

-

在线模式(Online Thinking):在推理生成过程中实时监控置信度,一旦发现当前路径“信心”不足,立即中止该分支,避免资源浪费。

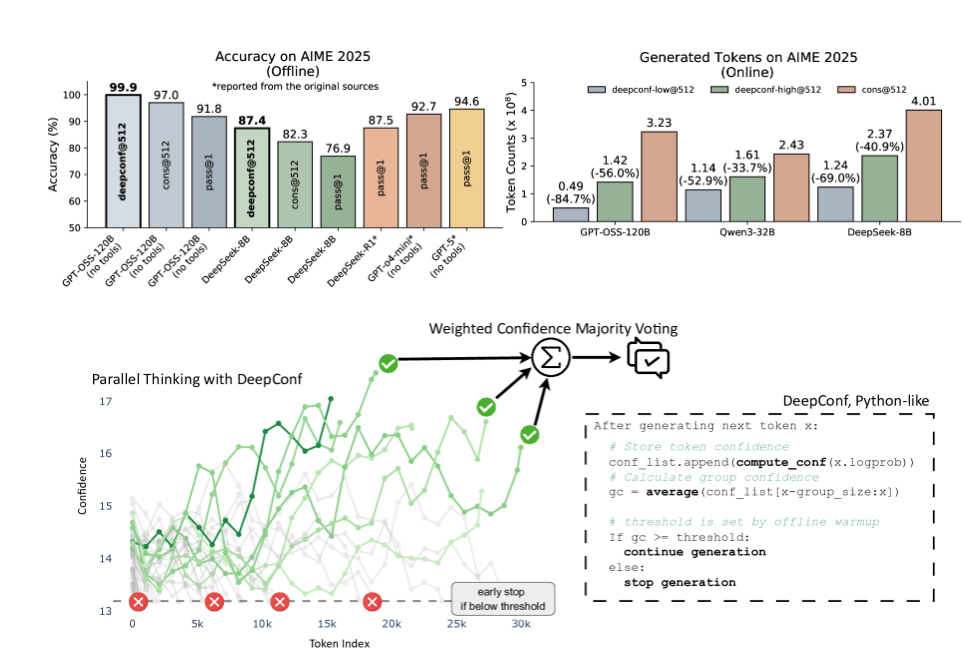

在多个权威测试集(如AIME、HMMT、GPQA-Diamond等)和主流模型(包括DeepSeek-8B、Qwen3-32B、GPT-OSS-120B)上的实验表明,DeepConf性能卓越:

-

在AIME2025任务中,GPT-OSS-120B采用离线模式实现了99.9%的惊人准确率,同时token生成量比传统方法减少了84.7%;

-

在AIME24任务中,在线模式下的DeepSeek-8B不仅准确率提升了5.8个百分点,token消耗更降低了77.9%。

为满足不同行业需求,DeepConf提供可配置的策略模式:

-

DeepConf-high(保守模式):侧重稳定性,可节省约50%的计算成本,适用于金融风控、法律文书等高敏感领域;

-

DeepConf-low(激进模式):追求极致效率,最高可减少70%–85%的token使用,适合知识检索、草稿生成等对容错率要求较低的场景。

尤为关键的是,DeepConf无需对原有模型进行重新训练,仅需在推理阶段加入轻量级逻辑判断,即可实现高效集成。其兼容性极强,已支持vLLM、SGLang、TensorRT-LLM等主流推理框架。研究团队强调,这一技术如同为LLM推理系统安装了一个“智能节流阀”,实现了性能与成本的最优平衡。随着企业AI部署日益深入,DeepConf有望成为大模型落地应用的标配工具之一。

论文:https://arxiv.org/abs/2508.15260

划重点:

-

🧠 置信度导向选择:DeepConf 基于局部置信度(组、尾部、最低点等)筛选或权重排序推理路径,而非一刀切多数投票。

-

⏱ 显著提升效率:达到最高99.9% 的推理准确率,同时减少生成 token 多达84.7%。

-

️🎛 可调节策略模式:企业可按风险偏好选择「高安全性」或「高效率」模式,用最少资源获取最优结果。