在影视科技与人工智能交汇的前沿,一项名为 ViPE(视频姿势引擎)的创新技术正悄然掀起波澜。这项由英伟达携手多伦多大学、向量研究所及德克萨斯大学奥斯汀分校共同研发的成果,旨在攻克长期困扰3D视觉领域的核心难题——如何从纷繁复杂的自然视频流中,高效提取精准的三维空间信息。

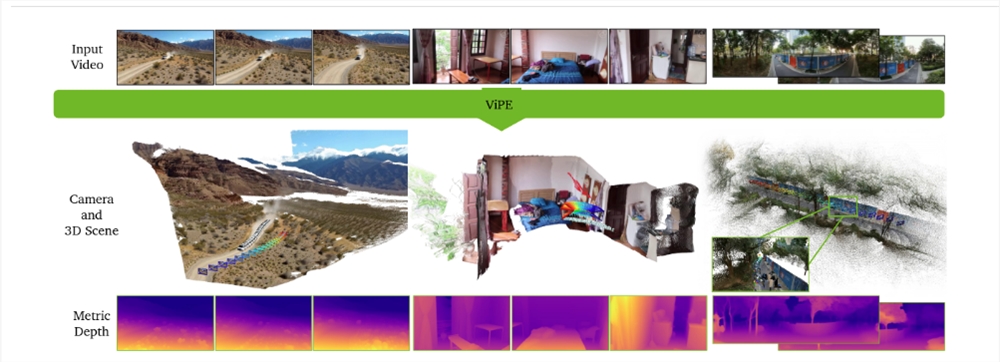

对于影视制作、虚拟现实(VR)、增强现实(AR)乃至自动驾驶等依赖空间感知的领域而言,3D几何理解能力如同“视觉大脑”。ViPE 的出现,正是为这类系统提供了更为坚实的数据基石。它能够从未经处理的原始视频中,迅速解析出摄像机的内部参数、运动轨迹以及高精度的深度图,实现对场景的立体还原。

尤为引人注目的是,ViPE 展现出极强的普适性。无论是手持拍摄的动态自拍、电影级别的运镜片段,还是行车记录仪捕捉的街景,它都能从容应对。不仅如此,该技术兼容多种摄像设备模型,包括针孔相机、广角镜头乃至360°全景摄像系统,展现出广泛的应用潜力。

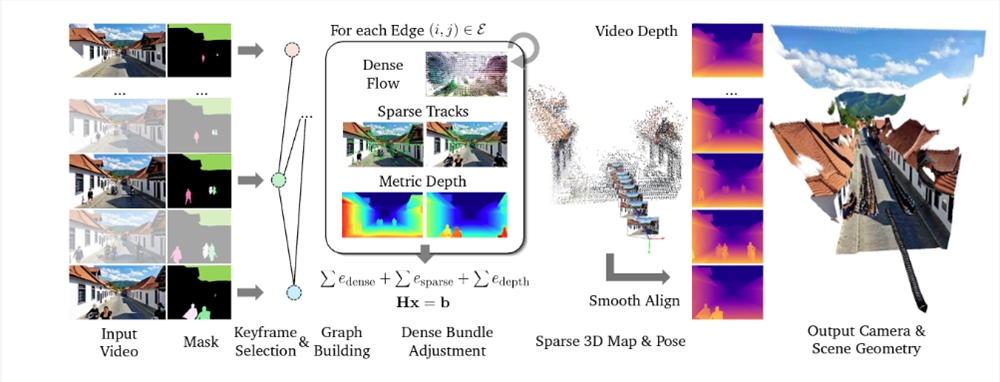

其卓越性能的背后,是一套精密设计的混合约束机制。研究团队并未依赖单一算法路径,而是融合多重技术手段以确保输出质量。首先,通过在关键帧上执行密集的束调整(Bundle Adjustment),精确估算相机姿态与深度结构;其次,引入 DROID-SLAM 网络提供的密集光流约束,辅以 cuvslam 库的稀疏特征点匹配,从而在动态变化中保持亚像素级的稳定性;最后,借助单目度量深度网络进行深度正则化,有效解决了传统方法中常见的尺度模糊问题,输出时间连续且分辨率更高的深度序列。

实测数据印证了 ViPE 的领先地位。在多个公开基准测试中,其表现全面超越了诸如 MegaSAM、VGGT 和 MASt3R-SLAM 等现有方案,无论是在相机姿态估计精度还是内参还原能力上均遥遥领先。更令人振奋的是,整个系统可在单块GPU上以每秒3至5帧的速度稳定运行,并成功重建出尺度一致的运动轨迹,具备实际部署的可行性。

为推动整个空间AI生态的发展,研究团队同步开源了一个规模惊人的数据集,涵盖约9600万帧带有精确标注的视频数据。这一举措无疑将加速后续研究的迭代进程。ViPE 不仅是技术层面的一次跃迁,更是向构建真正“理解三维世界”的智能系统迈出的关键一步,未来在影视预可视化、虚拟制片及元宇宙内容生成等领域,或将释放巨大潜能。

地址:https://research.nvidia.com/labs/toronto-ai/vipe/