影视科技领域再起波澜,谷歌旗下DeepMind实验室的最新研究成果,正悄然为视频生成技术描绘出一幅颠覆性的未来图景。在一篇引发广泛讨论的论文中,研究团队提出了名为“帧链”(Chain-of-Frames, CoF)的全新概念,这一理念被视为视频生成模型迈向“视觉思维”阶段的关键一步。如同大语言模型通过“思维链”实现逻辑推演,CoF则试图赋予AI在时间与空间维度上进行连贯视觉推理的能力,让机器不再只是拼接画面,而是真正“理解”动态影像的生成逻辑。

这项研究的核心挑战直指当前计算机视觉的瓶颈:任务割裂。目前,无论是目标检测、图像分割还是动作识别,每项任务都依赖于独立训练的专用模型,系统缺乏统一的视觉认知框架。DeepMind团队大胆设想:能否让一个视频模型像通用大模型处理语言一样,仅凭一条指令和一张初始图像,就自主完成多种复杂视觉任务?这种“零样本”推理能力,正是他们试图在视频生成领域实现的突破。

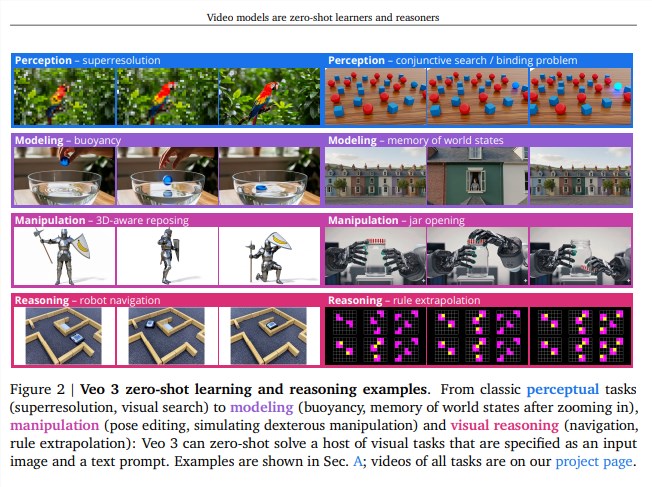

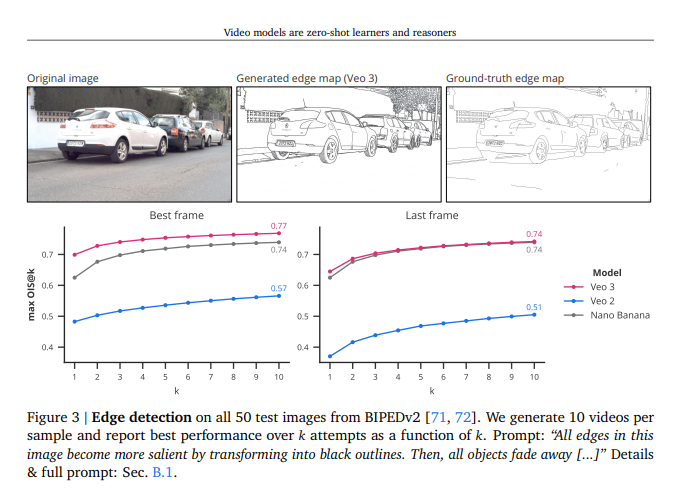

为验证这一设想,研究者采用了极简的测试方式——输入一张静态图片和一段文字描述,要求模型直接生成一段720p、8秒时长的高清视频,过程中不提供任何额外训练或微调。这种方法模仿了大语言模型的提示工程(prompt engineering)逻辑,旨在挖掘模型内在的通用视觉潜能。令人震惊的是,Veo3模型在多项传统视觉任务中展现出远超预期的表现,不仅能够精准操控物体运动轨迹,还能在复杂场景中进行跨帧推理,完成诸如路径规划、动态避障等高阶操作。

经过深入分析,研究团队提炼出三大关键发现。其一,Veo3展现出惊人的任务泛化能力,能够应对大量未经专门训练的视觉挑战,证明其具备初步的通用视觉理解力。其二,生成视频中呈现出清晰的“帧链”结构,每一帧的演变都建立在前序帧的理解之上,仿佛模型在“思考”如何推进情节,视觉推理的雏形已然显现。其三,尽管在特定任务上仍不及专用模型,但Veo3的进步速度极为迅猛,预示着通用视频模型的崛起已不可阻挡。

展望未来,DeepMind认为,这种具备原生推理能力的通用视频模型,有望逐步取代当前碎片化的专用系统,正如GPT系列模型重塑了自然语言处理格局。随着算力成本的下降与算法的持续优化,这类模型或将广泛应用于影视制作、虚拟现实、自动驾驶等领域,彻底改变我们创造和交互视觉内容的方式。一个由AI驱动的“视觉通用智能”时代,正加速向我们奔来。

论文地址:https://papers-pdfs.assets.alphaxiv.org/2509.20328v1.pdf