在人工智能领域,模型的“瘦身”革命正以前所未有的速度推进。近日,华为苏黎世计算系统实验室悄然发布了一项名为SINQ(Sinkhorn归一化量化)的开源技术,为大语言模型(LLM)的轻量化部署带来了突破性进展。该技术于9月26日正式上线,旨在显著降低模型对显存的依赖与运行开销,让高性能AI推理变得更加普惠。

SINQ最引人注目的特点在于其“即插即用”的便捷性。它无需依赖复杂的校准数据集或繁琐的调参流程,开发者可直接将其嵌入现有模型工作流中。更关键的是,其完整代码已在GitHub与Hugging Face平台开源,采用宽松的Apache 2.0许可证,允许个人与企业自由使用、修改乃至商业化部署,极大降低了技术门槛。

从实际效果来看,SINQ展现出惊人的压缩能力。实验数据显示,该技术可将各类主流大模型的显存占用普遍压缩60%至70%。这意味着,原本需要顶级专业显卡(如NVIDIA A100或H100)才能运行的百亿级参数模型,如今仅需一张约1600美元的消费级RTX 4090显卡即可流畅执行。对于依赖云服务的企业用户而言,这意味着每小时算力成本的大幅削减,AI应用的边际成本被进一步压缩。

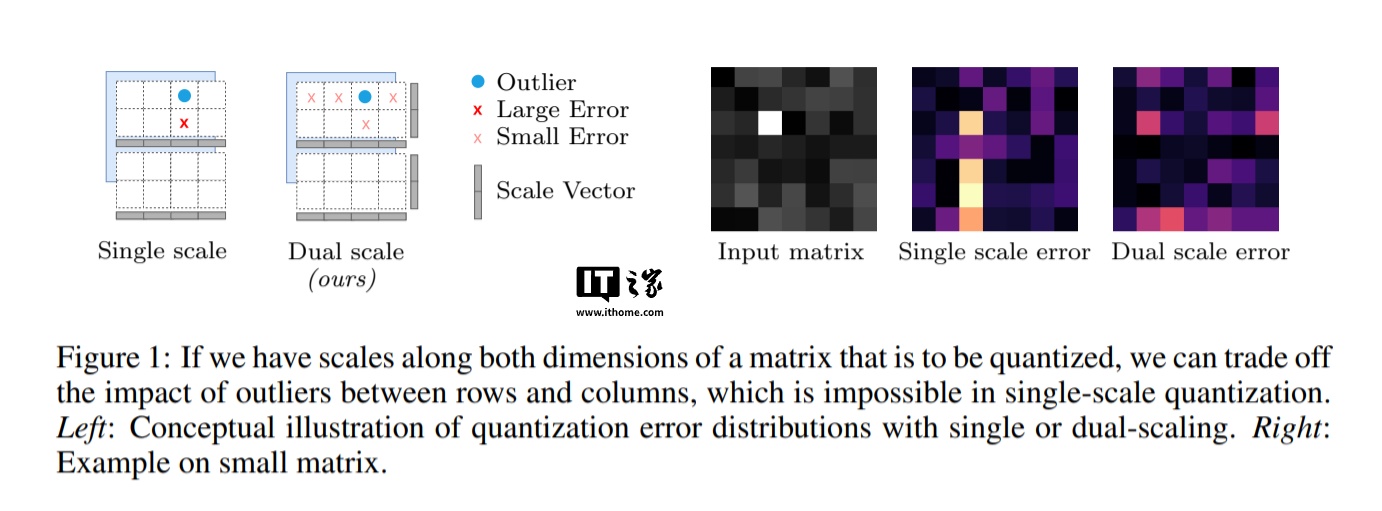

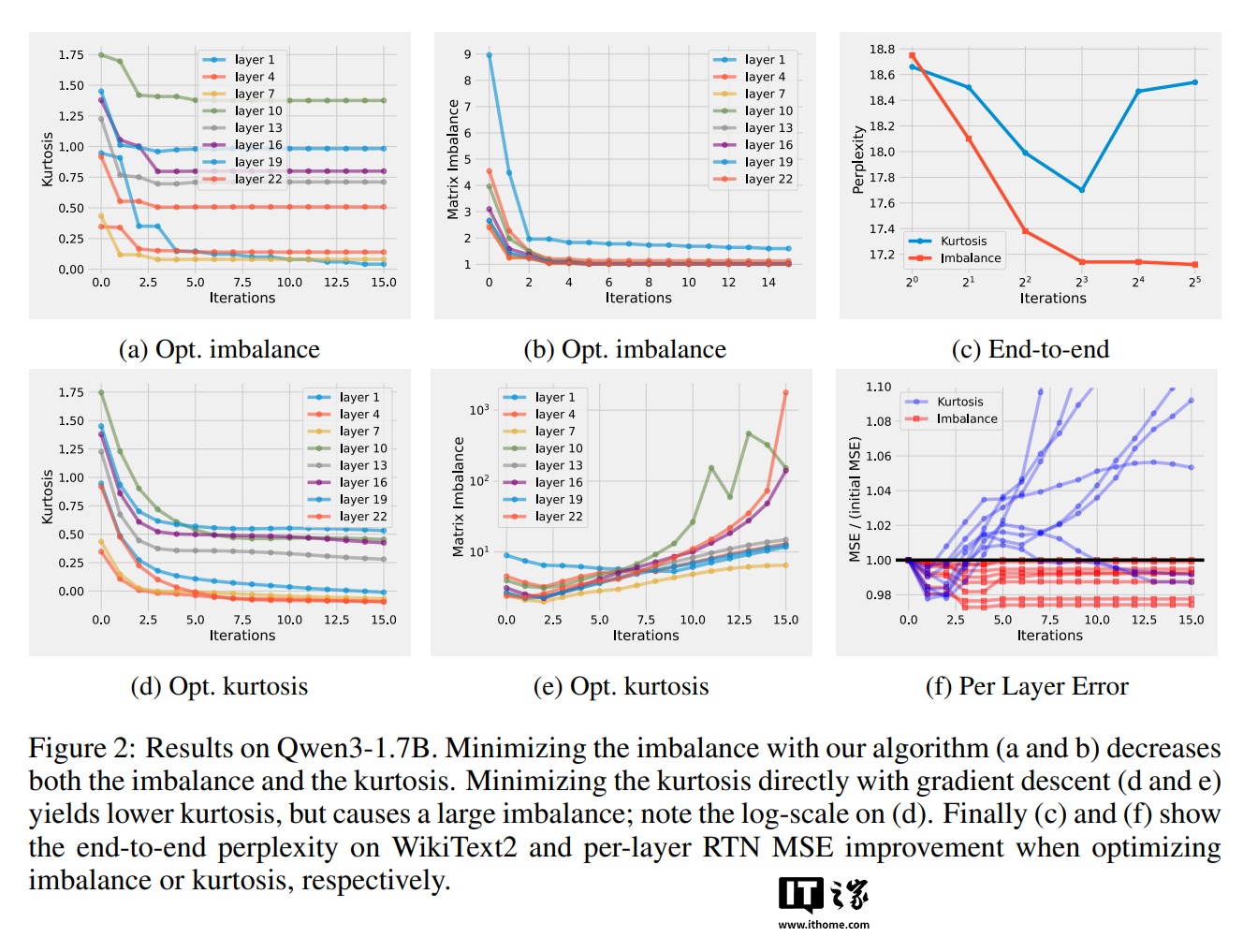

这一性能飞跃的背后,是SINQ在算法层面的双重创新。其一,摒弃传统单一缩放因子的做法,SINQ引入“双轴采样”机制,分别为权重矩阵的行与列配置独立的缩放向量,从而更精细地控制量化误差的分布,有效缓解了数值异常值带来的精度损失。其二,技术团队受Sinkhorn迭代算法启发,设计出一种高效的归一化策略,通过动态平衡矩阵行列的标准差,显著改善了量化后的“矩阵失衡”问题,使模型在低精度下仍能保持优异的语言理解能力。

在多项基准测试中,SINQ的表现令人瞩目。面对Qwen3、LLaMA等主流架构,其在WikiText2等权威语料库上的困惑度指标远优于RTN、HQQ等无需校准的同类方案,精度甚至逼近部分依赖数据校准的复杂方法。这表明SINQ不仅压缩效率高,且在语义保真度上同样出色。

速度同样是SINQ的一大优势。其量化过程比HQQ快两倍,相较AWQ更是提升了30倍以上,堪称效率与精度的完美结合。这一特性使其不仅适用于学术研究,更能无缝融入高频率、低延迟的工业级AI服务场景。

量化,简而言之,是通过降低模型内部数值精度来实现“瘦身”的技术,如同将高清图像压缩为体积更小的格式,既节省资源又不影响核心体验。而困惑度作为衡量语言模型智能水平的关键指标,数值越低,代表模型对语言的预测越精准、越自然。SINQ的出现,正让大模型从“奢侈品”逐步变为“日用品”,为AI技术的普及铺平了道路。