前特斯拉AI掌门人、OpenAI创始团队核心成员Andrej Karpathy近日在社交媒体上发表了一则引发广泛热议的观点,再度点燃了人工智能领域对模型输入方式未来形态的深层探讨。他在点评DeepSeek发布的OCR研究论文时提出:图像或许应成为大语言模型(LLM)的核心输入形式,而传统的文本token化处理方式,可能正站在被颠覆的边缘。

Karpathy的论点直指当前主流LLM架构的底层逻辑——我们将文字拆解为token,再送入模型处理。他认为,这一流程不仅冗余,甚至可以说是一种技术上的“浪费”。相较之下,直接将文本以图像形式输入,可能是更高效、更自然的技术路径。

其一,图像具备更高的信息密度。当文字被渲染成图像后,一个视觉patch可涵盖多个字符信息,而传统token机制则需为每个子词或字符单独编码。在处理超长上下文时,图像输入有望大幅压缩token数量,从而降低计算负担,提升推理效率。

其二,图像承载了丰富的视觉语义。加粗、斜体、颜色变化、排版布局等格式信息,在纯文本中往往需要额外标记语言(如HTML或Markdown)来表达,这不仅增加了token消耗,也破坏了输入的简洁性。而图像天然保留这些视觉特征,使模型能更精准地理解文档结构与语义重点。

其三,图像输入支持双向注意力机制,突破了传统自回归模型的单向限制。模型可以同时感知上下文全貌,而非逐字生成,从而提升理解深度与响应质量。

Karpathy尤其批判了tokenizer这一“历史包袱”。他指出,同一字符因Unicode来源不同,可能被映射为不同token,导致模型对视觉上完全相同的文本产生歧义。若能绕过tokenizer,直接以像素为单位输入,系统将更接近端到端的理想状态。

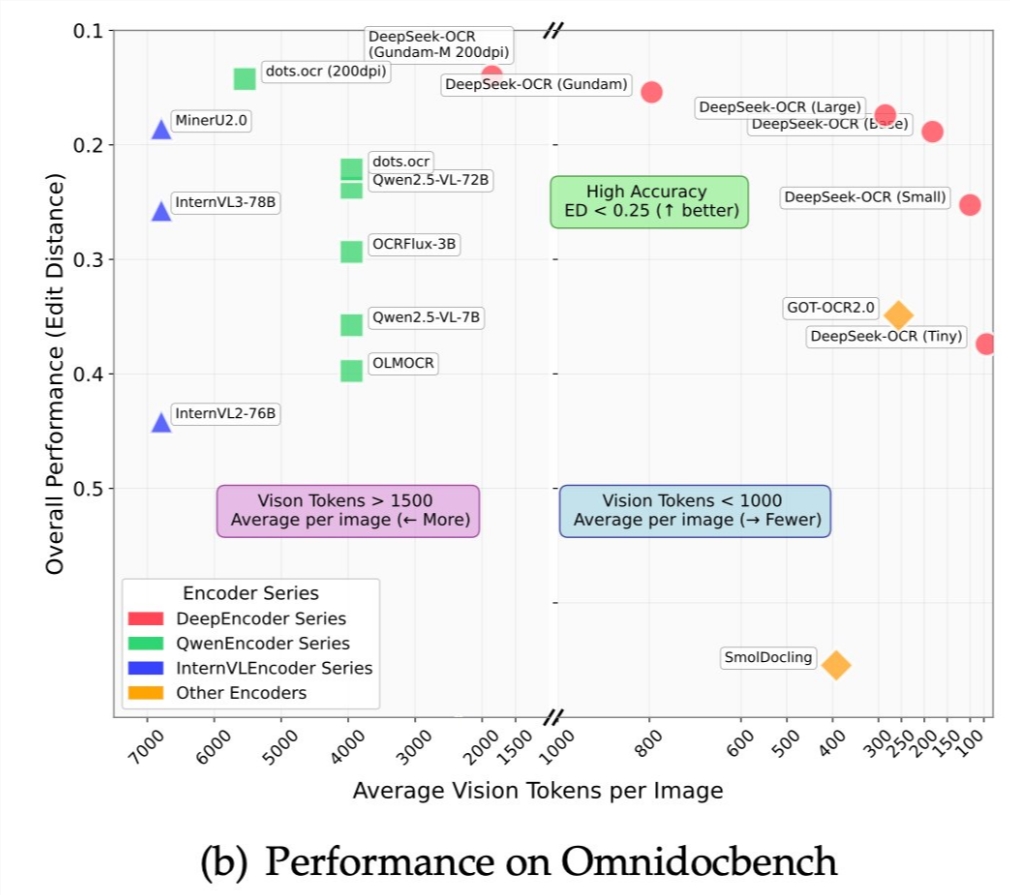

这一设想并非空中楼阁。Vision Transformer等视觉模型已证明图像处理的高效性,而DeepSeek-OCR等技术则展示了从图像精准还原语义的可行性。两者结合,为“图像即输入”的新范式提供了技术基础。

然而挑战同样显著。图像编码本身计算开销大,且生成端仍需输出可读文本,意味着系统无法完全脱离文本处理能力。此外,图像文本难以编辑,与现有文本生态难以兼容,全面转型尚需时日。

尽管如此,Karpathy的设想已为AI架构演化指明了一个激进而诱人的方向:语言模型或将进化为通用信息处理器,而图像输入,可能正是通往这一未来的钥匙。