解读:AI生成未来

Hunyuan-GameCraft-2 的推出,标志着生成式游戏世界模型从静态视频合成迈向了真正意义上的开放式、指令驱动的交互式模拟新阶段。这一突破不仅重塑了用户与虚拟环境之间的互动方式,也为未来沉浸式数字体验奠定了技术基石。

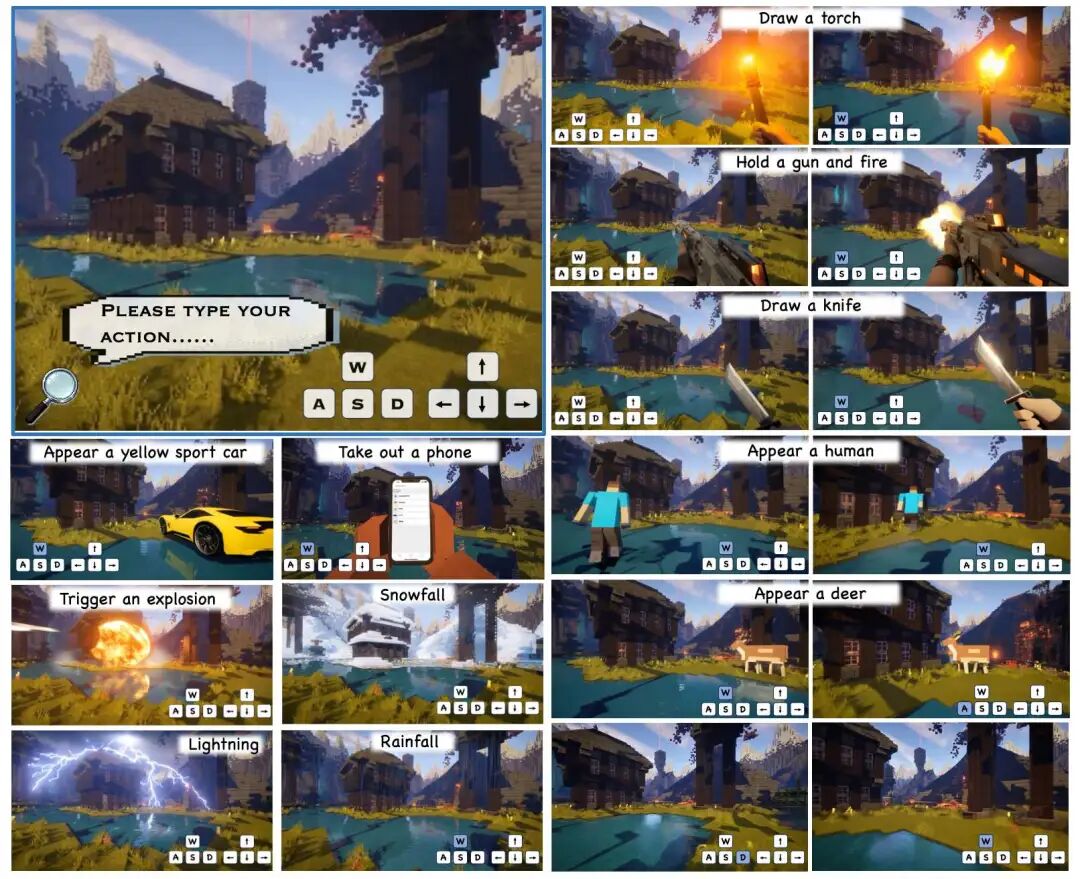

合成交互视频Pipeline展示

Pipeline of the Data Curation SystemPipeline of the Caption Generation System

亮点直击

该模型构建了一个统一的可控视频生成框架,巧妙融合文本提示、键盘输入与鼠标信号,实现语义层面的精细交互控制。通过自回归蒸馏策略与随机化长视频微调机制,系统在保障生成稳定性的同时,有效缓解了长时序推演中的误差累积问题。结合 KV 缓存重计算与多项工程优化手段,推理速度提升至 16 帧/秒,首次实现了高质量交互式视频的实时生成。

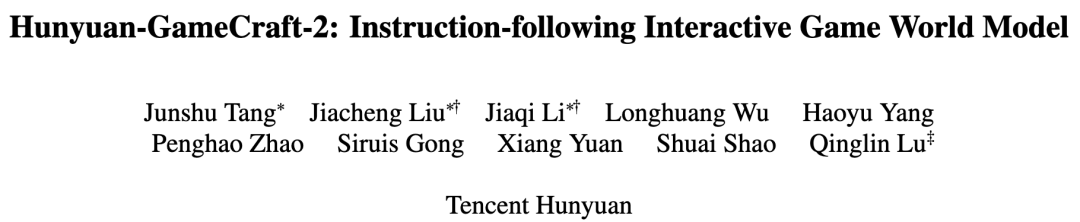

大量定量与定性实验验证了该框架的卓越性能:生成内容不仅在视觉保真度与时序连贯性上表现优异,更能精准响应如“打开门”、“画一个火把”等自由形式的用户指令,展现出高度的语义理解与执行能力。

总结速览

解决的问题

尽管当前生成式世界模型在构建虚拟环境方面取得一定进展,但其仍受限于僵化的动作图式、高昂的标注成本,以及缺乏对“交互”本身的明确定义。此外,现有方法难以将海量非结构化文本-视频数据高效转化为可用于训练的交互式数据集,且在多轮交互中常因误差积累而丧失长期一致性。

提出的方案

Hunyuan-GameCraft-2 提出了一种全新的指令驱动范式。它正式定义了“交互式视频数据”——即由代理执行、能引发环境中具有因果逻辑和物理合理性的状态转换的动作。基于此,团队开发了两套自动化数据构建管道,将原始视频素材转化为富含隐式因果标签的开放域交互数据集。同时,模型整合文本与硬件输入信号,形成统一控制接口,并配套推出 InterBench 评估基准,从交互完整性、动作有效性、因果连贯性等多个维度系统衡量模型表现。

应用的技术

该系统以 14B 参数的图像到视频 MoE(Mixture-of-Experts)模型为基底,引入文本驱动的交互注入机制,精准调控摄像机运动、角色行为及环境动态。通过自回归蒸馏,将双向扩散模型转化为因果生成器;借助随机化图像到长视频扩展微调,显著提升长序列稳定性。KV-Recache 机制则确保多轮交互中上下文的准确传递,而 FP8 量化、并行 VAE 解码、SageAttention 与序列并行等工程优化共同支撑起 16 FPS 的实时性能。

达到的效果

在 InterBench 及通用视频指标上的全面测试表明,Hunyuan-GameCraft-2 不仅在交互触发率(最高达 0.983)、物理合理性、终态一致性等关键维度大幅领先,还能在未见场景中泛化出符合物理规律的新交互(如“龙出现”)。可视化对比显示,其生成的“降雪”具备全局动态演变,“持枪射击”动作手物接触自然,新实体身份稳定、结构完整。

方法

整体架构围绕图生视频 MoE 模型展开,通过令牌相加方式注入键盘/鼠标信号,并利用多模态大语言模型增强交互文本的语义表达力。训练分四阶段推进:动作注入、指令导向 SFT、自回归蒸馏与随机化长视频微调。其中,Sink Token 与块稀疏注意力机制确保初始帧信息始终参与生成,避免坐标漂移;交错使用 Self-forcing 与 Teacher-forcing 则强化模型的状态恢复能力。

推理阶段采用滚动更新的 KV 缓存策略,配合 Recache 机制,在接收新指令时快速重算历史上下文,实现低延迟、高响应的交互体验。最终,Hunyuan-GameCraft-2 不仅突破了生成式AI在交互性、一致性与实时性上的多重瓶颈,更推动虚拟世界从“可看”走向“可玩”,为下一代 AI 驱动的沉浸式娱乐与模拟平台开辟了全新路径。