在最近一场备受瞩目的技术发布会上,vLLM 团队揭晓了其最新力作——vLLM-Omni,一个专为全模态模型打造的高性能推理框架。这一突破性工具的发布,标志着多模态AI系统在实际应用层面迈出了关键一步。与传统仅限于文本处理的模型不同,vLLM-Omni 能够无缝处理包括文字、图像、声音乃至视频在内的多种数据类型,真正实现了跨模态的内容理解与生成能力。

自面世以来,vLLM 项目便以卓越的推理效率和显存优化能力在大模型社区中建立了良好声誉。然而,随着人工智能应用场景日益复杂,单一文本交互已难以满足现实需求,行业对具备综合感知与表达能力的智能体提出了更高要求。正是在这样的技术演进背景下,vLLM-Omni 应运而生,成为目前为数不多支持全模态推理的开源解决方案之一,填补了现有框架在多模态协同处理方面的空白。

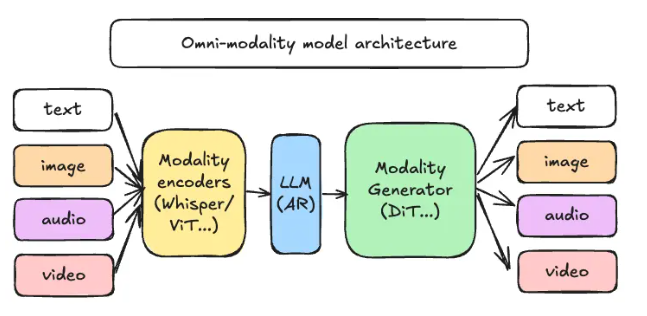

该框架最引人注目的创新在于其采用的解耦式流水线架构。通过将整个推理流程模块化,vLLM-Omni 实现了输入解析、核心计算与输出生成的高效协同。具体而言,系统将请求依次交由三类核心组件处理:首先是模态编码器,负责将各类原始输入(如图片或语音)转化为统一的向量表示;随后交由 LLM 核心进行语义理解与逻辑推理;最终由模态生成器还原并输出对应形式的结果内容,无论是文字回复、图像绘制还是音频合成,均可精准完成。

这种架构设计不仅提升了整体吞吐性能,更赋予了开发者前所未有的灵活性。各模块可独立部署于不同计算资源上,支持按需扩展特定环节的算力配置,极大增强了系统的可伸缩性与部署适应性。对于企业级应用而言,这意味着能够根据业务场景动态调配资源,在成本与性能之间实现最优平衡。

GitHub :https://github.com/vllm-project/vllm-omni

划重点:

🌟 vLLM-Omni 支持文本、图像、音频、视频等多模态内容的统一推理,推动AI向更自然的人机交互迈进。

⚙️ 解耦架构设计提升系统效率,支持模块化部署与资源精细化管理。

📚 全面开源,提供完整文档与示例代码,鼓励开发者共建多模态AI生态。