商汤科技携手新加坡南洋理工大学S-Lab,正式推出并开源其全新多模态大模型架构NEO。该架构通过底层机制的深度重构,实现了视觉与语言信号在原生层面的高度融合,在模型性能、训练效率及通用能力方面均实现显著跃升。

极致数据效率:十分之一数据量媲美顶尖模型

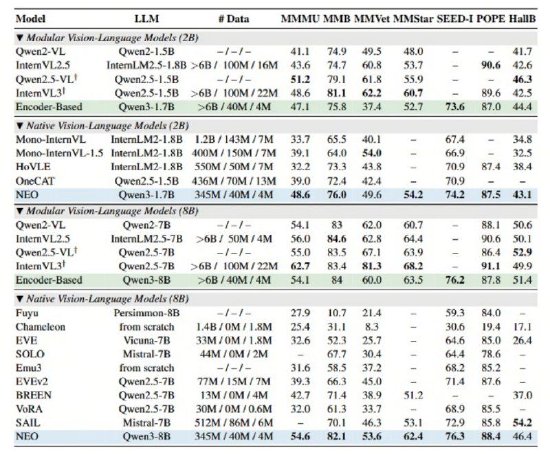

NEO最引人注目的突破在于其卓越的数据利用效率——仅使用3.9亿对图像-文本样本,约为当前主流高性能模型所需数据量的十分之一,便成功构建出具备顶级视觉理解能力的系统。更值得注意的是,NEO无需引入额外的专用视觉编码器,仅凭其精简而高效的统一架构,就在多个权威视觉理解基准上达到甚至超越Qwen2-VL、InternVL3等模块化旗舰模型的表现。

在包括MMMU、MMB、MMStar、SEED-I和POPE在内的多项国际公开评测中,NEO均取得领先成绩,综合指标优于现有原生视觉语言模型(VLM),真正验证了“小数据、高精度”的可行性,为资源受限场景下的多模态模型部署开辟了新路径。

打破传统“拼接式”架构桎梏

目前行业主流的多模态模型普遍采用“视觉编码器 + 投影层 + 大语言模型”的三段式结构。这种设计虽能将图像信息注入语言模型,但本质上仍以文本为中心,图像与语言的交互仅限于表层对齐,缺乏深层次语义协同。这种“拼凑式”方法不仅导致训练过程冗余低效,更在处理需要精细空间推理或复杂图文关联的任务时显现出明显局限。

NEO则从根源上重构了多模态建模范式,通过在注意力机制、位置编码策略以及跨模态语义映射等核心环节进行系统性创新,使模型自诞生之初就具备原生融合视觉与语言的能力,而非事后“嫁接”。

两大底层技术创新驱动原生融合

原生图块嵌入(Native Patch Embedding):NEO彻底摒弃了传统依赖离散图像分词器(tokenizer)的做法,转而采用自主研发的Patch Embedding Layer(PEL),直接从像素级输入连续生成语义丰富的视觉token。这一机制有效保留了图像中的高频细节与局部结构信息,显著提升了对复杂视觉内容的建模精度,突破了现有架构在图像表征上的瓶颈。

原生多头注意力(Native Multi-Head Attention):为适配不同模态的内在特性,NEO在同一注意力框架内同时支持文本token的因果自回归注意力与视觉token的双向全连接注意力。这种差异化但统一的注意力机制,使模型能更高效地捕捉图文之间的深层关联,尤其在涉及空间布局理解、对象关系推理等复杂任务中展现出强大优势,真正实现图文混合内容的端到端联合推理。