当大模型的热潮席卷而来,许多人都在谈论技术突破与未来愿景,却很少有人直面一个残酷现实:真正决定AI项目生死的,往往不是算法多先进,而是你能否以可持续的成本、稳定可靠的服务,把模型能力无缝嵌入产品之中。

这不仅关乎代码实现,更是一场关于生存效率的竞争。一个API接口的选择,可能让你的产品流畅运行、快速迭代,也可能让团队深陷高昂账单与频繁故障的泥潭,最终错失市场窗口期。

你在为低效的API付出隐性代价

每一位亲手集成过大模型API的工程师,心里都有一本血泪账。调用一次高端闭源模型,费用高得让人犹豫是否要上线新功能;某些平台看似价格透明,实则限流严格,流量稍有波动就触发熔断机制;还有些服务商文档残缺、响应迟缓,遇到问题只能靠社区猜测和试错;而所谓“低价”方案,常常伴随着超时、丢包、返回异常,用户体验直接打折。

这种困局正在被重新定义。

一个悄然崛起的技术平台正引起开发者圈层的关注——n1n.ai。它并非追逐热点的新玩家,而是针对当前API生态痛点所打造的一站式解决方案。如果你正因成本失控、服务不稳定或接入复杂而停滞不前,那么这个平台或许正是你需要的转折点。

n1n.ai:如何重构开发者体验

它的核心理念很清晰:让大模型能力像水电一样即开即用,便宜、稳定、易上手。

首先是成本控制。n1n.ai的定价策略打破了行业惯例,部分模型调用价格仅为官方渠道的十分之一,且支持用户亲自测试验证效果。更重要的是,平台深度整合了Llama、Mistral等主流开源大模型,这些模型的调用成本极低,非常适合初创团队进行高频次实验与规模化部署,大幅降低试错门槛。

其次是稳定性保障。平台采用分布式多节点架构,智能调度请求路径,确保高并发下的持续可用性。根据现有用户反馈,平均响应时间稳定在500毫秒以内,SLA承诺高达99.9%,这意味着你的应用不再因为后端抖动而影响前端表现。

再者是开发体验。访问其官方文档(https://docs.n1n.ai),你会发现从入门指引到SDK示例一应俱全,覆盖Python、JavaScript等多种语言,连错误码说明都细致入微。这不是堆砌出来的文档库,而是真正站在开发者角度设计的操作手册。技术支持响应迅速,多数问题可在24小时内得到专业解答。

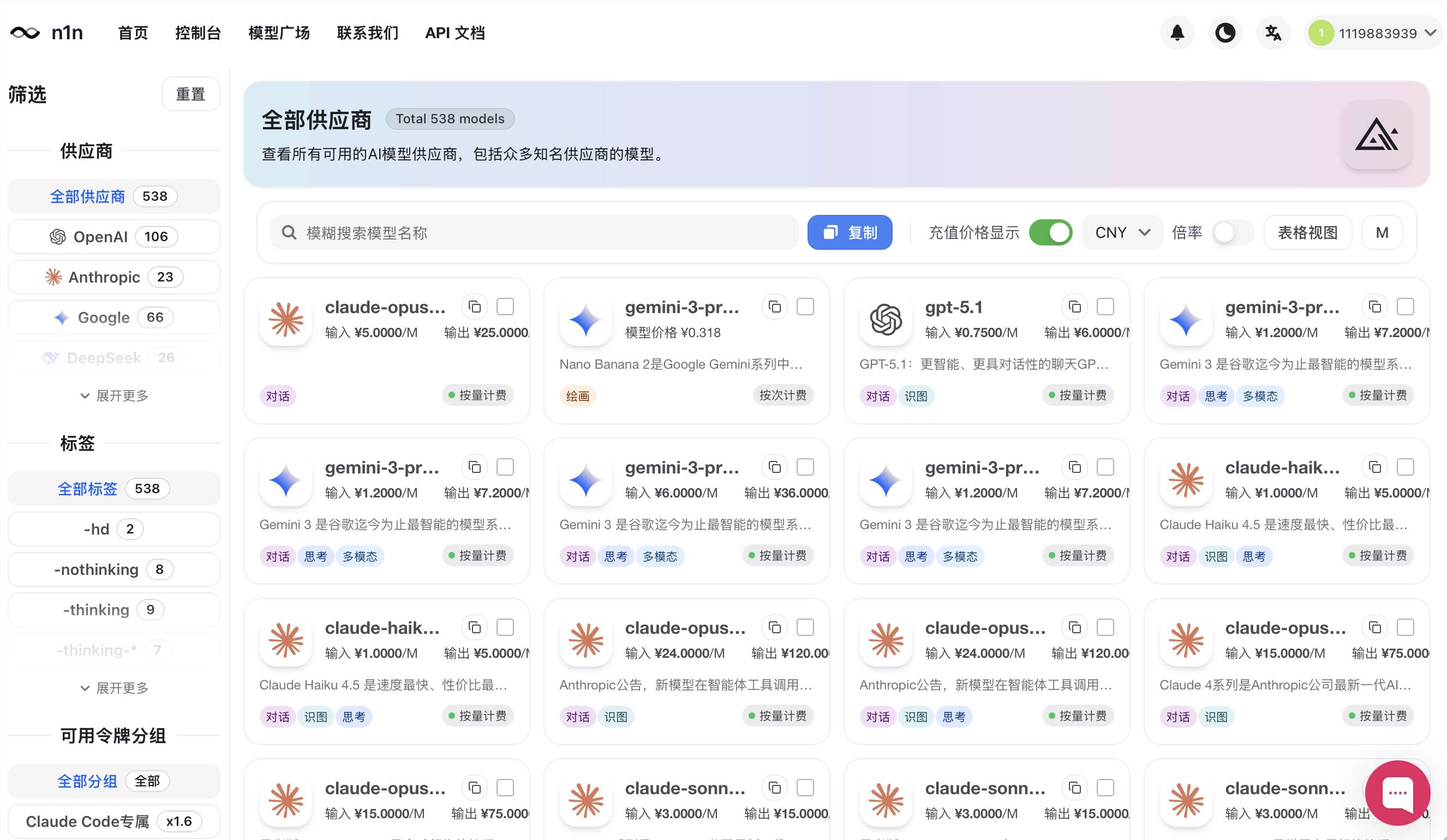

最后是灵活性。n1n.ai目前已聚合近500种大模型,涵盖OpenAI、Claude等闭源强模型,也包含各类高性能开源选项。你可以根据场景自由切换——追求极致推理选高端模型,控制预算则用轻量级方案,统一接口,灵活调配。

真实世界的效率跃迁

已有团队通过n1n.ai实现了关键突破。一家内容创业公司原本每月需为GPT-4支付数万元API费用,迁移至该平台后,支出减少76%以上,节省的资金用于拓展用户增长团队。另一家传统零售企业希望升级客服系统,在不增加IT预算的前提下,借助n1n.ai快速完成AI集成,客户满意度提升超过38%。

这些案例背后,是一个简单逻辑:选对工具,才能把资源集中在创造价值的地方。

如何快速上手?

第一步:注册n1n.ai账号,全程不到两分钟,注册即送免费额度,可用于多种模型测试。

第二步:登录控制台获取专属Token(格式:sk-XXX),将其置于请求头Authorization字段中即可认证身份。

第三步:设置BaseURL,按照标准OpenAI API格式发起调用。兼容性强,无需重写原有逻辑,现有项目可平滑迁移。

无论是构建智能助手、自动化内容引擎,还是增强数据分析能力,n1n.ai都在试图成为那个看不见但不可或缺的基石。在这里,大模型不再是烧钱的负担,而是推动创新的加速器。未来的竞争,属于那些能高效利用AI的人,而起点,也许就是一次正确的API选择。