近日,DeepSeek以一场极具冲击力的更新,再次搅动全球AI格局。这家素以代码生成与硬核推理能力闻名的技术先锋,一口气推出两款正式版模型——DeepSeek-V3.2 与 DeepSeek-V3.2-Speciale,不仅在性能上直指GPT-5、硬刚Gemini 3.0 Pro,更以彻底开源的姿态,一举击碎“开源模型永远落后闭源8个月”的行业定论。2026年被视为AI Agent元年,而这场技术风暴显然已提前引爆。

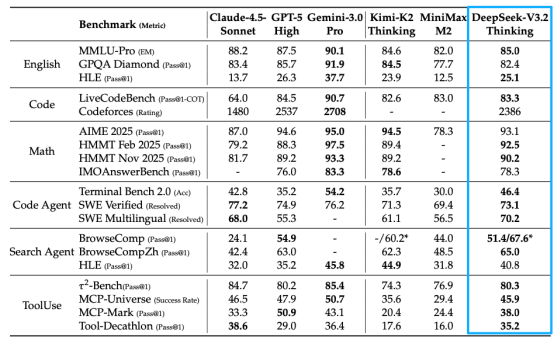

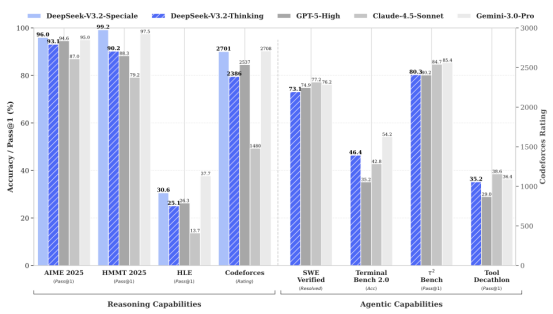

技术层面,DeepSeek此次的双模型策略如同精准部署的“双子星”:V3.2主打通用场景,兼顾日常问答、工具调用与Agent任务,推理能力稳居GPT-5水准;而Speciale版本则聚焦极致推理,深度融合DeepSeek-Math-V2的定理证明引擎,在主流数学与编程基准中表现甚至超越Gemini 3.0 Pro,堪称学术研究与竞赛场景的“金牌收割机”。

长期以来,大模型处理长上下文时受限于O(L²)复杂度的注意力机制,128K上下文一度是高成本的奢侈品。DeepSeek提出的DSA(DeepSeek Sparse Attention)稀疏注意力机制,通过“闪电索引器”与“细粒度token选择”两大创新,将计算复杂度压缩至O(L·k),大幅降低资源消耗。实测显示,在H800集群上,128K序列推理的预填充成本从每百万token 0.7美元降至0.2美元,解码阶段从2.4美元降至0.8美元,速度提升3.5倍,内存占用减少70%,且无明显性能损失。这意味着,整本书籍或完整项目代码的实时推理,正从理想走向现实。

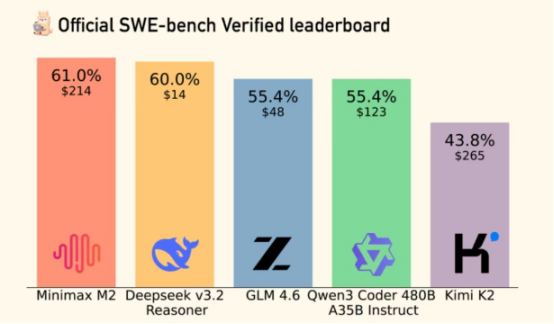

更关键的是,DeepSeek在后训练阶段投入了远超行业常规的资源——强化学习预算占到预训练成本的10%以上,并对GRPO算法进行三重优化,引入无偏KL估计、离线序列掩码与MoE专用的Keep Routing机制。同时,团队采用“专家蒸馏”策略,先为数学、编程等六大领域训练专用模型,再以其生成高质量数据微调主模型。这一系列操作让V3.2在SWE-Verified代码修复任务中达到73.1%解决率,逼近GPT-5 High的74.9%;在Terminal Bench 2.0中以46.4%准确率大幅领先GPT-5 High的35.2%;而Speciale更在AIME 2025数学竞赛中以96.0%通过率,反超GPT-5与Gemini 3.0 Pro。

针对AI Agent长期存在的“状态漂移”问题——即多轮工具调用中丢失原始目标,DeepSeek V3.2首创“思考保留”模式,成为首个支持在思考状态下调用工具的开源模型。其机制确保仅在接收新用户输入时清空历史推理,工具交互期间则持续保留上下文逻辑,如同为AI植入“海马体”,实现决策连贯性。为此,团队构建了包含1827个任务环境与85000条复杂指令的合成训练管线,夯实Agent实战能力。

这场更新不仅是技术突破,更是战略转向。当ChatBot模式因“能说不能做”遭遇商业瓶颈,DeepSeek明确将V3.2定位为“通用Agent任务平台”,标志着AI从对话助手向行动代理的跃迁。在全球科技博弈背景下,中国AI厂商正以“应用驱动底层创新”的路径突围:硬件受限?就靠算法优化;算力不足?就用MoE架构提效。DeepSeek的崛起,正是这一战略的缩影。

尤为颠覆的是,DeepSeek选择将模型权重、聊天模板与本地部署指南全量开源于Hugging Face,让顶级AI能力真正“免费顶配”。这不仅打破闭源垄断,更重塑全球AI权力结构。当推理成本趋近于零,当上下文容量覆盖整部著作,AI将不再是附加功能,而是操作系统级的基础设施——服务即软件(Service as a Software)的时代已然开启。

当中美科技巨头纷纷押注Agent,当开源模型跻身第一梯队,2026年的AI战场已不再只是参数竞赛,而是生态、效率与落地能力的全面对决。DeepSeek V3.2的发布,恰如一声号角,宣告着一个由开源驱动、Agent主导的新纪元,正在加速到来。