12月25日,清华大学TSAIL实验室携手生数科技正式发布开源视频生成加速框架TurboDiffusion,这一突破性成果在不牺牲生成质量的前提下,将端到端扩散模型的推理速度提升高达100至200倍,为高分辨率视频生成领域带来显著效率跃升。

从技术架构来看,TurboDiffusion的核心优势在于其对注意力机制的深度优化。研发团队引入了SageAttention与SLA(稀疏线性注意力机制)两项关键技术,有效缓解了传统扩散模型在处理480P乃至720P高清视频时面临的巨大计算负担。通过压缩冗余计算路径,这两项机制大幅降低了显存占用和浮点运算需求,从而为实时或近实时视频生成铺平道路。

此外,TurboDiffusion还融合了rCM(时间步蒸馏)技术,该方法通过对扩散过程中的关键时间步进行知识蒸馏,显著减少了采样所需的迭代次数。这种多维度的技术协同不仅保留了原始模型的生成一致性与细节表现力,更将整体延迟压缩至前所未有的水平,真正实现了“快而不糙”的工程目标。

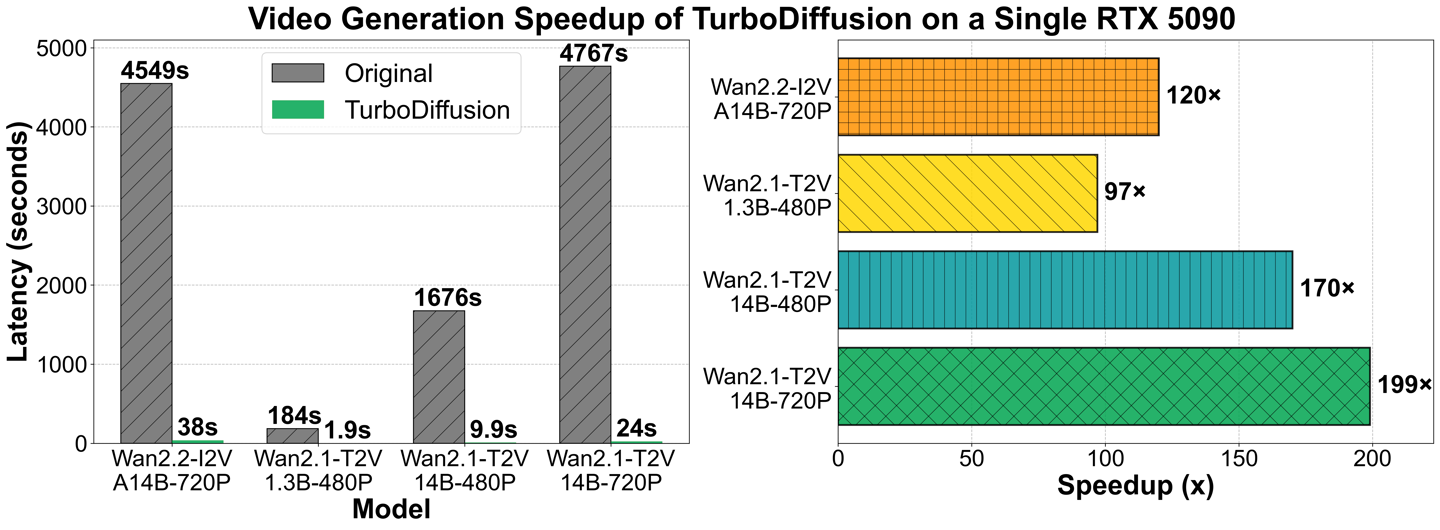

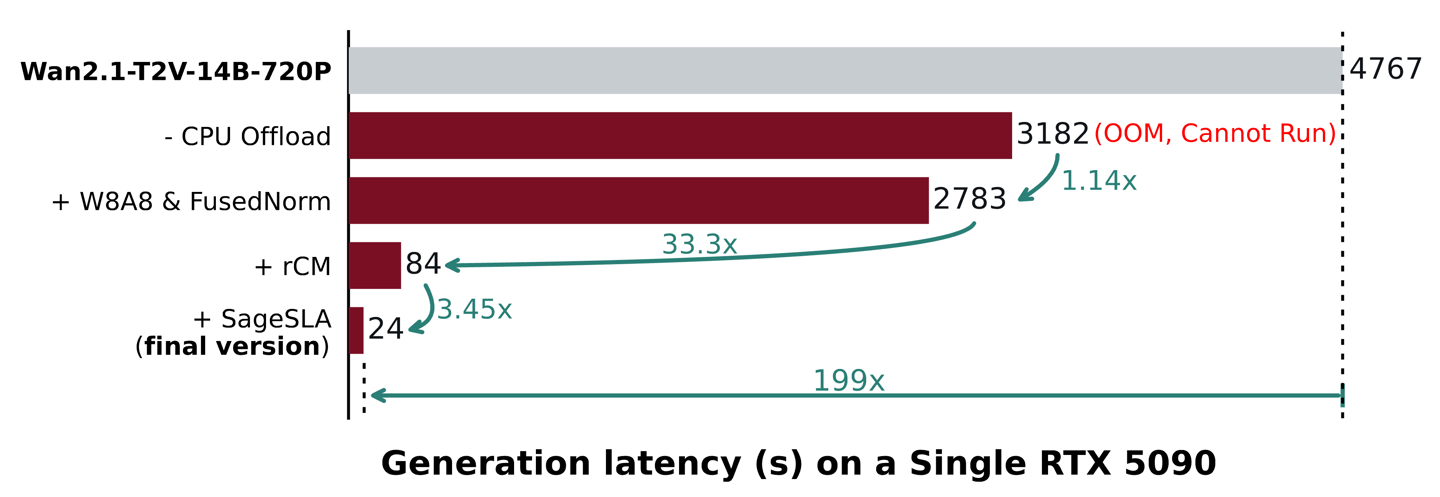

官方GitHub页面公布的基准测试数据令人瞩目。以Wan-2.1-T2V-1.3B-480P模型为例,在单张RTX 5090显卡上,原生扩散流程生成5秒视频需耗时184秒,而借助TurboDiffusion仅需1.9秒即可完成,提速近百倍。对于更高复杂度的Wan-2.2-I2V-A14B-720P模型,原始生成时间长达4549秒(约1.26小时),TurboDiffusion将其锐减至38秒,效率提升超过100倍。

即便是参数规模庞大的Wan-2.1-14B-480P模型,其生成时间也从1676秒骤降至9.9秒,性能远超当前主流的FastVideo等同类加速方案,展现出极强的工程实用价值。

目前,TurboDiffusion已在GitHub开放多种规格的模型权重,并针对不同硬件平台进行了精细化适配。面向RTX 5090、RTX 4090等消费级显卡用户,项目提供了量化版(Quantized)权重,并建议启用线性层量化以进一步降低显存压力;而对于配备80GB以上显存的H100等数据中心级GPU,则推荐使用非量化版本,以充分释放模型潜力,获得最优画质与速度平衡。