在人工智能与视觉技术深度融合的当下,一场由学术界与产业界共同推动的技术革新正在重塑图像处理领域。近日,中山大学联合鹏城实验室和美团,推出了一款名为X-SAM的多模态大模型,专注于图像分割技术,标志着该领域正式进入"按需分割"的新时代。

与传统技术相比,X-SAM最大的突破在于实现了从"万物可分"到"任意分割"的质变。值得一提的是,该模型采用高度灵活的交互架构,用户既可以通过自然语言描述进行文本查询,也能借助点选、涂鸦等视觉提示完成交互操作。

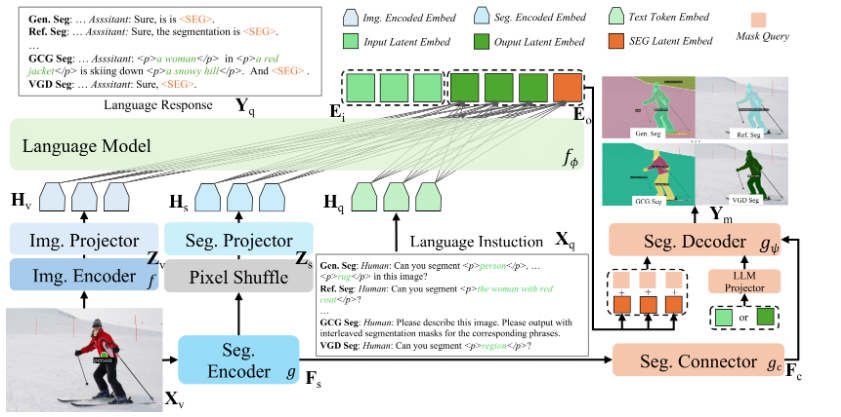

在技术实现上,X-SAM展现出三大创新亮点:

- 采用双编码器机制,分别处理全局语义和局部细节

- 创新性引入"分割连接器",整合多尺度特征

- 重构传统解码流程,使分割边界更精准

训练策略方面,研发团队采用了循序渐进的三阶段方案:

- 基础微调阶段:夯实分割能力基础

- 对齐预训练阶段:实现语言与视觉的深度耦合

- 混合微调阶段:在多个数据集上提升泛化能力

测试结果显示,X-SAM在20余项主流分割基准测试中均表现优异。研发团队表示,下一步将重点拓展视频理解领域,通过融合时序动态信息,进一步延伸技术应用边界。

-

代码地址:https://github.com/wanghao9610/X-SAM

-

Demo地址: https://47.115.200.157:7861

核心突破:

🌟 首创"任意分割"新范式,突破传统技术限制

💡 双模输入架构大幅提升交互效率

🚀 三阶段训练策略实现性能飞跃