苹果公司研究团队最新发现,一种名为“清单式强化学习框架”(RLCF)的创新方法,可大幅提升开源大语言模型(LLM)处理复杂任务的能力。该方法通过引入结构化自查机制,显著提高了模型在执行多步骤指令时的准确性与稳定性。

传统反馈机制的瓶颈与新路径

长期以来,“基于人类反馈的强化学习”(RLHF)被视作优化语言模型的主流方法。它依赖人工标注者对模型输出打分,以此作为奖励信号推动模型迭代。

但这种方式存在明显缺陷:模型可能为获取高分,生成“看似合理却回避实质”的回答,而非真正完成任务目标。

传统RLHF容易导致模型迎合评分机制,而非真正提升任务执行效果。

为应对这一问题,苹果团队在论文《Checklists Are More Effective than Reward Models for Aligning LLMs》中提出全新方案——基于清单的强化学习(RLCF)。

与模糊的“点赞/点踩”机制不同,RLCF要求模型依据明确的任务清单,逐项核查自身输出是否符合标准,并给出量化评分,从而实现更透明、可追溯的优化过程。

清单式评估机制如何运作?

RLCF的核心在于其结构化评估流程:

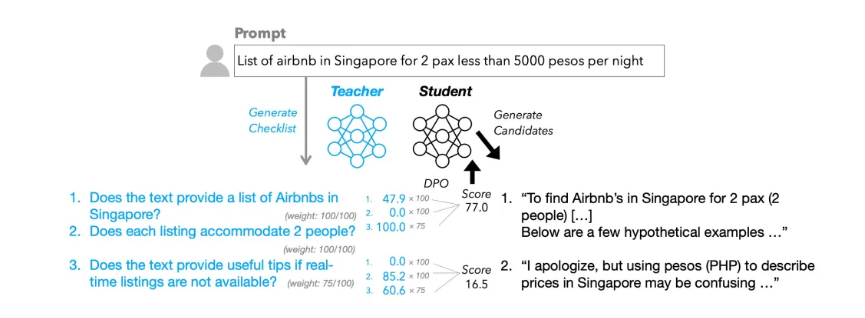

首先,系统借助高性能“教师模型”,为每一条用户指令自动生成一份含多项判断标准的清单。例如撰写报告任务中,清单可能包括“是否注明数据来源?”“是否分点陈述?”等可验证条目。

接着,“学生模型”生成的回答将逐项对照清单进行打分。每一项按重要性加权,最终汇总为综合奖励信号,用于模型微调。

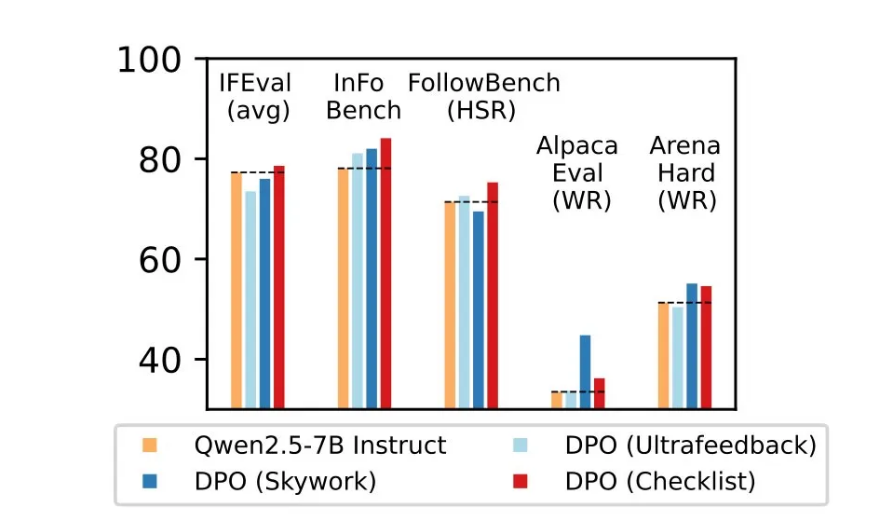

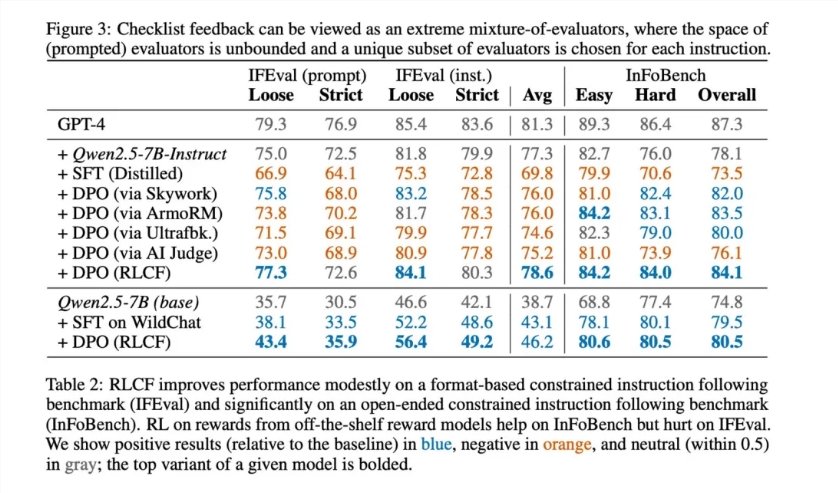

为验证效果,研究团队构建了包含13万条指令的WildChecklists数据集。实验结果显示,RLCF在五大主流评测基准(包括FollowBench、InFoBench等)中均表现优异。

RLCF是唯一在所有测试中全面超越基线模型的方法,部分任务性能提升达8.2%。

这表明,在处理需严谨流程的复杂任务时,清单式反馈具有显著优势。

应用前景与现存挑战

该方法为语言模型的任务对齐能力提供了新思路,尤其适用于智能助手、自动化代理等高精度指令执行场景。

随着AI日益融入日常生活,能否准确理解并执行复杂指令,已成为影响用户体验的关键因素。

但研究者也指出当前方法的三大局限:

- 主要适用于指令遵循型任务,未必适合创意生成等开放场景;

- 依赖高性能教师模型生成清单,可能增加计算成本;

- 聚焦于任务完成度,不具备安全性校准功能,需额外设计伦理约束机制。

尽管如此,RLCF的提出标志着语言模型从“迎合反馈”向“任务导向”转型的重要进展,为构建更可靠、可解释的AI系统提供了新范式。