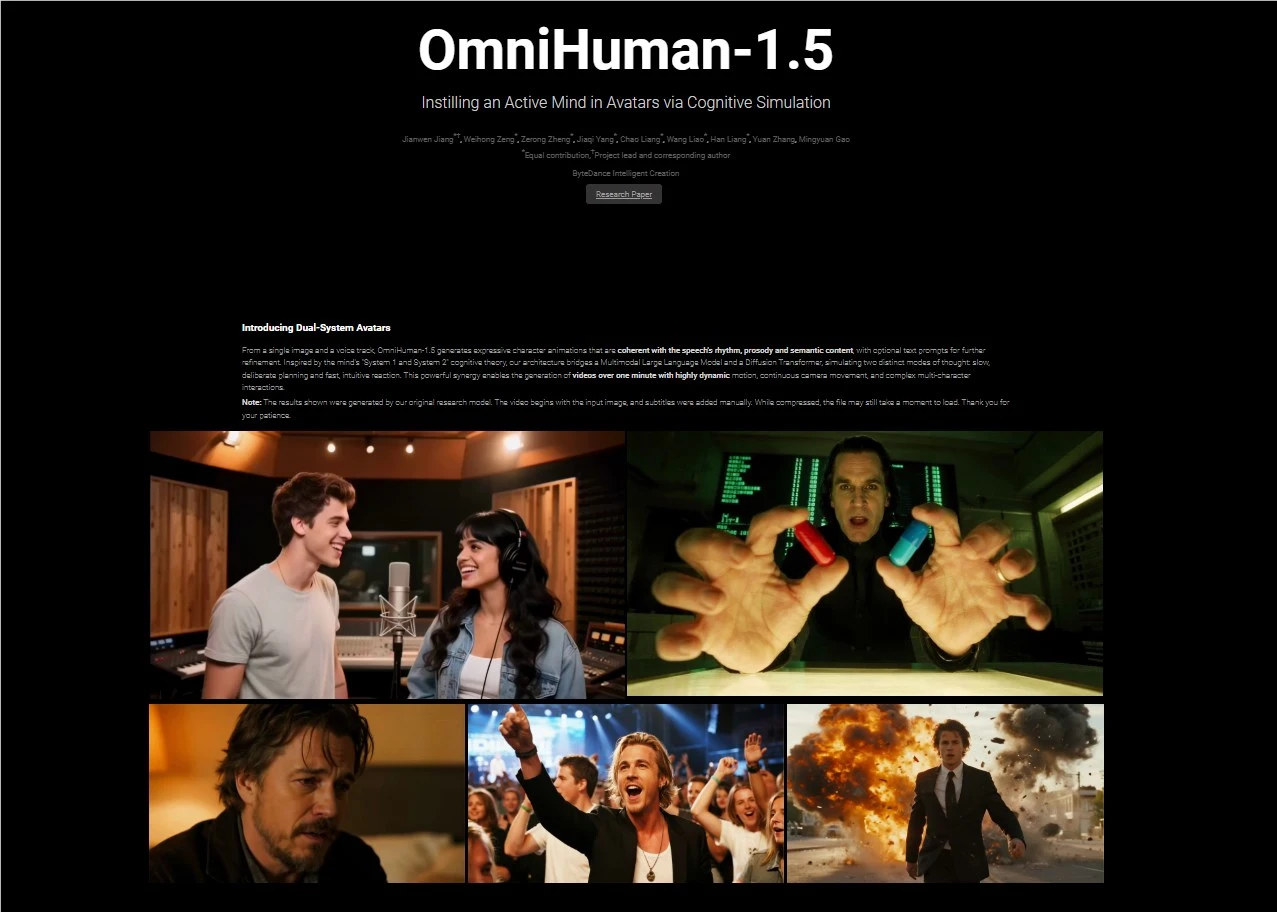

AI驱动的数字人技术再次迎来里程碑式突破!字节跳动旗下数字人研发团队正式发布全新多模态生成系统——OmniHuman-1.5。该方案仅需一张静态图像与一段音频输入,即可生成高度拟真的动态人物视频,凭借其在双人交互、长时连贯性、情绪表达等方面的显著提升,迅速在影视、直播、教育及营销领域引发广泛关注。

核心技术跃迁:

OmniHuman-1.5并非一次简单的版本升级,而是对数字人真实感表现力与跨场景适应力的深度重构。

- 动作生成更趋自然流畅:通过改进多模态运动条件的混合训练机制,系统能够精准捕捉音频中的语调起伏与节奏变化,并转化为符合人类行为习惯的肢体语言。无论是演讲中的手势强调,还是音乐节拍下的舞蹈动作,均实现“声动同步”的高还原度。

- 唇形匹配精度达行业新高:针对卡通形象或风格化角色,系统引入先进的风格迁移技术,在保持角色特征不变的前提下,优化口型与发音的对应逻辑,彻底解决以往“对口型错位”的痛点。

- 情感驱动赋予角色灵魂:系统可智能识别音频中的情绪色彩,如激动、低落或幽默,并据此调整人物的微表情与神态。例如,一段激昂的独白将触发角色紧锁眉头、目光坚定的反应,极大增强视频的情感穿透力。

关键功能突破:

- 支持双人对话场景生成:首次实现基于双路音频驱动的互动视频生成,适用于虚拟访谈、角色对戏甚至双人舞蹈,为内容创作者打开全新叙事空间。

- 超长视频稳定输出:采用创新的帧间一致性控制策略,可生成超过60秒的高质量连续视频,人物身份保持稳定,误差率低于3%,满足课程讲解、音乐视频等长内容需求。

落地应用场景广泛:

OmniHuman-1.5的技术革新正加速渗透多个行业,重塑内容生产方式:

- 影视工业:快速生成虚拟演员表演片段,降低绿幕拍摄与后期合成成本。已故艺人或动漫角色可“重返”银幕,实现跨时空演出。

- 虚拟直播:主播仅需上传个人照片,即可打造专属数字分身,配合实时语音输入,实现全天候自动化直播运营。

- 在线教育:将传统录播课升级为“有表情、有手势”的互动教学视频,显著提升学习沉浸感与知识吸收效率。

- 品牌营销:企业可定制专属虚拟代言人,根据不同产品调性切换形象风格,打造更具辨识度的IP化传播内容。

实际应用案例验证成效:

- 某知名游戏博主利用该技术将二次元角色“唤醒”,仅用角色立绘与配音文件,十分钟内完成动态解说视频制作,视频上线后播放量实现三倍增长。

- 一家在线教育平台部署“虚拟教师”系统,将抽象的物理原理通过手势演示与动态表情呈现,学员课程完成率提升近半。

前路挑战:通往普及之路仍有障碍待破

尽管OmniHuman-1.5已达到极高的拟真水准,研发团队仍指出当前存在三大技术瓶颈:

- 复杂动作控制不足:高难度动作如翻滚、跳跃可能出现失真,需引入更精细的物理动力学模型进行约束。

- 虚实交互真实感欠缺:人物与虚拟物体(如手持物品)的接触反馈仍显僵硬,亟需强化3D空间理解能力。

- 硬件门槛较高:生成4K级视频依赖高性能GPU,普通终端设备尚难承载。

未来发展方向:

字节跳动表示,下一步将重点推进模型轻量化与边缘部署,降低运行门槛;同时建立用户反馈闭环机制,通过收集“异常动作”标注数据,持续优化生成逻辑的合理性与自然度。

技术的意义,在于释放每个人的创造力

从OmniHuman-1到1.5,字节跳动不断证明:AI视频生成的终极使命,不是取代人类创作者,而是让创作变得人人可及。当一张照片、一段声音就能激活一个鲜活的数字形象,内容创作的边界已被彻底重构。

这场变革的潜力远未见顶。随着OmniHuman-1.5的逐步开放,我们或将见证更多温暖场景:普通人用AI纪念逝去的亲人,小众品牌借虚拟偶像破圈传播,教师用生动课件点燃课堂……真正的技术进步,终将以其温度,照亮人性最柔软的角落。

github地址: https://omnihuman-lab.github.io/v1_5/ (海外网站需要科学上网)