9 月 2 日讯,苹果公司再次在人工智能领域投下重磅技术——据科技资讯平台 9to5Mac 昨日披露,苹果已正式在 Hugging Face 平台上线其最新研发的 FastVLM 视觉语言模型,并开放浏览器试用通道,标志着其在端侧 AI 领域的进一步深耕。

此次推出的 FastVLM 模型主打“极速响应”,尤其在视频内容理解与字幕生成方面表现惊人。只要设备搭载 Apple Silicon 系列芯片,用户便能在本地环境中直接体验这一前沿 AI 技术,无需依赖高性能服务器或云端算力,真正实现“开箱即用”。

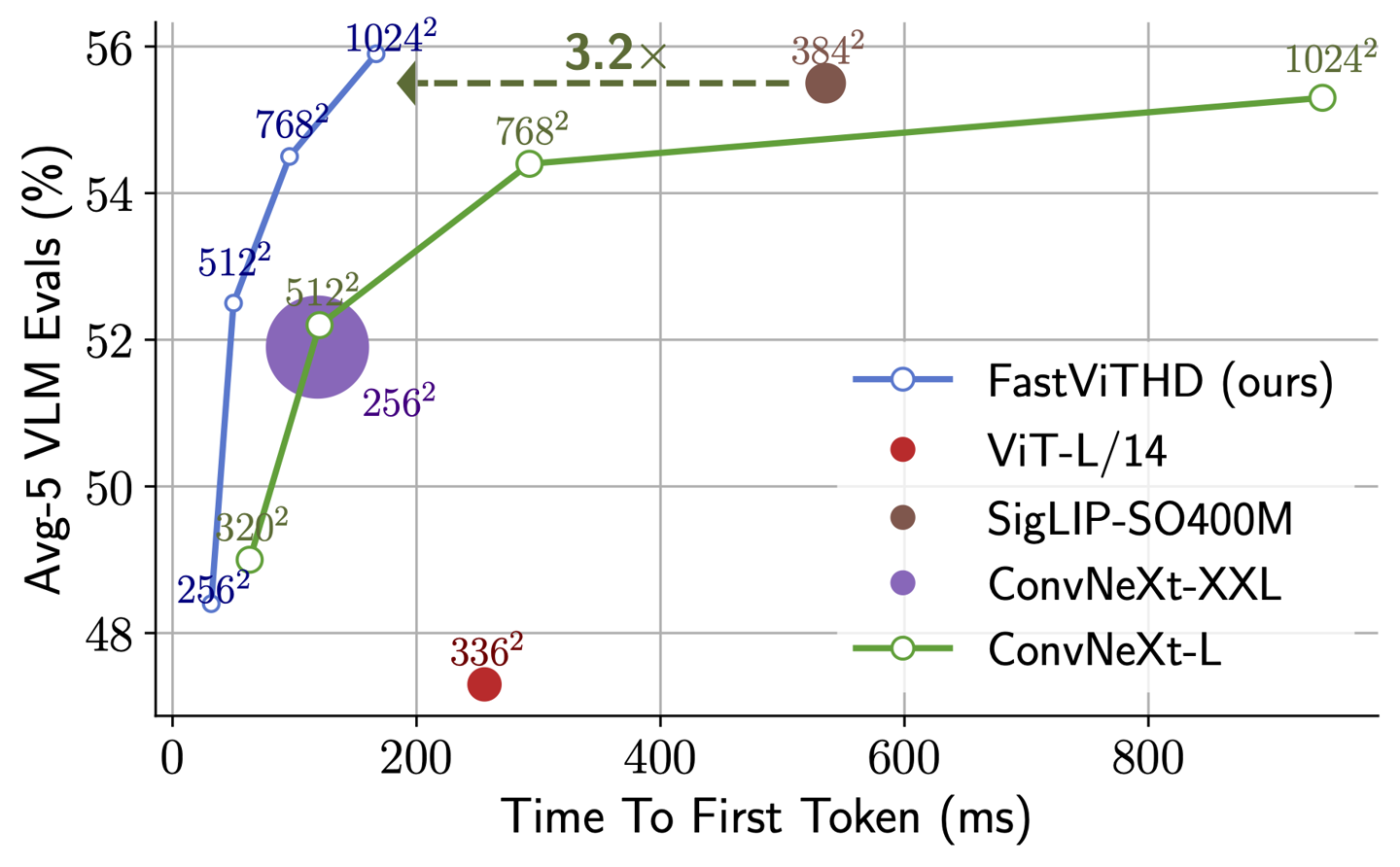

FastVLM 的核心竞争力在于其极高的运行效率与轻量化设计。该模型依托苹果自研的开源机器学习框架 MLX 进行深度优化,充分释放了 Apple Silicon 芯片的算力潜能。与市面上其他同类视觉语言模型相比,FastVLM 的模型体积压缩至约三分之一,却实现了高达 85 倍的视频字幕生成速度提升,堪称“效率革命”。

目前上线的是 FastVLM-0.5B 轻量版本,支持在浏览器中直接加载运行。据测试,在配备 16GB 内存的 M2 Pro 芯片 MacBook Pro 上,首次加载模型虽需数分钟时间,但一旦完成初始化,系统便能迅速解析视频画面,精准识别并描述其中的人物动作、环境细节、面部表情以及各类物体,展现出极强的语义理解能力。

尤为关键的是,整个处理过程完全在用户设备本地完成,所有数据均不上传至云端服务器。这一“端侧智能”设计不仅大幅降低了延迟,更从根本上保障了用户的隐私安全,契合苹果一贯强调的数据保护理念。

分析指出,FastVLM 的低延迟与本地化运行特性,使其在可穿戴设备领域具备广阔的应用前景。例如,在未来的智能眼镜或增强现实设备中,FastVLM 可实时解析用户视野中的场景,提供即时语音描述或交互提示,为视障人士或需要情境感知的用户带来革命性辅助体验。这项技术或将成为苹果下一代智能硬件生态的核心支撑之一,为“空间计算”时代注入更强 AI 动能。