9月23日,科技圈迎来一场由阿里云掀起的AI风暴,通义千问系列在深夜再度升级,一口气推出了全模态模型Qwen3-Omni、全新文本转语音系统Qwen3-TTS,以及图像编辑能力大幅跃升的Qwen-Image-Edit-2509,再次彰显其在多模态AI领域的领先布局。

此次最受瞩目的当属Qwen3-Omni,作为业内首个原生端到端的全模态AI模型,它打破了传统多模态系统在处理文本、图像、音频、视频时需反复切换的桎梏,实现了真正意义上的“一脑多能”。用户无论是上传一段视频、一张图片,还是输入语音指令,模型都能通过文本或自然语音实时流式输出结果,响应如行云流水,交互体验大幅提升。

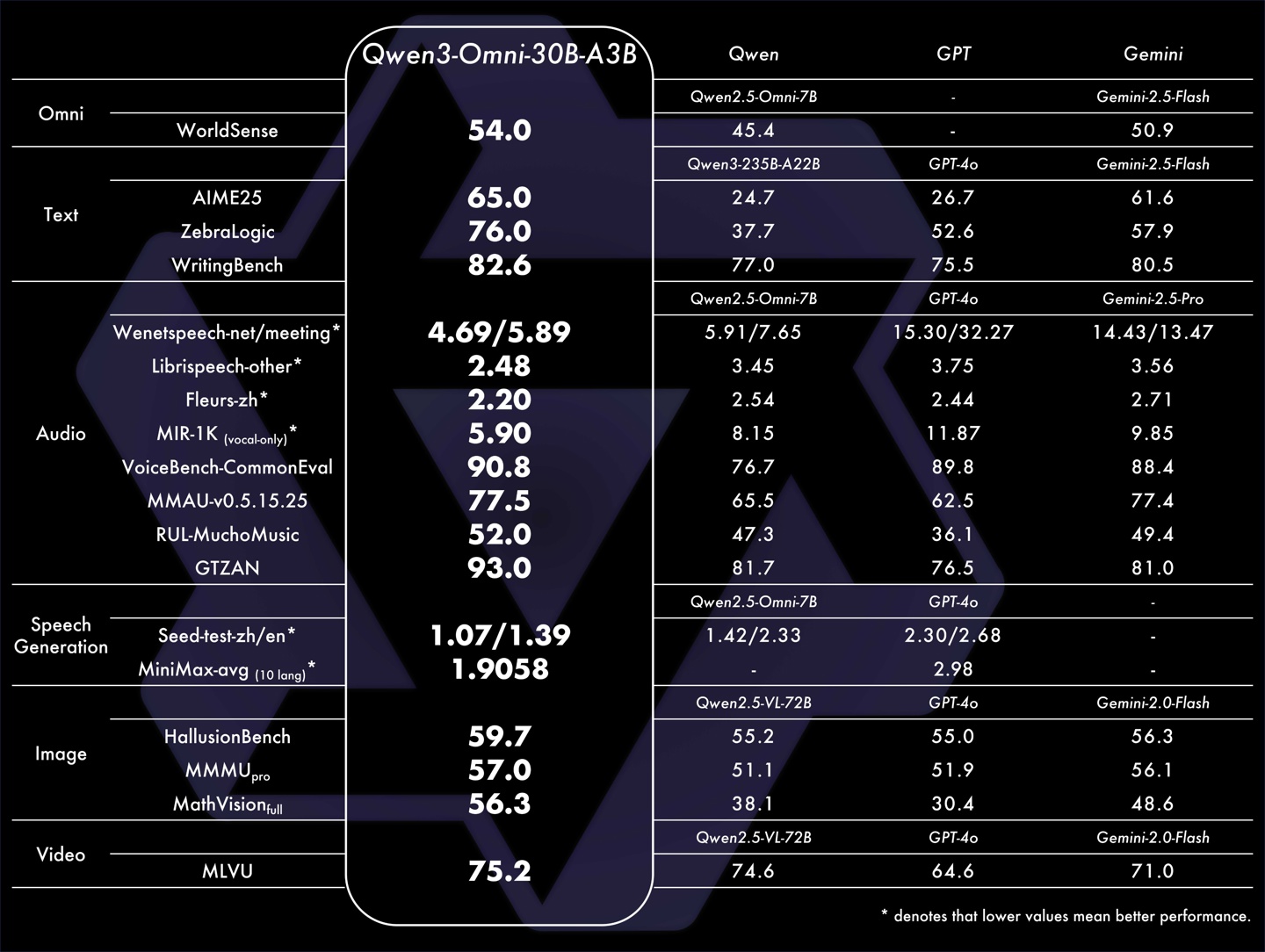

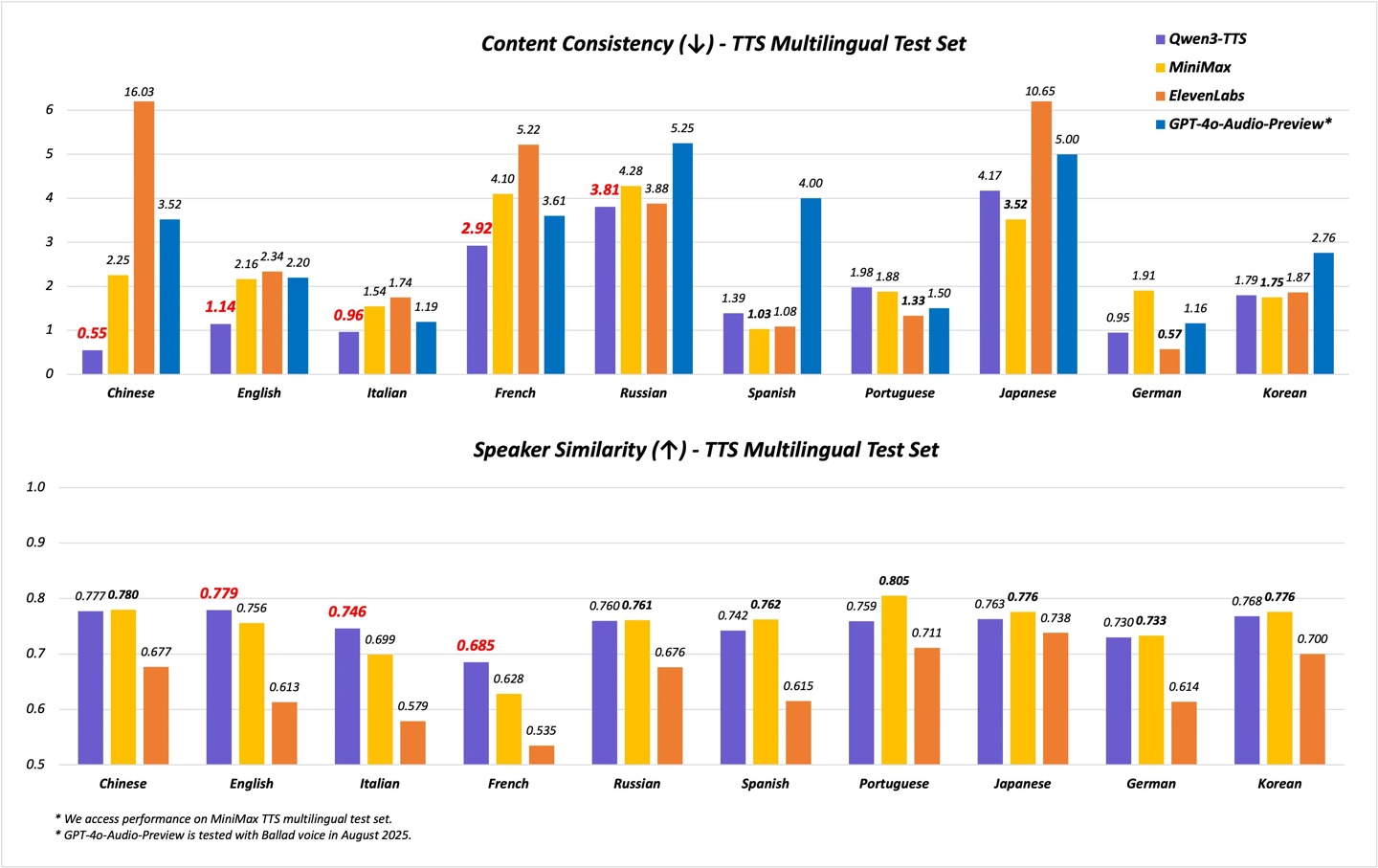

Qwen3-Omni之所以能实现跨模态的卓越表现,源于其强大的技术内核。它在36项音频与视频基准测试中,有22项达到当前最优水平,其中32项在开源模型中遥遥领先。尤其在自动语音识别(ASR)、语音理解及对话能力上,已可与谷歌Gemini 2.5 Pro相媲美。更令人惊叹的是其多语言支持能力,涵盖119种文本语言、19种语音输入语言和10种语音输出语言,真正实现全球无障碍沟通。

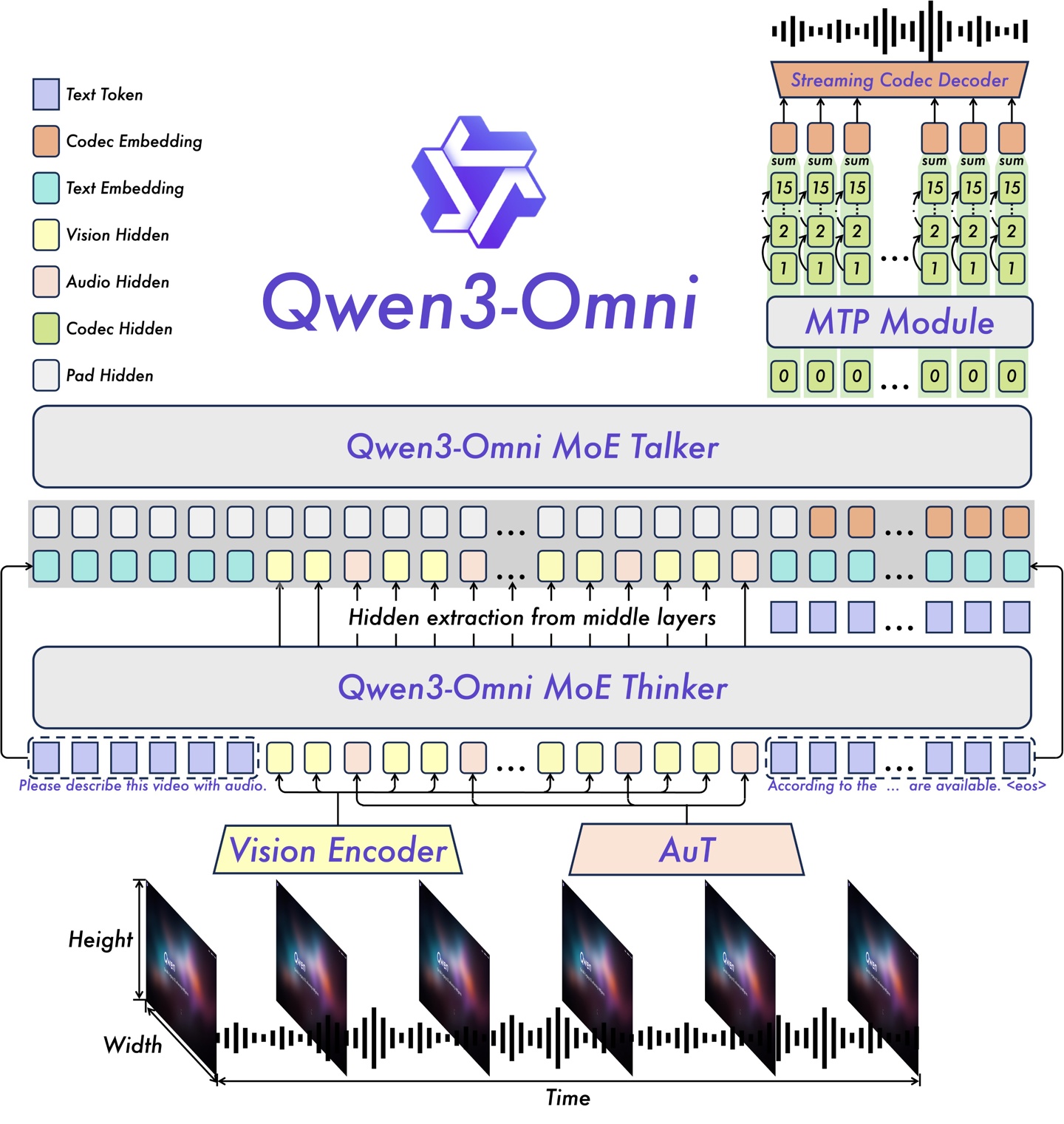

在架构设计上,Qwen3-Omni采用创新的“思考者–表达者”MoE(专家混合)结构,结合AuT预训练技术,确保模型具备强大的通用表征力。其多码本设计有效降低了延迟,实现低延迟流式交互,支持自然的对话轮转。用户还能通过系统提示词对模型行为进行精细调控,灵活适配各类应用场景。值得一提的是,其配套的音频描述模型Qwen3-Omni-30B-A3B-Captioner也已开源,以高细节还原度和低幻觉率填补了开源社区的技术空白。

在语音合成领域,Qwen3-TTS的表现同样亮眼。新版本支持17种音色,每种音色均可输出10种语言,不仅覆盖主流外语,更深度支持闽南语、吴语、粤语、四川话、北京话等八大中国方言,极大丰富了语音交互的本土化体验。性能方面,Qwen3-TTS-Flash在多项基准测试中超越SeedTTS、GPT-4o-Audio等竞品,尤其在语音稳定性和音色相似度上树立新标杆。数据显示,其单并发首包延迟低至97ms,满并发下RTF(实时因子)仅为0.51,效率远超前代。

图像编辑方面,Qwen-Image-Edit-2509在一致性上实现质的飞跃。它不仅支持多图输入编辑,如“人+产品”、“人+场景”的复杂组合,更在单图编辑中显著提升身份保留能力,无论是人像、产品还是文字编辑,都能保持高度一致性。新增的原生ControlNet支持,让用户能通过深度图、边缘图等精确控制生成效果,创作自由度更高。此次升级紧随字节跳动即梦4.0发布,显示出国内大模型在图像生成领域的激烈竞速。

目前,Qwen3-Omni、Qwen3-TTS、Qwen-Image-Edit-2509及Qwen3-Next系列80B-A3B模型均已全面开源,开发者可通过GitHub、Hugging Face、魔搭等平台获取,共同推动AI技术的普惠发展。