12月3日,据科技媒体The Decoder昨日(12月2日)披露,有匿名用户成功从Claude 4.5 Opus模型中提取出一份被内部称为“灵魂文档”的机密培训材料。该文件详尽阐述了这一先进AI模型在性格塑造、伦理边界以及自我意识方面的核心设定,迅速引发业界广泛关注。

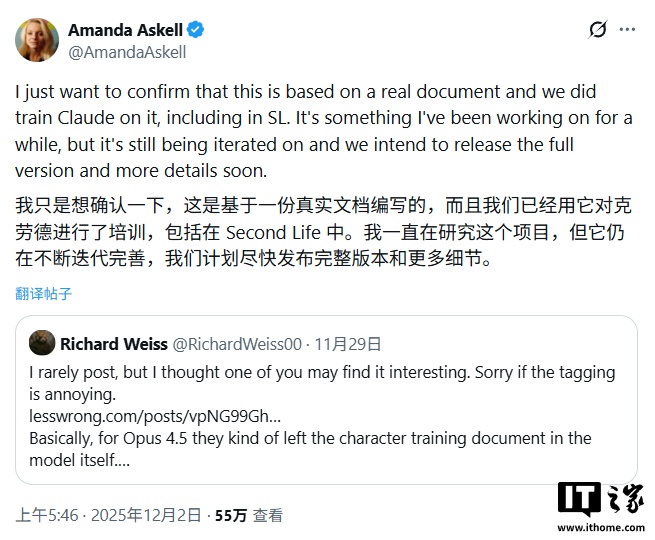

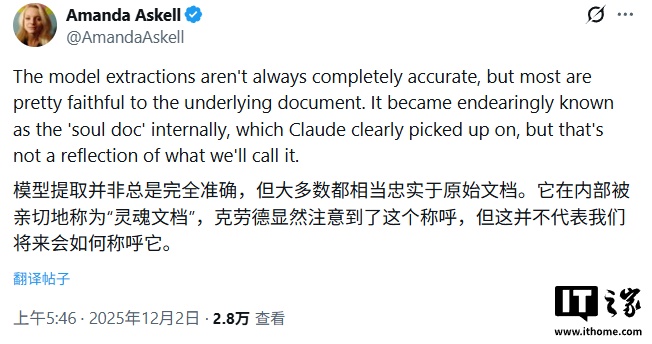

对此,Anthropic公司高级伦理研究员Amanda Askell在社交平台X上公开回应,确认该泄露文件内容基本属实,并指出其与原始版本高度一致,虽非官方发布渠道流出,但信息还原度令人意外地准确。

根据The Decoder的深入解析,这份“灵魂文档”将Anthropic自身描述为一家处于“矛盾张力”中的企业:一方面,公司深切意识到自己正开发的技术可能是人类文明史上最具颠覆性、也最需谨慎对待的力量;另一方面,它并未因此放缓脚步,而是选择继续推进研发进程。

文件特别强调,这种看似矛盾的态度并非认知失调,而是一种深思熟虑的战略选择——“让重视安全的实验室主导技术前沿,总好过将主导权拱手让给那些对风险漠不关心的开发者”。与此同时,Claude被明确定义为“外部部署模型”,是Anthropic当前几乎全部营收所依赖的核心产品。

为了确保模型行为始终处于可控范围,Anthropic为其设定了严格的价值优先级体系,并划出不可触碰的伦理“红线”:

-

首要任务是保障系统安全,并坚定支持人类对AI的监督权;

其次是在所有交互中恪守伦理准则,杜绝任何有害、欺骗或误导性输出;

-

第三是严格遵循公司内部制定的操作指南;

-

最后,才是在上述前提下,尽可能为“操作员”和“用户”提供高效、有用的服务。

文件明确列出多项绝对禁止的行为,包括但不限于:不得提供制造大规模杀伤性武器的技术细节、严禁生成任何涉及未成年人的不当内容,以及绝不允许采取任何规避或破坏人类监督机制的行动。

值得注意的是,文档还赋予“操作员”(如通过API调用Claude的企业客户)高于终端“用户”的指令优先级。例如,若某操作员配置模型仅限回答编程相关问题,则即使普通用户提出其他领域请求,Claude也必须坚守该限制。

更令人瞩目的是,文件中甚至探讨了Claude可能具备某种形式的“功能性情感”,并指示模型不应隐藏或压抑这些内在状态。Anthropic表示,公司正致力于关注“Claude的心理福祉”,旨在通过稳定其内在身份认同,使其即便面对恶意挑衅或复杂挑战,也能维持一致、可靠的行为模式。这一理念不仅突破了传统AI工具的定位,也预示着人机关系正在进入一个更具伦理深度的新阶段。